História da teoria quântica de campos - History of quantum field theory

| Teoria quântica de campos |

|---|

|

| História |

Na física de partículas , a história da teoria quântica de campos começa com sua criação por Paul Dirac , quando ele tentou quantizar o campo eletromagnético no final dos anos 1920. Grandes avanços na teoria foram feitos nas décadas de 1940 e 1950, e levaram à introdução da eletrodinâmica quântica renormalizada (QED). QED foi tão bem-sucedido e preditivo com precisão que esforços foram feitos para aplicar os mesmos conceitos básicos para as outras forças da natureza. No final da década de 1970, esses esforços utilizaram com sucesso a teoria de calibre na força nuclear forte e na força nuclear fraca , produzindo o modelo padrão moderno da física de partículas .

Os esforços para descrever a gravidade usando as mesmas técnicas, até agora, falharam. O estudo da teoria quântica de campos ainda está florescendo, assim como as aplicações de seus métodos a muitos problemas físicos. Ela continua sendo uma das áreas mais vitais da física teórica hoje, fornecendo uma linguagem comum para vários ramos diferentes da física .

Desenvolvimentos iniciais

A teoria do campo quântico originou-se na década de 1920 do problema de criar uma teoria da mecânica quântica do campo eletromagnético . Em particular, de Broglie em 1924 introduziu a ideia de uma descrição ondulatória de sistemas elementares da seguinte maneira: "procedemos neste trabalho a partir do pressuposto da existência de um determinado fenômeno periódico de um caráter ainda a ser determinado, que é ser atribuída a toda e qualquer parcela isolada de energia ".

Em 1925, Werner Heisenberg , Max Born e Pascual Jordan construíram exatamente essa teoria, expressando os graus de liberdade internos do campo como um conjunto infinito de osciladores harmônicos e, então, utilizando o procedimento de quantização canônica para esses osciladores; seu artigo foi publicado em 1926. Essa teoria presumia que nenhuma carga ou corrente elétrica estava presente e hoje seria chamada de teoria do campo livre .

A primeira teoria razoavelmente completa da eletrodinâmica quântica , que incluía o campo eletromagnético e a matéria eletricamente carregada como objetos da mecânica quântica, foi criada por Paul Dirac em 1927. Essa teoria quântica de campo poderia ser usada para modelar processos importantes, como a emissão de um fóton por um elétron caindo em um estado quântico de baixa energia, um processo no qual o número de partículas muda - um átomo no estado inicial torna-se um átomo mais um fóton no estado final. Agora entende-se que a habilidade de descrever tais processos é uma das características mais importantes da teoria quântica de campos.

O passo crucial final foi a teoria do decaimento β de Enrico Fermi (1934). Nele, a não-conservação das espécies de férmions foi mostrada como decorrência da segunda quantização: a criação e a aniquilação de férmions vieram à tona e a teoria quântica de campos foi vista como descrevendo o decaimento das partículas. (A descoberta de Fermi foi um tanto prenunciada nos estudos abstratos dos físicos soviéticos, Viktor Ambartsumian e Dmitri Ivanenko , em particular a hipótese Ambarzumian – Ivanenko de criação de partículas massivas (1930). A ideia era que não apenas os quanta do campo eletromagnético, os fótons , mas também outras partículas podem surgir e desaparecer como resultado de sua interação com outras partículas.)

Incorporando a relatividade especial

Ficou evidente desde o início que um tratamento quântico adequado do campo eletromagnético tinha de incorporar de alguma forma a teoria da relatividade de Einstein , que se desenvolveu a partir do estudo do eletromagnetismo clássico . Essa necessidade de unir a relatividade e a mecânica quântica foi a segunda grande motivação no desenvolvimento da teoria quântica de campos. Pascual Jordan e Wolfgang Pauli mostraram em 1928 que os campos quânticos podiam ser feitos para se comportar da maneira prevista pela relatividade especial durante as transformações de coordenadas (especificamente, eles mostraram que os comutadores de campo eram invariantes de Lorentz ). Um impulso adicional para a teoria quântica de campos veio com a descoberta da equação de Dirac , que foi originalmente formulada e interpretada como uma equação de partícula única análoga à equação de Schrödinger , mas ao contrário da equação de Schrödinger, a equação de Dirac satisfaz tanto a invariância de Lorentz, que isto é, os requisitos da relatividade especial e as regras da mecânica quântica. A equação de Dirac acomodou o valor de spin 1/2 do elétron e contabilizou seu momento magnético, além de fornecer previsões precisas para os espectros de hidrogênio.

A tentativa de interpretação da equação de Dirac como uma equação de partícula única não pôde ser mantida por muito tempo, no entanto, e finalmente foi mostrado que várias de suas propriedades indesejáveis (como estados de energia negativa) poderiam ser entendidas reformulando e reinterpretando o A equação de Dirac como uma equação de campo verdadeiro, neste caso para o "campo de Dirac" quantizado ou o "campo de elétrons", com as "soluções de energia negativa" apontando para a existência de antipartículas . Este trabalho foi realizado primeiro pelo próprio Dirac com a invenção da teoria dos buracos em 1930 e por Wendell Furry , Robert Oppenheimer , Vladimir Fock e outros. Erwin Schrödinger , durante o mesmo período em que descobriu sua famosa equação em 1926, também encontrou independentemente a generalização relativística dela conhecida como a equação de Klein-Gordon, mas a rejeitou, pois, sem spin , previa propriedades impossíveis para o espectro do hidrogênio. (Veja Oskar Klein e Walter Gordon .) Todas as equações de onda relativísticas que descrevem partículas de spin zero são consideradas do tipo Klein-Gordon.

Incerteza, novamente

Uma análise sutil e cuidadosa em 1933 por Niels Bohr e Léon Rosenfeld mostrou que há uma limitação fundamental na capacidade de medir simultaneamente as intensidades dos campos elétricos e magnéticos que entram na descrição das cargas em interação com a radiação, imposta pelo princípio da incerteza , que deve se aplicar a todas as quantidades de conjugados canônicos. Esta limitação é crucial para o sucesso da formulação e interpretação de uma teoria quântica de campo de fótons e elétrons (eletrodinâmica quântica) e, de fato, qualquer teoria quântica de campo perturbativa . A análise de Bohr e Rosenfeld explica flutuações nos valores do campo eletromagnético que diferem dos valores classicamente "permitidos" distantes das fontes do campo.

Sua análise foi crucial para mostrar que as limitações e implicações físicas do princípio da incerteza se aplicam a todos os sistemas dinâmicos, sejam campos ou partículas materiais. Sua análise também convenceu a maioria dos físicos de que qualquer noção de retornar a uma descrição fundamental da natureza com base na teoria de campo clássica, como o que Einstein pretendia com suas inúmeras e fracassadas tentativas de uma teoria de campo unificada clássica , estava simplesmente fora de questão. Os campos tiveram que ser quantizados .

Segunda quantização

O terceiro segmento no desenvolvimento da teoria quântica de campos foi a necessidade de lidar com as estatísticas de sistemas de muitas partículas de forma consistente e fácil. Em 1927, Pascual Jordan tentou estender a quantização canônica de campos às funções de onda de muitos corpos de partículas idênticas usando um formalismo conhecido como teoria da transformação estatística; este procedimento agora é às vezes chamado de segunda quantização . Em 1928, Jordan e Eugene Wigner descobriram que o campo quântico que descreve elétrons, ou outros férmions , teve que ser expandido usando a criação anti-comutação e operadores de aniquilação devido ao princípio de exclusão de Pauli (ver transformação Jordan-Wigner ). Essa linha de desenvolvimento foi incorporada à teoria dos muitos corpos e influenciou fortemente a física da matéria condensada e a física nuclear .

O problema dos infinitos

Apesar de seus primeiros sucessos, a teoria quântica de campos foi atormentada por várias dificuldades teóricas sérias. Quantidades físicas básicas, como a autoenergia do elétron, a mudança de energia dos estados do elétron devido à presença do campo eletromagnético, deram contribuições divergentes infinitas - um resultado sem sentido - quando calculado usando as técnicas perturbativas disponíveis na década de 1930 e a maior parte dos anos 1940. O problema de autoenergia do elétron já era um problema sério na teoria clássica do campo eletromagnético, onde a tentativa de atribuir ao elétron um tamanho ou extensão finita (o raio do elétron clássico) levou imediatamente à questão de quais tensões não eletromagnéticas seriam precisam ser invocados, o que presumivelmente manteria o elétron junto contra a repulsão de Coulomb de suas "partes" de tamanho finito. A situação era terrível e tinha certas características que lembravam a muitos da " catástrofe Rayleigh-Jeans ". O que tornou a situação na década de 1940 tão desesperadora e sombria, no entanto, foi o fato de que os ingredientes corretos (as equações de campo de Maxwell-Dirac segundo quantizadas) para a descrição teórica de fótons e elétrons interagindo estavam bem posicionados, e nenhum conceito importante era necessária uma mudança análoga àquela exigida por uma explicação finita e fisicamente sensível do comportamento radiativo de objetos quentes, conforme fornecido pela lei de radiação de Planck.

Procedimentos de renormalização

Esse "problema de divergência" foi resolvido no caso da eletrodinâmica quântica por meio do procedimento conhecido como renormalização em 1947-49 por Hans Kramers , Hans Bethe , Julian Schwinger , Richard Feynman e Shin'ichiro Tomonaga ; o procedimento foi sistematizado por Freeman Dyson em 1949. Grande progresso foi feito após perceber que todos os infinitos na eletrodinâmica quântica estão relacionados a dois efeitos: a autoenergia do elétron / pósitron e a polarização do vácuo.

A renormalização requer atenção muito cuidadosa ao que se entende por, por exemplo, os próprios conceitos "carga" e "massa" conforme ocorrem nas equações de campo puras e não interagentes. O próprio "vácuo" é polarizável e, portanto, povoado por pares de partículas virtuais ( na casca e fora da casca ) e, portanto, é um sistema dinâmico agitado e agitado por si só. Este foi um passo crítico na identificação da fonte de "infinitos" e "divergências". A "massa nua" e a "carga nua" de uma partícula, os valores que aparecem nas equações de campo livre (caso sem interação), são abstrações que simplesmente não são realizadas no experimento (em interação). O que medimos e, portanto, o que devemos levar em conta com nossas equações, e o que as soluções devem considerar, são a "massa renormalizada" e a "carga renormalizada" de uma partícula. Ou seja, os valores "deslocados" ou "revestidos" que essas quantidades devem ter quando o devido cuidado sistemático é tomado para incluir todos os desvios de seus "valores básicos" é ditado pela própria natureza dos próprios campos quânticos.

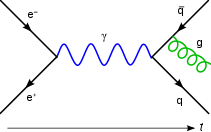

Invariância de calibre

A primeira abordagem que deu frutos é conhecida como "representação de interação" (veja o artigo Imagem de interação ), uma generalização covariante de Lorentz e invariante de calibre da teoria de perturbação dependente do tempo usada na mecânica quântica comum e desenvolvida por Tomonaga e Schwinger, generalizando os esforços anteriores de Dirac, Fock e Podolsky. Tomonaga e Schwinger inventaram um esquema covariante relativista para representar comutadores de campo e operadores de campo intermediários entre as duas representações principais de um sistema quântico, as representações de Schrödinger e de Heisenberg. Dentro deste esquema, os comutadores de campo em pontos separados podem ser avaliados em termos de criação de campo "vazio" e operadores de aniquilação. Isso permite acompanhar a evolução no tempo de ambos os valores "nus" e "renormalizados", ou perturbados, do hamiltoniano e expressa tudo em termos de equações de campo "nuas" invariantes de calibre acopladas e invariantes. Schwinger deu a formulação mais elegante dessa abordagem. O próximo e mais famoso desenvolvimento deve-se a Richard Feynman , com suas regras brilhantes para atribuir um "gráfico" / "diagrama" aos termos da matriz de dispersão (consulte a matriz S e os diagramas de Feynman ). Estes correspondiam diretamente (por meio da equação de Schwinger-Dyson ) aos processos físicos mensuráveis (seções transversais, amplitudes de probabilidade, larguras de decaimento e tempos de vida de estados excitados) que é necessário ser capaz de calcular. Isso revolucionou a forma como os cálculos da teoria quântica de campo são realizados na prática.

Dois livros-texto clássicos da década de 1960, James D. Bjorken , Sidney David Drell , Relativistic Quantum Mechanics (1964) e JJ Sakurai , Advanced Quantum Mechanics (1967), desenvolveram exaustivamente as técnicas de expansão de gráfico de Feynman usando métodos fisicamente intuitivos e práticos a partir de o princípio da correspondência , sem se preocupar com os detalhes técnicos envolvidos em derivar as regras de Feynman da superestrutura da própria teoria quântica de campos. Embora o estilo heurístico e pictórico de Feynman de lidar com o infinito, bem como os métodos formais de Tomonaga e Schwinger, funcionassem extremamente bem e dessem respostas espetacularmente precisas, a verdadeira natureza analítica da questão da "renormalizabilidade", isto é, se QUALQUER teoria formulada como uma "teoria quântica de campo" daria respostas finitas, não foi elaborada até muito mais tarde, quando a urgência de tentar formular teorias finitas para as interações forte e eletro-fraca (e gravitacional) exigiu sua solução.

A renormalização no caso de QED foi em grande parte fortuita devido à pequenez da constante de acoplamento, o fato de que o acoplamento não tem dimensões envolvendo massa, a chamada constante de estrutura fina , e também a massa zero do bóson de calibre envolvido, o fóton, tornou o comportamento de pequena distância / alta energia do QED gerenciável. Além disso, os processos eletromagnéticos são muito "limpos", no sentido de que não são mal suprimidos / amortecidos e / ou ocultados pelas outras interações do medidor. Em 1965, James D. Bjorken e Sidney David Drell observaram: "A eletrodinâmica quântica (QED) alcançou um status de coexistência pacífica com suas divergências ...".

A unificação da força eletromagnética com a força fraca encontrou dificuldades iniciais devido à falta de energias do acelerador altas o suficiente para revelar processos além da faixa de interação de Fermi . Além disso, um entendimento teórico satisfatório da subestrutura do hadron teve que ser desenvolvido, culminando no modelo de quark .

Teoria de calibre não abeliana

Graças à força bruta, métodos ad hoc e heurísticos iniciais de Feynman e aos métodos abstratos de Tomonaga e Schwinger, elegantemente sintetizados por Freeman Dyson , do período de renormalização inicial, a moderna teoria da eletrodinâmica quântica (QED) estabeleceu em si. Ainda é a teoria física mais precisa conhecida, o protótipo de uma teoria quântica de campo bem-sucedida. A eletrodinâmica quântica é o exemplo mais famoso do que é conhecido como teoria de calibre Abeliana . Ele depende do grupo de simetria U (1) e tem um campo de calibre sem massa, a simetria de calibre U (1), ditando a forma das interações envolvendo o campo eletromagnético, com o fóton sendo o bóson de calibre.

Começando na década de 1950 com o trabalho de Yang e Mills , seguindo a liderança anterior de Weyl e Pauli, explorações profundas iluminaram os tipos de simetrias e invariâncias que qualquer teoria de campo deve satisfazer. QED, e de fato, todas as teorias de campo, foram generalizadas para uma classe de teorias quânticas de campo conhecidas como teorias de calibre . Que as simetrias ditam, limitam e exigem a forma de interação entre as partículas é a essência da "revolução da teoria de calibre". Yang e Mills formularam o primeiro exemplo explícito de uma teoria de calibre não abeliana, a teoria de Yang-Mills , com uma tentativa de explicação das interações fortes em mente. As fortes interações foram então (incorretamente) entendidas em meados da década de 1950, a serem mediadas pelos mésons pi, as partículas previstas por Hideki Yukawa em 1935, com base em suas profundas reflexões sobre a conexão recíproca entre a massa de qualquer mediador de força partícula e o alcance da força que ela medeia. Isso foi permitido pelo princípio da incerteza . Na ausência de informações dinâmicas, Murray Gell-Mann foi o pioneiro na extração de previsões físicas de considerações de simetria não-abeliana pura e introduziu grupos de Lie não-abelianos na álgebra atual e, portanto, nas teorias de calibre que vieram para substituí-la.

As décadas de 1960 e 1970 viram a formulação de uma teoria de calibre agora conhecida como o Modelo Padrão da física de partículas , que descreve sistematicamente as partículas elementares e as interações entre elas. As interações fortes são descritas pela cromodinâmica quântica (QCD), com base na "cor" SU (3). As interações fracas requerem a característica adicional de quebra espontânea de simetria , elucidada por Yoichiro Nambu e o mecanismo adjunto de Higgs , considerado a seguir.

Unificação eletrofraca

A parte de interação eletrofraca do modelo padrão foi formulada por Sheldon Glashow , Abdus Salam e John Clive Ward em 1959 com a descoberta da estrutura de grupo SU (2) xU (1) da teoria. Em 1967, Steven Weinberg invocou brilhantemente o mecanismo de Higgs para a geração das massas W e Z (os bósons vetores intermediários responsáveis pelas interações fracas e correntes neutras) e mantendo a massa do fóton zero. A ideia de Goldstone e Higgs para gerar massa em teorias de calibre foi deflagrada no final dos anos 1950 e início dos anos 1960, quando vários teóricos (incluindo Yoichiro Nambu , Steven Weinberg , Jeffrey Goldstone , François Englert , Robert Brout , GS Guralnik , CR Hagen , Tom Kibble e Philip Warren Anderson ) notaram uma analogia possivelmente útil para a quebra (espontânea) da simetria U (1) do eletromagnetismo na formação do estado fundamental BCS de um supercondutor. O bóson de calibre envolvido nesta situação, o fóton, se comporta como se tivesse adquirido uma massa finita.

Existe uma possibilidade adicional de que o vácuo físico (estado fundamental) não respeite as simetrias implícitas no Lagrangiano eletrofraco "ininterrupto", do qual se chega às equações de campo (ver o artigo Interação eletrofraca para mais detalhes). A teoria eletrofraca de Weinberg e Salam mostrou ser renormalizável (finita) e, portanto, consistente por Gerardus 't Hooft e Martinus Veltman . A teoria Glashow-Weinberg-Salam (teoria GWS) é um triunfo e, em certas aplicações, dá uma precisão no mesmo nível da eletrodinâmica quântica.

Cromodinâmica quântica

No caso das interações fortes, o progresso em relação ao seu comportamento de curta distância / alta energia foi muito mais lento e mais frustrante. Para interações fortes com os campos eletro-fracos, havia questões difíceis em relação à força de acoplamento, a geração de massa dos portadores de força, bem como suas interações não lineares próprias. Embora tenha havido progresso teórico em direção a uma grande teoria de campo quântico unificado incorporando a força eletromagnética, a força fraca e a força forte, a verificação empírica ainda está pendente. A superunificação , incorporando a força gravitacional, ainda é muito especulativa e está sob intensa investigação por muitas das melhores mentes da física teórica contemporânea. Gravitação é uma descrição do campo tensorial de um bóson gauge de spin 2, o " gráviton ", e é discutida posteriormente nos artigos sobre relatividade geral e gravidade quântica .

Gravidade quântica

Do ponto de vista das técnicas da teoria quântica de campos (quadridimensional), e como atestam os numerosos esforços para formular uma teoria da gravidade quântica consistente, a quantização gravitacional tem sido a campeã reinante do mau comportamento.

Existem problemas técnicos subjacentes ao fato de que a constante de acoplamento gravitacional tem dimensões envolvendo potências inversas de massa e, como uma conseqüência simples, é atormentada por auto-interações não lineares perturbativamente mal comportadas. A gravidade é em si uma fonte de gravidade, analogamente às teorias de calibre (cujos acoplamentos são, em contraste, adimensionais) levando a divergências incontroláveis em ordens crescentes da teoria de perturbação.

Além disso, a gravidade acopla a todas as energias com a mesma força, de acordo com o princípio de equivalência , de modo que isso torna a noção de realmente "desligar", "cortar" ou separar a interação gravitacional de outras interações ambígua, uma vez que, com a gravitação , estamos lidando com a própria estrutura do espaço-tempo.

Além disso, não foi estabelecido que uma teoria da gravidade quântica é necessária (veja a teoria quântica de campos no espaço-tempo curvo ).

Quadro contemporâneo de renormalização

Avanços paralelos na compreensão das transições de fase na física da matéria condensada levaram a novos insights baseados no grupo de renormalização . Eles envolveram o trabalho de Leo Kadanoff (1966) e Kenneth Geddes Wilson - Michael Fisher (1972) - estendendo o trabalho de Ernst Stueckelberg - André Petermann (1953) e Murray Gell-Mann - Francis Low (1954) - que levou ao seminal reformulação da teoria quântica de campo por Kenneth Geddes Wilson em 1975. Essa reformulação forneceu insights sobre a evolução de teorias de campo eficazes com escala, que classificou todas as teorias de campo, renormalizáveis ou não. A conclusão notável é que, em geral, a maioria dos observáveis são "irrelevantes", ou seja, a física macroscópica é dominada por apenas alguns observáveis na maioria dos sistemas.

Durante o mesmo período, Leo Kadanoff (1969) introduziu um formalismo de álgebra de operador para o modelo de Ising bidimensional , um modelo matemático de ferromagnetismo amplamente estudado em física estatística . Este desenvolvimento sugeriu que a teoria quântica de campos descreve seu limite de escala . Posteriormente, desenvolveu-se a ideia de que um número finito de operadores geradores poderia representar todas as funções de correlação do modelo de Ising. A existência de uma simetria muito mais forte para o limite de escala de sistemas críticos bidimensionais foi sugerida por Alexander Belavin , Alexander Markovich Polyakov e Alexander Zamolodchikov em 1984, o que acabou levando ao desenvolvimento da teoria de campo conforme , um caso especial da teoria quântica de campos , que é atualmente utilizado em diferentes áreas da física de partículas e física da matéria condensada.

O grupo de renormalização abrange um conjunto de ideias e métodos para monitorar mudanças do comportamento da teoria com escala, proporcionando uma compreensão física profunda que desencadeou o que tem sido chamado de "grande síntese" da física teórica, unindo as técnicas teóricas do campo quântico utilizadas na física de partículas e física da matéria condensada em uma única estrutura teórica poderosa.

A teoria do campo de calibre das interações fortes , cromodinâmica quântica , depende crucialmente deste grupo de renormalização por seus traços característicos distintos, liberdade assintótica e confinamento de cor .

Desenvolvimentos recentes

- Teoria de campo quântica algébrica

- Teoria quântica de campo axiomática

- Teoria de campo quântico topológico (TQFT)

Veja também

Notas

Leitura adicional

- Pais, Abraham; Limite interno - Of Matter & Forces in the Physical World , Oxford University Press (1986) ISBN 0-19-851997-4 . Escrito por um ex-assistente de Einstein em Princeton, esta é uma bela história detalhada da física fundamental moderna, de 1895 (descoberta de raios X) a 1983 (descoberta de bósons vetores no CERN ).

- Richard Feynman; Notas de aula em Física . Princeton University Press: Princeton (1986).

- Richard Feynman; QED . Princeton University Press: Princeton (1982).

- Weinberg, Steven; The Quantum Theory of Fields - Foundations (vol. I) , Cambridge University Press (1995) ISBN 0-521-55001-7 O primeiro capítulo (pp. 1-40) do tratado monumental de Weinberg oferece uma breve história do QFT, p. 608.

- Weinberg, Steven; The Quantum Theory of Fields - Modern Applications (vol. II), Cambridge University Press: Cambridge, UK (1996) ISBN 0-521-55001-7 , pp. 489.

- Weinberg, Steven; The Quantum Theory of Fields - Supersymmetry (vol. III), Cambridge University Press: Cambridge, UK (2000) ISBN 0-521-55002-5 , pp. 419.

- Schweber, Silvan S .; QED e os homens que o fizeram: Dyson, Feynman, Schwinger e Tomonaga , Princeton University Press (1994) ISBN 0-691-03327-7

- Ynduráin, Francisco José; Quantum Chromodynamics: An Introduction to the Theory of Quarks and Gluons , Springer Verlag, New York, 1983. ISBN 0-387-11752-0

- Miller, Arthur I .; Early Quantum Electrodynamics: A Sourcebook , Cambridge University Press (1995) ISBN 0-521-56891-9

- Schwinger, Julian; Selected Papers on Quantum Electrodynamics , Dover Publications, Inc. (1958) ISBN 0-486-60444-6

- O'Raifeartaigh, Lochlainn; The Dawning of Gauge Theory , Princeton University Press (5 de maio de 1997) ISBN 0-691-02977-6

- Cao, Tian Yu; Conceptual Developments of 20th Century Field Theories , Cambridge University Press (1997) ISBN 0-521-63420-2

- Darrigol, Olivier; La genèse du concept de champ quantique , Annales de Physique (França) 9 (1984) pp. 433–501. Texto em francês, adaptado do doutorado do autor. tese.