Inteligência geral artificial - Artificial general intelligence

| Parte de uma série sobre |

| Inteligência artificial |

|---|

Inteligência geral artificial ( AGI ) é a capacidade hipotética de um agente inteligente de compreender ou aprender qualquer tarefa intelectual que um ser humano possa. É o objetivo principal de algumas pesquisas sobre inteligência artificial e um tópico comum em ficção científica e estudos futuros . AGI também pode ser referido como IA forte , IA completa ou ação inteligente geral (embora fontes acadêmicas reservem o termo "IA forte" para programas de computador que experimentam senciência ou consciência .)

Em contraste com a IA forte, a IA fraca ou "IA estreita" não se destina a ter habilidades cognitivas gerais ; em vez disso, IA fraca é qualquer programa projetado para resolver exatamente um problema. (Fontes acadêmicas reservam "IA fraca" para programas que não experimentam consciência ou têm uma mente no mesmo sentido que as pessoas.)

Em 2017, mais de quarenta organizações estão pesquisando ativamente a AGI.

Características

Vários critérios de inteligência foram propostos (o mais famoso é o teste de Turing ), mas, até o momento, não existe uma definição que satisfaça a todos.

Traços inteligentes

No entanto, não é amplo acordo entre os pesquisadores de inteligência artificial que a inteligência é necessária para fazer o seguinte: razão , a estratégia de uso, resolver quebra-cabeças, e julgamentos make sob incerteza ; representar conhecimento , incluindo conhecimento de senso comum ; plano ; aprender ; comunicar-se em linguagem natural ; e integrar todas essas habilidades para objetivos comuns. Outras capacidades importantes incluem a habilidade de sentir (por exemplo, ver ) e a habilidade de agir (por exemplo, mover e manipular objetos ) neste mundo onde o comportamento inteligente deve ser observado. Isso incluiria a capacidade de detectar e responder ao perigo . Muitas abordagens interdisciplinares da inteligência (por exemplo , ciência cognitiva , inteligência computacional e tomada de decisão ) tendem a enfatizar a necessidade de considerar características adicionais, como imaginação (considerada como a capacidade de formar imagens mentais e conceitos que não foram programados) e autonomia .

Existem sistemas baseados em computador que exibem muitos desses recursos (por exemplo, ver criatividade computacional , raciocínio automatizado , sistema de suporte à decisão , robô , computação evolucionária , agente inteligente ), mas ninguém criou um sistema integrado que se sobressaia em todas essas áreas.

Testes para confirmação de AGI em nível humano

Os seguintes testes para confirmar AGI em nível humano foram considerados:

- O Teste de Turing ( Turing )

- Uma máquina e um humano conversam sem serem vistos com um segundo humano, que deve avaliar qual dos dois é a máquina, que passa no teste se puder enganar o avaliador em uma fração significativa do tempo. Nota: Turing não prescreve o que deve ser qualificado como inteligência, apenas que saber que é uma máquina deve desqualificá-lo.

- O Teste do Café ( Wozniak )

- Uma máquina é necessária para entrar em um lar americano médio e descobrir como fazer café: encontre a máquina de café, encontre o café, adicione água, encontre uma caneca e faça o café pressionando os botões adequados.

- O Teste do Robot College Student ( Goertzel )

- Uma máquina se matricula em uma universidade, tendo e passando nas mesmas aulas que os humanos fariam, e obtendo um diploma.

- O Teste de Emprego ( Nilsson )

- Uma máquina desempenha um trabalho economicamente importante, pelo menos tão bem quanto os humanos no mesmo trabalho.

Problemas completos de IA

Existem muitos problemas individuais que podem exigir inteligência geral, se as máquinas quiserem resolver os problemas tão bem quanto as pessoas. Por exemplo, mesmo tarefas simples e específicas, como tradução automática , exigem que uma máquina leia e escreva em ambas as línguas ( PNL ), siga o argumento do autor ( razão ), saiba o que está sendo falado ( conhecimento ) e reproduza fielmente o original do autor intenção ( inteligência social ). Todos esses problemas precisam ser resolvidos simultaneamente para atingir o desempenho da máquina em nível humano.

Um problema é informalmente conhecido como "AI completo" ou "AI difícil", se resolvê-lo é equivalente à aptidão geral da inteligência humana, ou IA forte, e está além das capacidades de um algoritmo de propósito específico. Os problemas completos de IA são hipotetizados para incluir visão geral do computador , compreensão da linguagem natural e lidar com circunstâncias inesperadas durante a resolução de qualquer problema do mundo real.

Problemas completos de IA não podem ser resolvidos apenas com a tecnologia de computador atual e requerem computação humana . Esta propriedade pode ser útil, por exemplo, para testar a presença de humanos, como os CAPTCHAs pretendem fazer; e para a segurança do computador para repelir ataques de força bruta .

História

IA Clássica

A pesquisa de IA moderna começou em meados da década de 1950. A primeira geração de pesquisadores de IA estava convencida de que a inteligência artificial geral era possível e que existiria em apenas algumas décadas. O pioneiro da IA, Herbert A. Simon, escreveu em 1965: "as máquinas serão capazes, em vinte anos, de fazer qualquer trabalho que um homem possa fazer". Suas previsões foram a inspiração para o personagem HAL 9000 de Stanley Kubrick e Arthur C. Clarke , que incorporou o que os pesquisadores de IA acreditavam que poderiam criar até o ano de 2001. O pioneiro da IA, Marvin Minsky, foi consultor no projeto de tornar o HAL 9000 tão realista quanto possível de acordo com as previsões de consenso da época; Crevier o cita como tendo dito sobre o assunto em 1967, "Dentro de uma geração ... o problema de criar 'inteligência artificial' será substancialmente resolvido",

Vários projetos clássicos de IA , como o projeto Cyc de Doug Lenat (que começou em 1984), e o projeto Soar de Allen Newell , foram especificamente dirigidos à AGI.

No entanto, no início dos anos 1970 e novamente no início dos anos 90, tornou-se óbvio que os pesquisadores haviam subestimado grosseiramente a dificuldade do projeto. As agências de financiamento tornaram-se céticas em relação ao AGI e colocaram os pesquisadores sob crescente pressão para produzir "IA aplicada" útil. No início da década de 1980, o Projeto de Computador de Quinta Geração do Japão reviveu o interesse no AGI, estabelecendo um cronograma de dez anos que incluía objetivos do AGI como "manter uma conversa casual". Em resposta a isso e ao sucesso dos sistemas especialistas , tanto a indústria quanto o governo injetaram dinheiro de volta no campo. No entanto, a confiança na IA entrou em colapso espetacular no final dos anos 1980 e os objetivos do Projeto de Computador de Quinta Geração nunca foram cumpridos. Pela segunda vez em 20 anos, os pesquisadores de IA que previram a conquista iminente do AGI mostraram-se fundamentalmente enganados. Na década de 1990, os pesquisadores de IA ganharam a reputação de fazer promessas vãs. Eles ficaram relutantes em fazer previsões e em evitar qualquer menção de inteligência artificial de "nível humano", por medo de serem rotulados de "sonhadores desvairados".

Pesquisa estreita de IA

Na década de 1990 e no início do século 21, a IA convencional alcançou muito maior sucesso comercial e respeitabilidade acadêmica ao se concentrar em subproblemas específicos onde podem produzir resultados verificáveis e aplicações comerciais, como redes neurais artificiais e aprendizado de máquina estatística . Esses sistemas de "IA aplicada" são agora amplamente usados em toda a indústria de tecnologia, e a pesquisa nesse sentido é fortemente financiada tanto na academia quanto na indústria. Atualmente, o desenvolvimento neste campo é considerado uma tendência emergente, e espera-se que um estágio de maturidade aconteça em mais de 10 anos.

A maioria dos principais pesquisadores de IA espera que uma IA forte possa ser desenvolvida combinando os programas que resolvem vários subproblemas. Hans Moravec escreveu em 1988:

"Estou confiante de que esta rota ascendente para a inteligência artificial um dia encontrará a rota descendente tradicional mais da metade do caminho, pronta para fornecer a competência do mundo real e o conhecimento do senso comum que tem sido tão frustrantemente esquivo em programas de raciocínio. surgirão máquinas inteligentes quando a metafórica ponta dourada for acionada unindo os dois esforços. "

No entanto, mesmo essa filosofia fundamental foi contestada; por exemplo, Stevan Harnad, de Princeton, concluiu seu artigo de 1990 sobre a hipótese de aterramento do símbolo afirmando:

"A expectativa foi frequentemente expressa de que as abordagens" de cima para baixo "(simbólicas) para modelar a cognição de alguma forma atenderão às abordagens" de baixo para cima "(sensoriais) em algum ponto intermediário. Se as considerações básicas neste artigo forem válidas, então essa expectativa é irremediavelmente modular e há realmente apenas um caminho viável do sentido aos símbolos: do zero. Um nível simbólico flutuante como o nível de software de um computador nunca será alcançado por este caminho (ou vice-versa) - nem é claro por que deveríamos tentar atingir tal nível, já que parece que chegar lá equivaleria apenas a arrancar nossos símbolos de seus significados intrínsecos (assim, apenas nos reduzindo ao equivalente funcional de um computador programável). "

Pesquisa de inteligência geral artificial moderna

O termo "inteligência geral artificial" foi usado já em 1997, por Mark Gubrud, em uma discussão sobre as implicações de uma produção e operações militares totalmente automatizadas. O termo foi reintroduzido e popularizado por Shane Legg e Ben Goertzel por volta de 2002. A atividade de pesquisa da AGI em 2006 foi descrita por Pei Wang e Ben Goertzel como "produção de publicações e resultados preliminares". A primeira escola de verão em AGI foi organizada em Xiamen, China, em 2009, pelo Artificial Brain Laboratory e OpenCog da universidade de Xiamen. O primeiro curso universitário foi ministrado em 2010 e 2011 na Plovdiv University, Bulgária, por Todor Arnaudov. O MIT apresentou um curso na AGI em 2018, organizado por Lex Fridman e apresentando uma série de palestrantes convidados.

No entanto, até o momento, a maioria dos pesquisadores de IA dedicou pouca atenção ao AGI, com alguns alegando que a inteligência é muito complexa para ser completamente replicada a curto prazo. No entanto, um pequeno número de cientistas da computação está ativo na pesquisa da AGI, e muitos desse grupo estão contribuindo para uma série de conferências da AGI . A pesquisa é extremamente diversificada e frequentemente pioneira na natureza.

Cronogramas: na introdução de seu livro de 2006, Goertzel diz que as estimativas do tempo necessário antes que um AGI verdadeiramente flexível seja construído variam de 10 anos a mais de um século, mas o consenso de 2007 na comunidade de pesquisa do AGI parece ser que o cronograma discutido de Ray Kurzweil em The Singularity is Near (ou seja, entre 2015 e 2045) é plausível. - No entanto, os principais pesquisadores da IA deram uma ampla gama de opiniões sobre se o progresso será tão rápido. Uma meta-análise de 2012 de 95 opiniões encontrou um viés para prever que o início da AGI ocorreria dentro de 16-26 anos para as previsões modernas e históricas. Posteriormente, foi descoberto que o conjunto de dados listava alguns especialistas como não especialistas e vice-versa.

As organizações que buscam explicitamente o AGI incluem o Swiss AI lab IDSIA , Nnaisense, Vicarious , Maluuba , a OpenCog Foundation , Adaptive AI, LIDA e Numenta e o Redwood Neuroscience Institute associado . Além disso, organizações como o Machine Intelligence Research Institute e OpenAI foram fundadas para influenciar o caminho de desenvolvimento do AGI. Por fim, projetos como o Human Brain Project têm o objetivo de construir uma simulação de funcionamento do cérebro humano. Uma pesquisa de 2017 da AGI categorizou quarenta e cinco conhecidos "projetos de P&D ativos" que explícita ou implicitamente (por meio de pesquisas publicadas) pesquisam AGI, com os três maiores sendo DeepMind , Human Brain Project e OpenAI .

Em 2017, Ben Goertzel fundou a plataforma AI SingularityNET com o objetivo de facilitar o controle democrático e descentralizado do AGI quando ele chegar.

Em 2017, os pesquisadores Feng Liu, Yong Shi e Ying Liu conduziram testes de inteligência em IA fraca disponível ao público e de livre acesso, como o Google AI ou o Siri da Apple e outros. No máximo, esses IA atingiram um valor de QI de cerca de 47, o que corresponde aproximadamente a uma criança de seis anos na primeira série. Um adulto chega a cerca de 100 em média. Testes semelhantes foram realizados em 2014, com a pontuação de QI atingindo um valor máximo de 27.

Em 2019, o programador de videogames e engenheiro aeroespacial John Carmack anunciou planos para pesquisar a AGI.

Em 2020, a OpenAI desenvolveu o GPT-3 , um modelo de linguagem capaz de realizar muitas tarefas diversas sem treinamento específico. De acordo com Gary Grossman em um artigo da VentureBeat , embora haja consenso de que o GPT-3 não é um exemplo de AGI, é considerado por alguns como muito avançado para ser classificado como um sistema de IA estreito. No mesmo ano, Jason Rohrer usou sua conta GPT-3 para desenvolver um chatbot e forneceu uma plataforma de desenvolvimento de chatbot chamada "Projeto Dezembro". A OpenAI solicitou alterações no chatbot para cumprir suas diretrizes de segurança; Rohrer desconectou o Project December da API GPT-3.

Simulação de cérebro

Emulação de cérebro inteiro

Uma abordagem popular e discutida para obter ação inteligente geral é a emulação de todo o cérebro . Um modelo de cérebro de baixo nível é construído escaneando e mapeando um cérebro biológico em detalhes e copiando seu estado em um sistema de computador ou outro dispositivo computacional. O computador executa um modelo de simulação tão fiel ao original que se comportará essencialmente da mesma maneira que o cérebro original ou, para todos os efeitos práticos, indistinguivelmente. A emulação do cérebro inteiro é discutida em neurociência computacional e neuroinformática , no contexto da simulação do cérebro para fins de pesquisa médica. É discutido na pesquisa de inteligência artificial como uma abordagem para IA forte. As tecnologias de neuroimagem que poderiam fornecer a compreensão detalhada necessária estão melhorando rapidamente, e o futurista Ray Kurzweil, no livro The Singularity Is Near, prevê que um mapa de qualidade suficiente estará disponível em uma escala de tempo semelhante ao poder de computação necessário.

Estimativas iniciais

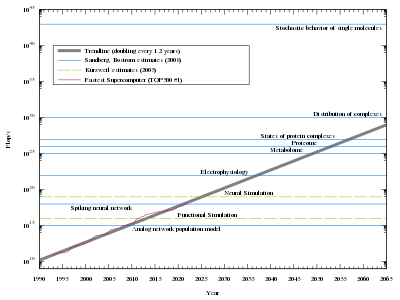

Para simulação do cérebro de baixo nível, um computador extremamente poderoso seria necessário. O cérebro humano possui um grande número de sinapses . Cada um dos 10 11 (cem bilhões) neurônios tem em média 7.000 conexões sinápticas (sinapses) com outros neurônios. Estima-se que o cérebro de uma criança de três anos tenha cerca de 10 15 sinapses (1 quatrilhão). Este número diminui com a idade, estabilizando na idade adulta. As estimativas variam para um adulto, variando de 10 14 a 5 × 10 14 sinapses (100 a 500 trilhões). Uma estimativa do poder de processamento do cérebro, com base em um modelo de switch simples para a atividade do neurônio, é de cerca de 10 14 (100 trilhões) de atualizações sinápticas por segundo ( SUPS ). Em 1997, Kurzweil olhou para várias estimativas para o hardware necessário para igualar o cérebro humano e adotou um número de 10 16 cálculos por segundo (cps). (Para comparação, se um "cálculo" fosse equivalente a uma " operação de ponto flutuante " - uma medida usada para classificar os supercomputadores atuais - então 10 16 "cálculos" seriam equivalentes a 10 petaFLOPS , obtidos em 2011 ). Ele usou essa figura para prever que o hardware necessário estaria disponível em algum momento entre 2015 e 2025, se o crescimento exponencial do poder do computador no momento em que este artigo foi escrito continuasse.

Modelando os neurônios em mais detalhes

O modelo de neurônio artificial assumido por Kurzweil e usado em muitas implementações de redes neurais artificiais atuais é simples em comparação com os neurônios biológicos . Uma simulação do cérebro provavelmente teria que capturar o comportamento celular detalhado dos neurônios biológicos , atualmente compreendido apenas nos contornos mais amplos. A sobrecarga introduzida pela modelagem completa dos detalhes biológicos, químicos e físicos do comportamento neural (especialmente em uma escala molecular) exigiria poderes computacionais várias ordens de magnitude maiores do que a estimativa de Kurzweil. Além disso, as estimativas não levam em conta as células da glia , que são pelo menos tão numerosas quanto os neurônios e podem superar os neurônios em até 10: 1, e agora são conhecidas por desempenhar um papel nos processos cognitivos.

Pesquisa atual

Existem alguns projetos de pesquisa que estão investigando a simulação do cérebro usando modelos neurais mais sofisticados, implementados em arquiteturas de computação convencionais. O projeto Sistema de Inteligência Artificial implementou simulações em tempo não real de um "cérebro" (com 10 11 neurônios) em 2005. Demorou 50 dias em um cluster de 27 processadores para simular 1 segundo de um modelo. O Blue Brain projeto utilizou uma das arquiteturas de supercomputadores mais rápidos do mundo, IBM 's Blue Gene plataforma, para criar uma simulação em tempo real de um único rato coluna neocortical composta por cerca de 10.000 neurônios e 10 8 sinapses em 2006. A longo prazo O objetivo é construir uma simulação funcional detalhada dos processos fisiológicos no cérebro humano: "Não é impossível construir um cérebro humano e podemos fazê-lo em 10 anos", disse Henry Markram , diretor do Blue Brain Project em 2009 na conferência TED em Oxford. Também houve alegações controversas de ter simulado o cérebro de um gato . Interfaces de neuro-silício foram propostas como uma estratégia de implementação alternativa que pode escalar melhor.

Hans Moravec abordou os argumentos acima ("cérebros são mais complicados", "neurônios precisam ser modelados com mais detalhes") em seu artigo de 1997 "Quando o hardware do computador corresponderá ao cérebro humano?". Ele mediu a capacidade do software existente de simular a funcionalidade do tecido neural, especificamente da retina. Seus resultados não dependem do número de células gliais, nem de quais tipos de neurônios de processamento atuam e onde.

A complexidade real da modelagem de neurônios biológicos foi explorada no projeto OpenWorm que visava a simulação completa de um worm que possui apenas 302 neurônios em sua rede neural (entre cerca de 1000 células no total). A rede neural do animal foi bem documentada antes do início do projeto. No entanto, embora a tarefa parecesse simples no início, os modelos baseados em uma rede neural genérica não funcionaram. Atualmente, os esforços estão focados na emulação precisa de neurônios biológicos (em parte no nível molecular), mas o resultado ainda não pode ser chamado de sucesso total. Mesmo que o número de problemas a serem resolvidos em um modelo em escala do cérebro humano não seja proporcional ao número de neurônios, a quantidade de trabalho ao longo desse caminho é óbvia.

Críticas às abordagens baseadas em simulação

Uma crítica fundamental da abordagem do cérebro simulado deriva da cognição incorporada, em que a incorporação humana é considerada um aspecto essencial da inteligência humana. Muitos pesquisadores acreditam que a incorporação é necessária para fundamentar o significado. Se essa visão estiver correta, qualquer modelo cerebral totalmente funcional precisará abranger mais do que apenas os neurônios (ou seja, um corpo robótico). Goertzel propõe a incorporação virtual (como no Second Life ), mas ainda não se sabe se isso seria suficiente.

Computadores desktop usando microprocessadores capazes de mais de 10 9 cps (unidade não padrão de "cálculos por segundo" de Kurzweil, veja acima) estão disponíveis desde 2005. De acordo com as estimativas de poder cerebral usadas por Kurzweil (e Moravec), este computador deve ser capaz de suportar a simulação de um cérebro de abelha, mas apesar de algum interesse, tal simulação não existe. Existem pelo menos três razões para isso:

- O modelo de neurônio parece ser simplificado demais (consulte a próxima seção).

- Não há compreensão suficiente dos processos cognitivos superiores para estabelecer com precisão com o que a atividade neural do cérebro, observada usando técnicas como a ressonância magnética funcional , se correlaciona.

- Mesmo que nossa compreensão da cognição avance o suficiente, os primeiros programas de simulação provavelmente serão muito ineficientes e, portanto, precisarão de muito mais hardware.

- O cérebro de um organismo, embora crítico, pode não ser um limite apropriado para um modelo cognitivo. Para simular o cérebro de uma abelha, pode ser necessário simular o corpo e o ambiente. A tese Extended Mind formaliza o conceito filosófico, e a pesquisa em cefalópodes demonstrou exemplos claros de um sistema descentralizado.

Além disso, a escala do cérebro humano não está bem limitada. Uma estimativa coloca o cérebro humano em cerca de 100 bilhões de neurônios e 100 trilhões de sinapses. Outra estimativa é de 86 bilhões de neurônios, dos quais 16,3 bilhões estão no córtex cerebral e 69 bilhões no cerebelo . As sinapses das células gliais não são atualmente quantificadas, mas são conhecidas por serem extremamente numerosas.

Perspectiva filosófica

"IA forte" conforme definido na filosofia

Em 1980, o filósofo John Searle cunhou o termo "IA forte" como parte de seu argumento de quarto chinês . Ele queria distinguir entre duas hipóteses diferentes sobre inteligência artificial:

- Hipótese de IA forte : um sistema de inteligência artificial pode "pensar", ter "uma mente" e "consciência".

- Hipótese fraca de IA : um sistema de inteligência artificial pode (apenas) agir como pensa e tem mente e consciência.

O primeiro ele chamou de "forte" porque faz uma afirmação mais forte : pressupõe que algo especial aconteceu à máquina que vai além de todas as suas habilidades que podemos testar - o comportamento de uma máquina de "IA fraca" seria precisamente idêntica a uma máquina de "IA forte", mas a última também teria experiência consciente subjetiva. Esse uso também é comum em pesquisas acadêmicas de IA e livros didáticos.

A Mainstream AI está interessada apenas em como um programa se comporta . De acordo com Russell e Norvig , "contanto que o programa funcione, eles não se importam se você o chama de real ou de simulação." Se o programa pode se comportar como se tivesse uma mente, então não há necessidade de saber se ele realmente tem uma mente - na verdade, não haveria como saber. Para pesquisas em IA, a "hipótese de IA fraca" de Searle é equivalente à afirmação "inteligência geral artificial é possível". Assim, de acordo com Russell e Norvig, "a maioria dos pesquisadores de IA toma a hipótese de IA fraca como certa e não se preocupa com a hipótese de IA forte." Assim, para pesquisas acadêmicas de IA, "IA forte" e "AGI" são duas coisas muito diferentes.

Em contraste com Searle e a IA convencional, alguns futuristas como Ray Kurzweil usam o termo "IA forte" para "inteligência geral artificial de nível humano". Isso não é o mesmo que a IA forte de Searle , a menos que você assuma que a consciência é necessária para o AGI em nível humano. Filósofos acadêmicos como Searle não acreditam que seja esse o caso, e os pesquisadores de inteligência artificial não se importam.

Consciência

Existem outros aspectos da mente humana além da inteligência que são relevantes para o conceito de IA forte, que desempenham um papel importante na ficção científica e na ética da inteligência artificial :

- consciência : Ter experiência e pensamento subjetivos .

- autoconsciência : estar ciente de si mesmo como um indivíduo separado, especialmente para estar ciente de seus próprios pensamentos.

- senciência : a capacidade de "sentir" percepções ou emoções subjetivamente.

- sapiência : a capacidade de sabedoria.

Esses traços têm uma dimensão moral, porque uma máquina com essa forma de IA forte pode ter direitos, análogos aos direitos dos animais não humanos . Como tal, um trabalho preliminar foi realizado em abordagens para integrar agentes éticos plenos com estruturas legais e sociais existentes. Essas abordagens enfocaram a posição legal e os direitos da IA 'forte'. Bill Joy , entre outros, argumenta que uma máquina com essas características pode ser uma ameaça à vida ou à dignidade humana.

Resta ser mostrado se alguma dessas características é necessária para uma IA forte. O papel da consciência não está claro e, atualmente, não há um teste consensual para sua presença. Se uma máquina fosse construída com um dispositivo que simula os correlatos neurais da consciência , ela teria autoconsciência automaticamente? Também é possível que algumas dessas propriedades, como a senciência, surjam naturalmente de uma máquina totalmente inteligente. Também é possível que se torne natural atribuir essas propriedades às máquinas, uma vez que elas comecem a agir de uma forma claramente inteligente.

Pesquisa de consciência artificial

Embora o papel da consciência em IA / AGI forte seja discutível, muitos pesquisadores de AGI consideram vital a pesquisa que investiga as possibilidades de implementação da consciência. Em um esforço inicial, Igor Aleksander argumentou que os princípios para criar uma máquina consciente já existiam, mas levaria quarenta anos para treinar tal máquina para entender a linguagem .

Possíveis explicações para o lento progresso da pesquisa de IA

Desde o lançamento da pesquisa em IA em 1956, o crescimento desse campo desacelerou ao longo do tempo e paralisou os objetivos de criar máquinas habilitadas com ação inteligente no nível humano. Uma possível explicação para esse atraso é que os computadores não têm espaço suficiente de memória ou capacidade de processamento. Além disso, o nível de complexidade que se conecta ao processo de pesquisa de IA também pode limitar o progresso da pesquisa de IA.

Enquanto a maioria dos pesquisadores de IA acredita que uma IA forte pode ser alcançada no futuro, existem alguns indivíduos como Hubert Dreyfus e Roger Penrose que negam a possibilidade de alcançar IA forte. John McCarthy foi um dos vários cientistas da computação que acreditam que a IA de nível humano será alcançada, mas uma data não pode ser prevista com precisão.

Limitações conceituais são outra possível razão para a lentidão na pesquisa de IA. Os pesquisadores de IA podem precisar modificar a estrutura conceitual de sua disciplina para fornecer uma base e contribuição mais fortes para a busca de alcançar uma IA forte. Como William Clocksin escreveu em 2003: "a estrutura começa com a observação de Weizenbaum de que a inteligência se manifesta apenas em relação a contextos sociais e culturais específicos".

Além disso, os pesquisadores de IA foram capazes de criar computadores que podem realizar tarefas complicadas para as pessoas, como matemática, mas, inversamente, eles têm lutado para desenvolver um computador que seja capaz de realizar tarefas simples para os humanos, como caminhar ( paradoxo de Moravec ). Um problema descrito por David Gelernter é que algumas pessoas presumem que o pensamento e o raciocínio são equivalentes. No entanto, a ideia de se os pensamentos e o criador desses pensamentos são isolados individualmente intrigou os pesquisadores de IA.

Os problemas encontrados na pesquisa de IA nas últimas décadas impediram ainda mais o progresso da IA. As previsões fracassadas que foram prometidas por pesquisadores de IA e a falta de uma compreensão completa dos comportamentos humanos ajudaram a diminuir a ideia primária de IA de nível humano. Embora o progresso da pesquisa em IA tenha trazido melhorias e desapontamentos, a maioria dos pesquisadores estabeleceu otimismo sobre o potencial de alcançar o objetivo da IA no século 21.

Outras razões possíveis foram propostas para a longa pesquisa sobre o progresso da IA forte. A complexidade dos problemas científicos e a necessidade de compreender totalmente o cérebro humano por meio da psicologia e da neurofisiologia limitaram muitos pesquisadores na emulação da função do cérebro humano em hardware de computador. Muitos pesquisadores tendem a subestimar qualquer dúvida que esteja envolvida com as previsões futuras da IA, mas sem levar essas questões a sério, as pessoas podem ignorar as soluções para questões problemáticas.

Clocksin afirma que uma limitação conceitual que pode impedir o progresso da pesquisa em IA é que as pessoas podem estar usando técnicas erradas para programas de computador e implementação de equipamentos. Quando os pesquisadores de IA começaram a visar o objetivo da inteligência artificial, o principal interesse era o raciocínio humano. Os pesquisadores esperavam estabelecer modelos computacionais do conhecimento humano por meio do raciocínio e descobrir como projetar um computador com uma tarefa cognitiva específica.

A prática da abstração, que as pessoas tendem a redefinir ao trabalhar com um determinado contexto de pesquisa, fornece aos pesquisadores uma concentração em apenas alguns conceitos. O uso mais produtivo da abstração na pesquisa de IA vem do planejamento e da resolução de problemas. Embora o objetivo seja aumentar a velocidade de uma computação, o papel da abstração tem levantado questões sobre o envolvimento dos operadores de abstração.

Uma possível razão para a lentidão na IA está relacionada ao reconhecimento por muitos pesquisadores de IA de que a heurística é uma seção que contém uma violação significativa entre o desempenho do computador e o desempenho humano. As funções específicas que são programadas para um computador podem ser capazes de responder por muitos dos requisitos que permitem que ele corresponda à inteligência humana. Essas explicações não são necessariamente as causas fundamentais para o atraso na obtenção de IA forte, mas são amplamente aceitas por vários pesquisadores.

Muitos pesquisadores de IA discutem se as máquinas devem ser criadas com emoções . Não há emoções em modelos típicos de IA e alguns pesquisadores dizem que programar emoções em máquinas permite que elas tenham ideias próprias. A emoção resume as experiências dos humanos porque permite que eles se lembrem dessas experiências. David Gelernter escreve: "Nenhum computador será criativo a menos que possa simular todas as nuances da emoção humana." Essa preocupação com a emoção tem causado problemas para os pesquisadores de IA e se conecta ao conceito de IA forte à medida que sua pesquisa avança no futuro.

Controvérsias e perigos

Viabilidade

Em agosto de 2020, a AGI permanece especulativa, pois nenhum sistema desse tipo foi demonstrado ainda. As opiniões variam sobre se e quando a inteligência artificial geral chegará. Em um extremo, o pioneiro da IA Herbert A. Simon especulou em 1965: "as máquinas serão capazes, dentro de vinte anos, de fazer qualquer trabalho que um homem possa fazer". No entanto, essa previsão não se concretizou. O co-fundador da Microsoft, Paul Allen, acreditava que tal inteligência é improvável no século 21 porque exigiria "descobertas imprevisíveis e fundamentalmente imprevisíveis" e uma "compreensão cientificamente profunda da cognição". Escrevendo no The Guardian , o roboticista Alan Winfield afirmou que o abismo entre a computação moderna e a inteligência artificial de nível humano é tão grande quanto o abismo entre o vôo espacial atual e o vôo espacial prático mais rápido que a luz.

As opiniões dos especialistas em IA sobre a viabilidade do AGI aumentam e diminuem, e podem ter ressurgido na década de 2010. Quatro pesquisas realizadas em 2012 e 2013 sugeriram que a estimativa média entre os especialistas de quando eles estariam 50% de confiança que a AGI chegaria foi de 2040 a 2050, dependendo da pesquisa, com a média sendo de 2081. Dos especialistas, 16,5% responderam com " nunca "quando for feita a mesma pergunta, mas com 90% de confiança. Outras considerações atuais sobre o progresso de AGI podem ser encontradas abaixo Testes para confirmar AGI em nível humano .

Ameaça potencial à existência humana

A tese de que a IA representa um risco existencial, e que esse risco precisa de muito mais atenção do que recebe atualmente, foi endossada por muitas figuras públicas; talvez os mais famosos sejam Elon Musk , Bill Gates e Stephen Hawking . O mais notável pesquisador de IA a endossar a tese foi Stuart J. Russell . Endossantes da tese às vezes expressam perplexidade com os céticos: Gates afirma que não "entende por que algumas pessoas não estão preocupadas", e Hawking criticou a indiferença generalizada em seu editorial de 2014:

'Então, diante de possíveis futuros de riscos e benefícios incalculáveis, os especialistas certamente estão fazendo todo o possível para garantir o melhor resultado, certo? Errado. Se uma civilização alienígena superior nos enviasse uma mensagem dizendo: 'Chegaremos em algumas décadas', responderíamos apenas: 'OK, ligue-nos quando chegar aqui - vamos deixar as luzes acesas?' Provavelmente não - mas isso é mais ou menos o que está acontecendo com a IA. '

Muitos dos estudiosos que estão preocupados com o risco existencial acreditam que o melhor caminho a seguir seria conduzir uma pesquisa (possivelmente massiva) para resolver o difícil " problema de controle " para responder à pergunta: quais tipos de salvaguardas, algoritmos ou arquiteturas os programadores podem implementar maximizar a probabilidade de que sua IA de melhoria recursiva continuasse a se comportar de maneira amigável, em vez de destrutiva, após atingir a superinteligência?

A tese de que a IA pode representar risco existencial também tem muitos detratores fortes. Os céticos às vezes afirmam que a tese é cripto-religiosa, com uma crença irracional na possibilidade de a superinteligência substituir uma crença irracional em um Deus onipotente; no extremo, Jaron Lanier argumenta que todo o conceito de que as máquinas atuais são de alguma forma inteligentes é "uma ilusão" e um "golpe estupendo" pelos ricos.

Muitas das críticas existentes argumentam que AGI é improvável no curto prazo. O cientista da computação Gordon Bell argumenta que a raça humana já se destruirá antes de atingir a singularidade tecnológica . Gordon Moore , o proponente original da Lei de Moore , declara que "Eu sou um cético. Não acredito que [uma singularidade tecnológica] aconteça, pelo menos por muito tempo. E não sei por que sinto isso caminho." O ex- vice-presidente e cientista-chefe do Baidu , Andrew Ng, afirma que o risco existencial de IA é "como se preocupar com a superpopulação em Marte quando ainda nem colocamos os pés no planeta".

Veja também

- Cérebro artificial

- Problema de controle de IA

- Aprendizado de máquina automatizado

- BRAIN Initiative

- China Brain Project

- Instituto Futuro da Humanidade

- Jogo geral

- Projeto Cérebro Humano

- Amplificação de inteligência (IA)

- Ética da máquina

- Aprendizagem multitarefa

- Esboço de inteligência artificial

- Esboço do transumanismo

- Superinteligência

- Inteligência sintética

- Aprendizagem de transferência

- Prêmio Loebner

Notas

Referências

Fontes

- Relatório de Ciências da UNESCO: a corrida contra o tempo para um desenvolvimento mais inteligente . Paris: UNESCO. 11 de junho de 2021. ISBN 978-92-3-100450-6.

- Aleksander, Igor (1996), Impossible Minds , World Scientific Publishing Company, ISBN 978-1-86094-036-1

- Azevedo FA, Carvalho LR, Grinberg LT, Farfel J, et al. (Abril de 2009), "Números iguais de células neuronais e não neuronais tornam o cérebro humano um cérebro de primata isometricamente dimensionado" , The Journal of Comparative Neurology , 513 (5): 532–41, doi : 10.1002 / cne.21974 , PMID 19226510 , S2CID 5200449 , arquivado do original em 18 de fevereiro de 2021 , recuperado em 4 de setembro de 2013

- Berglas, Anthony (2008), Artificial Intelligence will Kill our Grandchildren , arquivado do original em 23 de julho de 2014 , recuperado em 31 de agosto de 2012

- Chalmers, David (1996), The Conscious Mind , Oxford University Press.

- Clocksin, William (agosto de 2003), "Artificial intelligence and the future", Philosophical Transactions of the Royal Society A , 361 (1809): 1721–1748, Bibcode : 2003RSPTA.361.1721C , doi : 10.1098 / rsta.2003.1232 , PMID 12952683 , S2CID 31032007.

- Crevier, Daniel (1993). AI: The Tumultuous Search for Artificial Intelligence . Nova York, NY: BasicBooks. ISBN 0-465-02997-3.

- Darrach, Brad (20 de novembro de 1970), "Meet Shakey, the First Electronic Person", Life Magazine , pp. 58-68.

- Drachman, D (2005), "Do we have brain to spare?", Neurology , 64 (12): 2004-5, doi : 10.1212 / 01.WNL.0000166914.38327.BB , PMID 15985565 , S2CID 38482114.

- Feigenbaum, Edward A .; McCorduck, Pamela (1983), The Fifth Generation: Artificial Intelligence and Japan's Computer Challenge to the World , Michael Joseph, ISBN 978-0-7181-2401-4

- Gelernter, David (2010), Dream-logic, the Internet and Artificial Thought , arquivado do original em 26 de julho de 2010 , recuperado em 25 de julho de 2010

- Goertzel, Ben; Pennachin, Cassio, eds. (2006), Artificial General Intelligence (PDF) , Springer, ISBN 978-3-540-23733-4, arquivado do original (PDF) em 20 de março de 2013

- Goertzel, Ben (dezembro de 2007), "Inteligência geral artificial de nível humano e a possibilidade de uma singularidade tecnológica: uma reação a The Singularity Is Near de Ray Kurzweil, e McDermott's critique of Kurzweil" , Artificial Intelligence , 171 (18, Special Review Issue ): 1161–1173, doi : 10.1016 / j.artint.2007.10.011 , arquivado do original em 7 de janeiro de 2016 , recuperado em 1 de abril de 2009.

- Gubrud, Mark (novembro de 1997), "Nanotechnology and International Security" , Fifth Foresight Conference on Molecular Nanotechnology , arquivado do original em 29 de maio de 2011 , recuperado em 7 de maio de 2011

- Halal, William E. "Série de artigos do TechCast: A automação do pensamento" (PDF) . Arquivado do original (PDF) em 6 de junho de 2013.

- Holte, RC; Choueiry, BY (2003), "Abstraction and reformulation in artificial intelligence", Philosophical Transactions of the Royal Society B , 358 (1435): 1197-1204, doi : 10.1098 / rstb.2003.1317 , PMC 1693218 , PMID 12903653.

- Howe, J. (novembro de 1994), Artificial Intelligence at Edinburgh University: a Perspective , arquivado do original em 17 de agosto de 2007 , recuperado em 30 de agosto de 2007

- Johnson, Mark (1987), The body in the mind , Chicago, ISBN 978-0-226-40317-5

- Kurzweil, Ray (2005), The Singularity is Near , Viking Press

- Lighthill, Professor Sir James (1973), "Artificial Intelligence: A General Survey", Artificial Intelligence: a paper symposium , Science Research Council

- Luger, George; Stubblefield, William (2004), Artificial Intelligence: Structures and Strategies for Complex Problem Solving (5ª ed.), The Benjamin / Cummings Publishing Company, Inc., p. 720 , ISBN 978-0-8053-4780-7

- McCarthy, John (outubro de 2007), "From here to human-level AI", Artificial Intelligence , 171 (18): 1174–1182, doi : 10.1016 / j.artint.2007.10.009.

- McCorduck, Pamela (2004), Machines Who Think (2ª ed.), Natick, MA: AK Peters, Ltd., ISBN 1-56881-205-1

- Moravec, Hans (1976), The Role of Raw Power in Intelligence , arquivado do original em 3 de março de 2016 , recuperado em 29 de setembro de 2007

- Moravec, Hans (1988), Mind Children , Harvard University Press

- Moravec, Hans (1998), "Quando o hardware do computador corresponderá ao cérebro humano?" , Journal of Evolution and Technology , 1 , arquivado do original em 15 de junho de 2006 , recuperado em 23 de junho de 2006

- Nagel (1974), "What Is it Like to Be a Bat" (PDF) , Philosophical Review , 83 (4): 435–50, doi : 10.2307 / 2183914 , JSTOR 2183914 , arquivado (PDF) do original em 16 de outubro 2011 , recuperado em 7 de novembro de 2009.

- Newell, Allen ; Simon, HA (1963), "GPS: A Program that Simulates Human Thought", em Feigenbaum, EA; Feldman, J. (eds.), Computers and Thought , New York: McGraw-Hill

- Newell, Allen ; Simon, HA (1976). "Computer Science as Empirical Inquiry: Symbols and Search" . Comunicações da ACM . 19 (3): 113–126. doi : 10.1145 / 360018.360022 .

- Nilsson, Nils (1998), Artificial Intelligence: A New Synthesis , Morgan Kaufmann Publishers, ISBN 978-1-55860-467-4

- NRC (1999), "Developments in Artificial Intelligence" , Funding a Revolution: Government Support for Computing Research , National Academy Press, arquivado do original em 12 de janeiro de 2008 , recuperado em 29 de setembro de 2007

- Omohundro, Steve (2008), The Nature of Self-Improving Artificial Intelligence , apresentado e distribuído no 2007 Singularity Summit, San Francisco, CA.

- Poole, David ; Mackworth, Alan; Goebel, Randy (1998), Computational Intelligence: A Logical Approach , Nova York: Oxford University Press, arquivado do original em 25 de julho de 2009 , recuperado em 6 de dezembro de 2007

- Russell, Stuart J .; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2ª ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2

- Sandberg, Anders; Boström, Nick (2008), Whole Brain Emulation: A Roadmap (PDF) , Technical Report # 2008‐3, Future of Humanity Institute, Oxford University, arquivado (PDF) do original em 25 de março de 2020 , recuperado em 5 de abril de 2009

- Searle, John (1980), "Minds, Brains and Programs" (PDF) , Behavioral and Brain Sciences , 3 (3): 417–457, doi : 10.1017 / S0140525X00005756 , arquivado (PDF) do original em 17 de março de 2019 , recuperado em 3 de setembro de 2020

- Simon, HA (1965), The Shape of Automation for Men and Management , Nova York: Harper & Row

- Sutherland, JG (1990), "Modelo Holográfico de Memória, Aprendizagem e Expressão", International Journal of Neural Systems , 1-3 : 256-267.

- de Vega, Manuel; Glenberg, Arthur; Graesser, Arthur, eds. (2008), Symbols and Embodiment: Debates on meaning and cognition , Oxford University Press, ISBN 978-0-19-921727-4.

- Wang, Pei; Goertzel, Ben (2007). "Introdução: Aspectos da Inteligência Artificial Geral" . Advances in Artificial General Intelligence: Concepts, Architectures and Algorithms: Proceedings of the AGI Workshop 2006 . pp. 1–16. ISBN 978-1-58603-758-1. Arquivado do original em 18 de fevereiro de 2021 . Página visitada em 13 de dezembro de 2020 .

- Williams RW, Herrup K (1988), "The control of neuron number", Annual Review of Neuroscience , 11 : 423-53, doi : 10.1146 / annurev.ne.11.030188.002231 , PMID 3284447.

- Yudkowsky, Eliezer (2006), "Artificial General Intelligence" (PDF) , Annual Review of Psychology , Springer, 49 : 585–612, doi : 10.1146 / annurev.psych.49.1.585 , ISBN 978-3-540-23733-4, PMID 9496632 , arquivado do original (PDF) em 11 de abril de 2009.

- Yudkowsky, Eliezer (2008), "Artificial Intelligence as a Positive and Negative Factor in Global Risk", Global Catastrophic Risks , Bibcode : 2008gcr..book..303Y , doi : 10.1093 / oso / 9780198570509.003.0021 , ISBN 9780198570509.

- Zucker, Jean-Daniel (julho de 2003), "A grounded theory of abstraction in artificial intelligence", Philosophical Transactions of the Royal Society B , 358 (1435): 1293-1309, doi : 10.1098 / rstb.2003.1308 , PMC 1693211 , PMID 12903672.

links externos

- O portal AGI mantido por Pei Wang

- The Genesis Group no MIT's CSAIL - Pesquisa moderna sobre os cálculos que sustentam a inteligência humana

- OpenCog - projeto de código aberto para desenvolver uma IA de nível humano

- Simulando o pensamento humano lógico

- O que sabemos sobre os cronogramas de IA? - Revisão da literatura