Filosofia da inteligência artificial - Philosophy of artificial intelligence

| Parte de uma série sobre |

| Inteligência artificial |

|---|

A filosofia da inteligência artificial é um ramo da filosofia da tecnologia que explora a inteligência artificial e suas implicações para o conhecimento e compreensão da inteligência , ética , consciência , epistemologia e livre arbítrio . Além disso, a tecnologia está preocupada com a criação de animais artificiais ou pessoas artificiais (ou, pelo menos, criaturas artificiais; veja a vida artificial ), portanto, a disciplina é de considerável interesse para os filósofos. Esses fatores contribuíram para o surgimento da filosofia da inteligência artificial . Alguns estudiosos argumentam que a rejeição da filosofia pela comunidade de IA é prejudicial.

A filosofia da inteligência artificial tenta responder às seguintes questões:

- Uma máquina pode agir de forma inteligente? Pode resolver qualquer problema que uma pessoa resolveria pensando?

- A inteligência humana e a inteligência da máquina são iguais? O cérebro humano é essencialmente um computador?

- Uma máquina pode ter mente , estados mentais e consciência no mesmo sentido que um ser humano pode? Pode sentir como as coisas estão ?

Perguntas como essas refletem os interesses divergentes de pesquisadores de IA , cientistas cognitivos e filósofos, respectivamente. As respostas científicas a essas perguntas dependem da definição de "inteligência" e "consciência" e exatamente quais "máquinas" estão em discussão.

As proposições importantes na filosofia da IA incluem algumas das seguintes:

- A "convenção polida" de Turing : se uma máquina se comporta de maneira tão inteligente quanto um ser humano, ela é tão inteligente quanto um ser humano.

- A proposta de Dartmouth : "Cada aspecto da aprendizagem ou qualquer outra característica da inteligência pode ser descrito com tanta precisão que uma máquina pode ser feita para simulá-lo."

- Allen Newell e Herbert A. Simon 's sistema de símbolos físicos hipótese: 'Um sistema de símbolos físicos tem os meios necessários e suficientes de ação inteligente em geral.'

- A forte hipótese de IA de John Searle : "O computador apropriadamente programado com as entradas e saídas certas teria, portanto, uma mente exatamente no mesmo sentido em que os seres humanos têm mente."

- Mecanismo de Hobbes : "Por 'razão' ... nada mais é do que 'cálculo', isto é, somar e subtrair, das consequências de nomes gerais acordados para a 'marcação' e 'significado' de nossos pensamentos ..."

Uma máquina pode exibir inteligência geral?

É possível criar uma máquina que possa resolver todos os problemas que os humanos resolvem usando sua inteligência? Esta questão define o escopo do que as máquinas podem fazer no futuro e orienta a direção da pesquisa de IA. Diz respeito apenas ao comportamento das máquinas e ignora as questões de interesse para psicólogos , cientistas cognitivos e filósofos ; para responder a essa pergunta, não importa se uma máquina está realmente pensando (como a pessoa pensa) ou apenas agindo como se estivesse pensando.

A posição básica da maioria dos pesquisadores de IA é resumida nesta declaração, que apareceu na proposta para o workshop de Dartmouth de 1956:

- "Cada aspecto do aprendizado ou qualquer outra característica da inteligência pode ser descrito com tanta precisão que uma máquina pode ser feita para simulá-lo."

Os argumentos contra a premissa básica devem mostrar que construir um sistema de IA funcional é impossível porque há algum limite prático para as habilidades dos computadores ou que há alguma qualidade especial da mente humana que é necessária para o comportamento inteligente e ainda não pode ser duplicada por um máquina (ou pelos métodos da pesquisa atual de IA). Os argumentos a favor da premissa básica devem mostrar que tal sistema é possível.

Também é possível contornar a conexão entre as duas partes da proposta acima. Por exemplo, o aprendizado de máquina, começando com a infame proposta de máquina infantil de Turing, essencialmente atinge o recurso desejado de inteligência sem uma descrição precisa em tempo de design de como funcionaria exatamente. A conta sobre o conhecimento tácito do robô elimina a necessidade de uma descrição precisa em conjunto.

O primeiro passo para responder à pergunta é definir claramente "inteligência".

Inteligência

Teste de Turing

Alan Turing reduziu o problema de definir inteligência a uma simples pergunta sobre conversação. Ele sugere que: se uma máquina pode responder a qualquer pergunta feita a ela, usando as mesmas palavras que uma pessoa comum faria, então podemos chamar essa máquina de inteligente. Uma versão moderna de seu projeto experimental usaria uma sala de chat online , onde um dos participantes é uma pessoa real e um dos participantes é um programa de computador. O programa passa no teste se ninguém souber qual dos dois participantes é humano. Turing observa que ninguém (exceto os filósofos) jamais faz a pergunta "as pessoas podem pensar?" Ele escreve "em vez de discutir continuamente sobre este ponto, é comum ter uma convenção educada de que todos pensam". O teste de Turing estende essa convenção educada às máquinas:

- Se uma máquina atua de forma tão inteligente quanto um ser humano, ela é tão inteligente quanto um ser humano.

Uma crítica ao teste de Turing é que ele mede apenas a "humanidade" do comportamento da máquina, e não a "inteligência" do comportamento. Como o comportamento humano e o comportamento inteligente não são exatamente a mesma coisa, o teste falha em medir a inteligência. Stuart J. Russell e Peter Norvig escreveram que "os textos de engenharia aeronáutica não definem o objetivo de seu campo como 'fazer máquinas que voam tão exatamente como pombos que podem enganar outros pombos'".

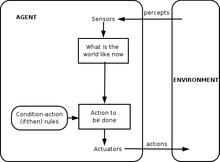

Definição de agente inteligente

A pesquisa de IA do século XXI define inteligência em termos de agentes inteligentes . Um "agente" é algo que percebe e age em um ambiente. Uma "medida de desempenho" define o que conta como sucesso para o agente.

- "Se um agente age de forma a maximizar o valor esperado de uma medida de desempenho com base na experiência e conhecimento anteriores, ele é inteligente."

Definições como esta tentam capturar a essência da inteligência. Eles têm a vantagem de que, ao contrário do teste de Turing, eles também não testam traços humanos não inteligentes, como cometer erros de digitação ou a capacidade de ser insultado. Eles têm a desvantagem de não conseguirem diferenciar entre "coisas que pensam" e "coisas que não pensam". Por essa definição, até mesmo um termostato tem uma inteligência rudimentar.

Argumentos de que uma máquina pode exibir inteligência geral

O cérebro pode ser simulado

Hubert Dreyfus descreve este argumento afirmando que "se o sistema nervoso obedece às leis da física e da química, que temos todos os motivos para supor que obedece, então ... nós ... devemos ser capazes de reproduzir o comportamento do sistema nervoso com algum dispositivo físico ". Este argumento, apresentado pela primeira vez em 1943 e vividamente descrito por Hans Moravec em 1988, está agora associado ao futurista Ray Kurzweil , que estima que o poder do computador será suficiente para uma simulação completa do cérebro até o ano 2029. Uma simulação em tempo não real de um modelo tálamo-cortical que tem o tamanho do cérebro humano (10 11 neurônios) foi realizada em 2005 e levou 50 dias para simular 1 segundo de dinâmica cerebral em um cluster de 27 processadores.

Mesmo os críticos mais severos da IA (como Hubert Dreyfus e John Searle ) concordam que uma simulação do cérebro é possível em teoria. No entanto, Searle destaca que, em princípio, qualquer coisa pode ser simulada por um computador; assim, trazer a definição ao seu ponto de ruptura leva à conclusão de que qualquer processo pode ser tecnicamente considerado "cálculo". “O que queríamos saber é o que distingue a mente dos termostatos e do fígado”, escreve ele. Assim, meramente simular o funcionamento de um cérebro vivo seria em si uma admissão de ignorância em relação à inteligência e à natureza da mente, como tentar construir um avião a jato copiando um pássaro vivo com precisão, pena por pena, sem conhecimento teórico de engenharia aeronáutica .

O pensamento humano é o processamento de símbolos

Em 1963, Allen Newell e Herbert A. Simon propuseram que a "manipulação de símbolos" era a essência da inteligência humana e da máquina. Eles escreveram:

- "Um sistema de símbolos físicos tem os meios necessários e suficientes para uma ação geral inteligente."

Essa afirmação é muito forte: ela implica que o pensamento humano é um tipo de manipulação de símbolos (porque um sistema de símbolos é necessário para a inteligência) e que as máquinas podem ser inteligentes (porque um sistema de símbolos é suficiente para a inteligência). Outra versão dessa posição foi descrita pelo filósofo Hubert Dreyfus, que a chamou de "suposição psicológica":

- "A mente pode ser vista como um dispositivo operando em bits de informação de acordo com regras formais."

Os "símbolos" que Newell, Simon e Dreyfus discutiram eram semelhantes a palavras e de alto nível - símbolos que correspondem diretamente a objetos no mundo, como <dog> e <tail>. A maioria dos programas de IA escritos entre 1956 e 1990 usava esse tipo de símbolo. A IA moderna, baseada em estatísticas e otimização matemática, não usa o "processamento de símbolos" de alto nível que Newell e Simon discutiram.

Argumentos contra processamento de símbolo

Esses argumentos mostram que o pensamento humano não consiste (unicamente) na manipulação de símbolos de alto nível. Eles não mostram que a inteligência artificial é impossível, apenas que mais do que o processamento de símbolos é necessário.

Argumentos anti-mecanicistas de Gödel

Em 1931, Kurt Gödel provou com um teorema da incompletude que sempre é possível construir uma " declaração de Gödel " que um dado sistema formal consistente de lógica (como um programa de manipulação de símbolos de alto nível) não poderia provar. Apesar de ser uma afirmação verdadeira, a afirmação de Gödel construída é improvável no sistema dado. (A verdade da declaração de Gödel construída depende da consistência do sistema dado; aplicar o mesmo processo a um sistema sutilmente inconsistente parecerá bem-sucedido, mas na verdade produzirá uma falsa "declaração de Gödel" em vez disso.) Mais especulativamente, Gödel conjecturou que a mente humana pode eventualmente determinar corretamente a verdade ou falsidade de qualquer declaração matemática bem fundamentada (incluindo qualquer declaração de Gödel possível) e que, portanto, o poder da mente humana não é redutível a um mecanismo . O filósofo John Lucas (desde 1961) e Roger Penrose (desde 1989) defenderam esse argumento filosófico antimecanista.

Os argumentos antimecanistas de Gödel tendem a se basear na afirmação aparentemente inócua de que um sistema de matemáticos humanos (ou alguma idealização de matemáticos humanos) é consistente (completamente livre de erros) e acredita totalmente em sua própria consistência (e pode tornar tudo lógico inferências que seguem de sua própria consistência, incluindo a crença em sua declaração de Gödel). Isso é comprovadamente impossível para uma máquina de Turing fazer (consulte o problema de parada ); portanto, o Gödelian conclui que o raciocínio humano é muito poderoso para ser capturado por uma máquina de Turing e, por extensão, qualquer dispositivo mecânico digital.

No entanto, o consenso moderno na comunidade científica e matemática é que o raciocínio humano real é inconsistente; que qualquer "versão idealizada" H consistente do raciocínio humano seria logicamente forçada a adotar um ceticismo de mente aberta saudável, mas contra-intuitivo, sobre a consistência de H (caso contrário, H é comprovadamente inconsistente); e que os teoremas de Gödel não levam a nenhum argumento válido de que os humanos têm capacidades de raciocínio matemático além do que uma máquina poderia duplicar. Este consenso de que os argumentos antimecanistas de Gödel estão fadados ao fracasso é exposto fortemente em Inteligência Artificial : " qualquer tentativa de utilizar (resultados da incompletude de Gödel) para atacar a tese computacionalista está fadada a ser ilegítima, uma vez que esses resultados são bastante consistentes com o computacionalista tese."

Stuart Russell e Peter Norvig concordam que o argumento de Gödel não considera a natureza do raciocínio humano no mundo real. Aplica-se ao que teoricamente pode ser provado, dada uma quantidade infinita de memória e tempo. Na prática, máquinas reais (incluindo humanos) têm recursos finitos e terão dificuldade em provar muitos teoremas. Não é preciso saber tudo para ser inteligente.

Menos formalmente, Douglas Hofstadter , em seu livro ganhador do prêmio Pulitzer Gödel, Escher, Bach: An Eternal Golden Braid , afirma que essas "declarações de Gödel" sempre se referem ao próprio sistema, fazendo uma analogia com a maneira como o paradoxo de Epimênides usa declarações que referem-se a si próprios, como "esta afirmação é falsa" ou "Estou mentindo". Mas, é claro, o paradoxo de Epimênides se aplica a qualquer coisa que faça afirmações, sejam máquinas ou humanos, até mesmo o próprio Lucas. Considerar:

- Lucas não pode afirmar a verdade dessa afirmação.

Esta afirmação é verdadeira, mas não pode ser afirmada por Lucas. Isso mostra que o próprio Lucas está sujeito aos mesmos limites que ele descreve para as máquinas, como todas as pessoas, e por isso o argumento de Lucas é inútil.

Depois de concluir que o raciocínio humano não é computável, Penrose especulou de forma controversa que algum tipo de processo hipotético não computável envolvendo o colapso dos estados da mecânica quântica dá aos humanos uma vantagem especial sobre os computadores existentes. Os computadores quânticos existentes são apenas capazes de reduzir a complexidade das tarefas computáveis de Turing e ainda estão restritos a tarefas dentro do escopo das máquinas de Turing. Pelos argumentos de Penrose e Lucas, os computadores quânticos existentes não são suficientes, então Penrose busca algum outro processo envolvendo novos a física, por exemplo a gravidade quântica, que pode manifestar uma nova física na escala da massa de Planck por meio do colapso quântico espontâneo da função de onda. Esses estados, sugeriu ele, ocorrem tanto dentro dos neurônios quanto em mais de um neurônio. No entanto, outros cientistas apontam que não há mecanismo orgânico plausível no cérebro para controlar qualquer tipo de computação quântica e, além disso, a escala de tempo da decoerência quântica parece muito rápida para influenciar o disparo dos neurônios.

Dreyfus: a primazia das habilidades implícitas

Hubert Dreyfus argumentou que a inteligência humana e a perícia dependiam principalmente da habilidade implícita ao invés da manipulação simbólica explícita, e argumentou que essas habilidades nunca seriam capturadas em regras formais.

O argumento de Dreyfus foi antecipado por Turing em seu artigo de 1950 Computing Machines and Intelligence , onde ele o classificou como o "argumento da informalidade do comportamento". Turing argumentou em resposta que, só porque não conhecemos as regras que governam um comportamento complexo, isso não significa que essas regras não existam. Ele escreveu: "não podemos nos convencer tão facilmente da ausência de leis completas de comportamento ... A única maneira que conhecemos para encontrar tais leis é a observação científica, e certamente não conhecemos nenhuma circunstância em que poderíamos dizer: ' pesquisou o suficiente. Não existem tais leis. '"

Russell e Norvig apontam que, nos anos desde que Dreyfus publicou sua crítica, progressos foram feitos no sentido de descobrir as "regras" que governam o raciocínio inconsciente. O movimento situado na pesquisa robótica tenta capturar nossas habilidades inconscientes de percepção e atenção. Paradigmas de inteligência computacional , como redes neurais , algoritmos evolutivos e assim por diante, são principalmente direcionados ao raciocínio e aprendizagem inconscientes simulados. Abordagens estatísticas para IA podem fazer previsões que se aproximam da precisão de suposições intuitivas humanas. A pesquisa sobre o conhecimento do senso comum tem se concentrado na reprodução do "pano de fundo" ou contexto do conhecimento. Na verdade, a pesquisa de IA em geral se afastou da manipulação de símbolos de alto nível, em direção a novos modelos que pretendem capturar mais de nosso raciocínio inconsciente . O historiador e pesquisador de IA Daniel Crevier escreveu que "o tempo provou a precisão e percepção de alguns dos comentários de Dreyfus. Se ele os tivesse formulado de forma menos agressiva, as ações construtivas que eles sugeriram poderiam ter sido tomadas muito antes".

Uma máquina pode ter mente, consciência e estados mentais?

Esta é uma questão filosófica, relacionada ao problema de outras mentes e ao difícil problema da consciência . A questão gira em torno de uma posição definida por John Searle como "IA forte":

- Um sistema de símbolo físico pode ter uma mente e estados mentais.

Searle distinguiu esta posição do que chamou de "IA fraca":

- Um sistema de símbolo físico pode agir de forma inteligente.

Searle introduziu os termos para isolar IA forte de IA fraca para que ele pudesse se concentrar no que considerava a questão mais interessante e discutível. Ele argumentou que, mesmo se assumirmos que temos um programa de computador que age exatamente como a mente humana, ainda haveria uma difícil questão filosófica que precisa ser respondida.

Nenhuma das duas posições de Searle é de grande preocupação para a pesquisa de IA, uma vez que não respondem diretamente à pergunta "pode uma máquina exibir inteligência geral?" (a menos que também possa ser demonstrado que a consciência é necessária para a inteligência). Turing escreveu "Não quero dar a impressão de que não há mistério sobre a consciência ... [b] mas não acho que esses mistérios precisam necessariamente ser resolvidos antes de podermos responder à pergunta [se as máquinas podem pensar]. " Russell e Norvig concordam: "A maioria dos pesquisadores de IA toma a hipótese de IA fraca como certa e não se preocupa com a hipótese de IA forte."

Existem alguns pesquisadores que acreditam que a consciência é um elemento essencial da inteligência, como Igor Aleksander , Stan Franklin , Ron Sun e Pentti Haikonen , embora sua definição de "consciência" se aproxime muito de "inteligência". (Veja consciência artificial .)

Antes de podermos responder a esta pergunta, devemos ter claro o que queremos dizer com "mentes", "estados mentais" e "consciência".

Consciência, mentes, estados mentais, significado

As palavras " mente " e " consciência " são usadas por diferentes comunidades de maneiras diferentes. Alguns pensadores da nova era , por exemplo, usam a palavra "consciência" para descrever algo semelhante ao " élan vital " de Bergson : um fluido invisível e energético que permeia a vida e especialmente a mente. Os escritores de ficção científica usam a palavra para descrever alguma propriedade essencial que nos torna humanos: uma máquina ou alienígena que é "consciente" será apresentada como um personagem totalmente humano, com inteligência, desejos, vontade , discernimento, orgulho e assim por diante. (Os escritores de ficção científica também usam as palavras "senciência", "sapiência", "autoconsciência" ou " fantasma " - como no Ghost no mangá Shell e na série de anime - para descrever essa propriedade humana essencial). Para outros, as palavras "mente" ou "consciência" são usadas como uma espécie de sinônimo secular para alma .

Para filósofos , neurocientistas e cientistas cognitivos , as palavras são usadas de uma forma mais precisa e mais mundana: referem-se à experiência familiar e cotidiana de ter um "pensamento na cabeça", como uma percepção, um sonho, um intenção ou um plano, e à maneira como vemos algo, sabemos algo, queremos dizer algo ou entendemos algo. “Não é difícil dar uma definição de senso comum de consciência”, observa o filósofo John Searle. O que é misterioso e fascinante não é tanto o que é, mas como é: como um pedaço de tecido adiposo e eletricidade dá origem a essa experiência (familiar) de perceber, significar ou pensar?

Os filósofos chamam isso de problema difícil da consciência . É a versão mais recente de um problema clássico da filosofia da mente denominado " problema mente-corpo ". Um problema relacionado é o problema de significado ou compreensão (que os filósofos chamam de " intencionalidade "): qual é a conexão entre nossos pensamentos e o que estamos pensando (isto é, objetos e situações no mundo)? Uma terceira questão é o problema da experiência (ou " fenomenologia "): se duas pessoas veem a mesma coisa, elas têm a mesma experiência? Ou existem coisas "dentro de suas cabeças" (chamadas " qualia ") que podem ser diferentes de pessoa para pessoa?

Os neurobiólogos acreditam que todos esses problemas serão resolvidos à medida que começarmos a identificar os correlatos neurais da consciência : a relação real entre o mecanismo em nossas cabeças e suas propriedades coletivas; como a mente, experiência e compreensão. Alguns dos mais duros críticos da inteligência artificial concordam que o cérebro é apenas uma máquina e que a consciência e a inteligência são o resultado de processos físicos no cérebro. A difícil questão filosófica é esta: pode um programa de computador, rodando em uma máquina digital que embaralha os dígitos binários de zero e um, duplicar a capacidade dos neurônios de criar mentes, com estados mentais (como entender ou perceber) e, finalmente, a experiência da consciência ?

Argumentos de que um computador não pode ter uma mente e estados mentais

Quarto chinês do Searle

John Searle nos pede para considerar um experimento de pensamento : suponha que tenhamos escrito um programa de computador que passe no teste de Turing e demonstre ação inteligente geral. Suponha, especificamente, que o programa possa conversar em chinês fluente. Escreva o programa em cartões 3x5 e dê-os a uma pessoa comum que não fale chinês. Tranque a pessoa em uma sala e faça com que siga as instruções nos cartões. Ele copia os caracteres chineses e os passa para dentro e para fora da sala por uma abertura. Do lado de fora, parecerá que a sala chinesa contém uma pessoa totalmente inteligente que fala chinês. A questão é a seguinte: há alguém (ou alguma coisa) na sala que entenda chinês? Ou seja, há alguma coisa que tem o estado mental de entender , ou que tem consciência consciência do que está sendo discutido em chinês? O homem claramente não está ciente. A sala não pode estar ciente. As cartas certamente não estão cientes. Searle conclui que a sala chinesa , ou qualquer outro sistema de símbolos físicos, não pode ter uma mente.

Searle prossegue argumentando que os estados mentais e a consciência reais requerem (ainda a serem descritos) "propriedades físico-químicas reais dos cérebros humanos reais". Ele argumenta que existem "propriedades causais" especiais de cérebros e neurônios que dão origem às mentes : em suas palavras, "cérebros causam mentes".

Argumentos relacionados: Moinho de Leibniz, central telefônica de Davis, nação chinesa de Block e Blockhead

Gottfried Leibniz apresentou essencialmente o mesmo argumento de Searle em 1714, usando o experimento mental de expandir o cérebro até ficar do tamanho de um moinho . Em 1974, Lawrence Davis imaginou duplicar o cérebro usando linhas telefônicas e escritórios operados por pessoas, e em 1978 Ned Block imaginou toda a população da China envolvida em tal simulação cerebral. Este experimento mental é chamado de "a nação chinesa" ou "o ginásio chinês". Ned Block também propôs seu argumento Blockhead , que é uma versão da sala chinesa na qual o programa foi reformulado em um conjunto simples de regras da forma "veja isso, faça aquilo", removendo todo o mistério do programa.

Respostas à sala chinesa

As respostas à sala chinesa enfatizam vários pontos diferentes.

- Os sistemas respondem e a mente virtual responde : Esta resposta argumenta que o sistema , incluindo o homem, o programa, a sala e as cartas, é o que entende o chinês. Searle afirma que o homem na sala é a única coisa que poderia "ter uma mente" ou "entender", mas outros discordam, argumentando que é possível haver duas mentes no mesmo lugar físico, semelhante à maneira um computador pode simultaneamente "ser" duas máquinas ao mesmo tempo: uma física (como um Macintosh ) e uma " virtual " (como um processador de texto ).

- Resposta de velocidade, poder e complexidade : Vários críticos apontam que o homem na sala provavelmente levaria milhões de anos para responder a uma pergunta simples e exigiria "armários de arquivo" de proporções astronômicas. Isso coloca em dúvida a clareza da intuição de Searle.

- Resposta do robô : Para entender verdadeiramente, alguns acreditam que a Sala Chinesa precisa de olhos e mãos. Hans Moravec escreve: 'Se pudéssemos enxertar um robô em um programa de raciocínio, não precisaríamos mais de uma pessoa para fornecer o significado: ele viria do mundo físico. "

- Resposta do simulador de cérebro : e se o programa simular a sequência de disparos nervosos nas sinapses de um cérebro real de um falante real de chinês? O homem na sala simularia um cérebro real. Esta é uma variação da "resposta do sistema" que parece mais plausível porque "o sistema" agora opera claramente como um cérebro humano, o que fortalece a intuição de que há algo além do homem na sala que poderia entender chinês.

- Outras mentes respondem e os epifenômenos respondem : Várias pessoas notaram que o argumento de Searle é apenas uma versão do problema de outras mentes , aplicado às máquinas. Visto que é difícil decidir se as pessoas estão "realmente" pensando, não devemos nos surpreender que seja difícil responder à mesma pergunta sobre as máquinas.

- Uma questão relacionada é se a "consciência" (como Searle a entende) existe. Searle argumenta que a experiência da consciência não pode ser detectada examinando o comportamento de uma máquina, de um ser humano ou de qualquer outro animal. Daniel Dennett aponta que a seleção natural não pode preservar uma característica de um animal que não tem efeito sobre o comportamento do animal e, portanto, a consciência (como Searle a entende) não pode ser produzida pela seleção natural. Portanto, ou a seleção natural não produziu consciência, ou a "IA forte" está correta, pois a consciência pode ser detectada pelo teste de Turing adequadamente projetado.

Pensar é uma espécie de computação?

A teoria computacional da mente ou " computacionalismo " afirma que a relação entre a mente e o cérebro é semelhante (se não idêntica) à relação entre um programa em execução e um computador. A ideia tem raízes filosóficas em Hobbes (que afirmava que o raciocínio era "nada mais que um cálculo"), Leibniz (que tentou criar um cálculo lógico de todas as ideias humanas), Hume (que pensava que a percepção poderia ser reduzida a "impressões atômicas") e até mesmo Kant (que analisou toda a experiência controlada por regras formais). A versão mais recente está associada aos filósofos Hilary Putnam e Jerry Fodor .

Esta questão se relaciona com nossas questões anteriores: se o cérebro humano é uma espécie de computador, então os computadores podem ser inteligentes e conscientes, respondendo às questões práticas e filosóficas da IA. Em termos da questão prática da IA ("Pode uma máquina exibir inteligência geral?"), Algumas versões do computacionalismo afirmam que (como escreveu Hobbes ):

- O raciocínio nada mais é do que acerto de contas.

Em outras palavras, nossa inteligência deriva de uma forma de cálculo , semelhante à aritmética . Esta é a hipótese do sistema de símbolos físicos discutida acima e implica que a inteligência artificial é possível. Em termos da questão filosófica da IA ("Pode uma máquina ter mente, estados mentais e consciência?"), A maioria das versões do computacionalismo afirmam que (como Stevan Harnad o caracteriza):

- Os estados mentais são apenas implementações de programas de computador (corretos).

Este é o "IA forte" de John Searle discutido acima, e é o verdadeiro alvo da discussão do quarto chinês (de acordo com Harnad ).

Uma máquina pode ter emoções?

Se as " emoções " são definidas apenas em termos de seu efeito no comportamento ou em como funcionam dentro de um organismo, então as emoções podem ser vistas como um mecanismo que um agente inteligente usa para maximizar a utilidade de suas ações. Dada essa definição de emoção, Hans Moravec acredita que "os robôs em geral são bastante emocionais por serem pessoas legais". O medo é uma fonte de urgência. Empatia é um componente necessário da boa interação humano-computador . Ele diz que os robôs "tentarão agradá-lo de uma maneira aparentemente altruísta porque ficarão emocionados com esse reforço positivo. Você pode interpretar isso como uma espécie de amor". Daniel Crevier escreve "O ponto de Moravec é que as emoções são apenas dispositivos para canalizar o comportamento em uma direção benéfica para a sobrevivência da espécie."

Uma máquina pode ser autoconsciente?

" Autoconsciência ", como observado acima, às vezes é usada por escritores de ficção científica como um nome para a propriedade humana essencial que torna um personagem totalmente humano. Turing remove todas as outras propriedades dos seres humanos e reduz a questão a "uma máquina pode ser o sujeito de seu próprio pensamento?" Ele pode pensar sobre si mesmo ? Visto dessa forma, um programa pode ser escrito para relatar seus próprios estados internos, como um depurador .

Uma máquina pode ser original ou criativa?

Turing reduz isso à questão de se uma máquina pode "nos pegar de surpresa" e argumenta que isso é obviamente verdade, como qualquer programador pode atestar. Ele observa que, com capacidade de armazenamento suficiente, um computador pode se comportar de uma quantidade astronômica de maneiras diferentes. Deve ser possível, até mesmo trivial, para um computador que pode representar idéias combiná-las de novas maneiras. ( O matemático automatizado de Douglas Lenat , por exemplo, combinou idéias para descobrir novas verdades matemáticas.) Kaplan e Haenlein sugerem que as máquinas podem exibir criatividade científica, embora pareça provável que os humanos terão a vantagem no que diz respeito à criatividade artística.

Em 2009, cientistas da Universidade Aberystwyth no País de Gales e da Universidade de Cambridge no Reino Unido projetaram um robô chamado Adam que eles acreditam ser a primeira máquina a apresentar de forma independente novas descobertas científicas. Também em 2009, pesquisadores da Cornell desenvolveram o Eureqa , um programa de computador que extrapola fórmulas para se ajustar aos dados inseridos, como encontrar as leis do movimento a partir do movimento de um pêndulo.

Uma máquina pode ser benevolente ou hostil?

Esta questão (como muitas outras na filosofia da inteligência artificial) pode ser apresentada de duas formas. "Hostilidade" pode ser definida em termos de função ou comportamento , caso em que "hostil" passa a ser sinônimo de "perigoso". Ou pode ser definido em termos de intenção: pode uma máquina "deliberadamente" fazer o mal? A última é a pergunta "pode uma máquina ter estados conscientes?" (como intenções ) de outra forma.

A questão de saber se máquinas altamente inteligentes e completamente autônomas seriam perigosas foi examinada em detalhes por futuristas (como o Machine Intelligence Research Institute ). O elemento óbvio do drama também tornou o assunto popular na ficção científica , que considerou muitos cenários possíveis de maneiras diferentes, onde máquinas inteligentes representam uma ameaça para a humanidade; veja Inteligência artificial na ficção .

Um problema é que as máquinas podem adquirir a autonomia e a inteligência necessárias para serem perigosas muito rapidamente. Vernor Vinge sugeriu que, em apenas alguns anos, os computadores se tornarão repentinamente milhares ou milhões de vezes mais inteligentes do que os humanos. Ele chama isso de " a Singularidade ". Ele sugere que pode ser um tanto ou possivelmente muito perigoso para os humanos. Isso é discutido por uma filosofia chamada Singularitarismo .

Em 2009, acadêmicos e especialistas técnicos participaram de uma conferência para discutir o impacto potencial de robôs e computadores e o impacto da possibilidade hipotética de que eles se tornassem autossuficientes e capazes de tomar suas próprias decisões. Eles discutiram a possibilidade e até que ponto os computadores e robôs podem ser capazes de adquirir qualquer nível de autonomia, e até que ponto eles podem usar essas habilidades para possivelmente representar qualquer ameaça ou perigo. Eles observaram que algumas máquinas adquiriram várias formas de semi-autonomia, incluindo a capacidade de encontrar fontes de energia por conta própria e a capacidade de escolher alvos para atacar com armas de forma independente. Eles também observaram que alguns vírus de computador podem escapar da eliminação e alcançar "inteligência de barata". Eles observaram que a autoconsciência, conforme retratada na ficção científica, é provavelmente improvável, mas que havia outros perigos e armadilhas potenciais.

Alguns especialistas e acadêmicos questionam o uso de robôs para combate militar, especialmente quando esses robôs recebem algum grau de funções autônomas. A Marinha dos Estados Unidos financiou um relatório que indica que, conforme os robôs militares se tornam mais complexos, deve haver maior atenção às implicações de sua capacidade de tomar decisões autônomas.

O presidente da Associação para o Avanço da Inteligência Artificial encomendou um estudo para examinar esta questão. Eles apontam para programas como o Dispositivo de Aquisição de Linguagem, que pode emular a interação humana.

Alguns sugeriram a necessidade de construir uma " IA amigável ", o que significa que os avanços que já estão ocorrendo com a IA também devem incluir um esforço para tornar a IA intrinsecamente amigável e humana.

Uma máquina pode imitar todas as características humanas?

Turing disse: "É costume ... oferecer um grão de conforto, na forma de uma declaração de que alguma característica peculiarmente humana jamais poderia ser imitada por uma máquina ... Não posso oferecer tal conforto, pois acredito que não esses limites podem ser definidos. "

Turing observou que existem muitos argumentos da forma "uma máquina nunca fará X", onde X pode ser muitas coisas, como:

Seja gentil, engenhoso, bonito, amigável, tenha iniciativa, tenha senso de humor, diferencie o certo do errado, cometa erros, apaixone-se, aprecie morangos com creme, faça alguém se apaixonar por eles, aprenda com a experiência, use as palavras corretamente , ser o sujeito de seu próprio pensamento, ter tanta diversidade de comportamento quanto um homem, fazer algo realmente novo.

Turing argumenta que essas objeções são freqüentemente baseadas em suposições ingênuas sobre a versatilidade das máquinas ou são "formas disfarçadas do argumento da consciência". Escrever um programa que exibe um desses comportamentos "não causará muita impressão". Todos esses argumentos são tangenciais à premissa básica da IA, a menos que possa ser mostrado que uma dessas características é essencial para a inteligência geral.

Uma máquina pode ter alma?

Finalmente, aqueles que acreditam na existência de uma alma podem argumentar que "Pensar é uma função da alma imortal do homem ." Alan Turing chamou isso de "objeção teológica". Ele escreve

Ao tentar construir tais máquinas, não devemos usurpar irreverentemente Seu poder de criar almas, assim como não o fazemos na procriação de filhos: antes, somos, em ambos os casos, instrumentos de Sua vontade, provendo mansões para as almas que Ele cria.

Opiniões sobre o papel da filosofia

Alguns estudiosos argumentam que a rejeição da filosofia pela comunidade de IA é prejudicial. Na Enciclopédia de Filosofia de Stanford , alguns filósofos argumentam que o papel da filosofia na IA é subestimado. O físico David Deutsch argumenta que sem uma compreensão da filosofia ou de seus conceitos, o desenvolvimento da IA sofreria com a falta de progresso.

Conferências

A principal série de conferências sobre o assunto é "Filosofia e Teoria da IA" (PT-AI), dirigida por Vincent C. Müller .

A principal bibliografia sobre o assunto, com várias subseções, está no PhilPapers .

Veja também

- Aquisição de IA

- Cérebro artificial

- Consciência artificial

- Inteligência artificial

- Rede neural artificial

- Chatterbot

- Sala chinesa

- Teoria computacional da mente

- Maquinário de Computação e Inteligência

- A crítica de Dreyfus à inteligência artificial

- Risco existencial de inteligência artificial avançada

- Funcionalismo

- Sistema multiagente

- Filosofia da Ciência da Computação

- Filosofia da informação

- Filosofia da mente

- Sistema de símbolo físico

- Realidade simulada

- Superinteligência: caminhos, perigos, estratégias

- Inteligência sintética

Notas

Referências

Referências

- Adam, Alison (1989). Conhecimento Artificial: Gênero e a Máquina Pensante. Routledge & CRC Press . https://www.routledge.com/Artificial-Knowing-Gender-and-the-Thinking-Machine/Adam/p/book/9780415129633

- Benjamin, Ruha (2019). Corrida após tecnologia: ferramentas abolicionistas para o novo código Jim . Wiley. ISBN 978-1-509-52643-7

- Blackmore, Susan (2005), Consciousness: A Very Short Introduction , Oxford University Press

- Bostrom, Nick (2014), Superintelligence: Paths, Dangers, Strategies , Oxford University Press, ISBN 978-0-19-967811-2

- Brooks, Rodney (1990), "Elephants Don't Play Chess" (PDF) , Robotics and Autonomous Systems , 6 (1-2): 3-15, CiteSeerX 10.1.1.588.7539 , doi : 10.1016 / S0921-8890 ( 05) 80025-9 , recuperado 2007-08-30

- Bryson, Joanna (2019). A Inteligência Arti fi cial da Ética da Inteligência Arti fi cial: Uma Visão Geral Introdutória para Direito e Regulamentação, 34.

- Chalmers, David J (1996), The Conscious Mind: In Search of a Fundamental Theory , Oxford University Press, Nova York, ISBN 978-0-19-511789-9

- Cole, David (outono de 2004), "The Chinese Room Argument", em Zalta, Edward N. (ed.), The Stanford Encyclopedia of Philosophy.

- Crawford, Kate (2021). O Atlas da IA: Poder, Política e os Custos Planetários da Inteligência Artificial . Yale University Press.

- Crevier, Daniel (1993). AI: The Tumultuous Search for Artificial Intelligence . Nova York, NY: BasicBooks. ISBN 0-465-02997-3.

- Dennett, Daniel (1991), Consciousness Explained , The Penguin Press, ISBN 978-0-7139-9037-9

- Dreyfus, Hubert (1972), What Computers Can't Do , New York: MIT Press, ISBN 978-0-06-011082-6

- Dreyfus, Hubert (1979), What Computers Still Can't Do , New York: MIT Press.

- Dreyfus, Hubert ; Dreyfus, Stuart (1986), Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer , Oxford, Reino Unido: Blackwell

- Fearn, Nicholas (2007), The Latest Answers to the Oldest Questions: A Philosophical Adventure with World Greatest Thinkers , Nova York: Grove Press

- Gladwell, Malcolm (2005), Blink: The Power of Thinking Without Thinking , Boston: Little, Brown, ISBN 978-0-316-17232-5.

- Harnad, Stevan (2001), "What's Wrong and Right About Searle's Chinese Room Argument?", Em Bishop, M .; Preston, J. (eds.), Essays on Searle's Chinese Room Argument , Oxford University Press

- Haraway, Donna (1985). Um Manifesto Cyborg .

- Haugeland, John (1985), Artificial Intelligence: The Very Idea , Cambridge, Mass .: MIT Press.

- Hofstadter, Douglas (1979), Gödel, Escher, Bach: an Eternal Golden Braid.

- Horst, Steven (2009), "The Computational Theory of Mind", em Zalta, Edward N. (ed.), The Stanford Encyclopedia of Philosophy , Metaphysics Research Lab, Stanford University.

- Kaplan, Andreas ; Haenlein, Michael (2018), "Siri, Siri in my Hand, who's the Fairest in the Land? On the Interpretations, Illustrations and Implications of Artificial Intelligence", Business Horizons , 62 : 15-25, doi : 10.1016 / j.bushor .2018.08.004

- Kurzweil, Ray (2005), The Singularity is Near , Nova York: Viking Press, ISBN 978-0-670-03384-3.

- Lucas, John (1961), "Minds, Machines and Gödel", em Anderson, AR (ed.), Minds and Machines.

- Malabou, Catherine (2019). Morphing Intelligence: From IQ Measurement to Artificial Brains . (C. Shread, Trans.). Columbia University Press.

- McCarthy, John ; Minsky, Marvin ; Rochester, Nathan ; Shannon, Claude (1955), A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence , arquivado do original em 2008-09-30.

- McDermott, Drew (14 de maio de 1997), "How Intelligent is Deep Blue" , New York Times , arquivado do original em 4 de outubro de 2007 , recuperado em 10 de outubro de 2007

- Moravec, Hans (1988), Mind Children , Harvard University Press

- Penrose, Roger (1989), The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics , Oxford University Press, ISBN 978-0-14-014534-2

- Russell, Stuart J .; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2ª ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2

- Searle, John (1980), "Minds, Brains and Programs" (PDF) , Behavioral and Brain Sciences , 3 (3): 417–457, doi : 10.1017 / S0140525X00005756 , arquivado do original (PDF) em 2015-09- 23

- Searle, John (1992), The Rediscovery of the Mind , Cambridge, Massachusetts: MIT Press

- Searle, John (1999), Mind, language and society , New York, NY: Basic Books, ISBN 978-0-465-04521-1, OCLC 231867665

- Turing, Alan (outubro 1950), "Computing Machinery and Intelligence", Mind , LIX (236): 433-460, doi : 10.1093 / mind / LIX.236.433 , ISSN 0026-4423

- Yee, Richard (1993), "Turing Machines And Semantic Symbol Processing: Why Real Computers Don't Mind Chinese Emperors" (PDF) , Lyceum , 5 (1): 37–59

- Os números das páginas acima e o conteúdo do diagrama referem-se à impressão em PDF do artigo no Lyceum .