Matriz (matemática) - Matrix (mathematics)

Em matemática , uma matriz ( matrizes plurais ) é uma matriz retangular ou tabela de números , símbolos ou expressões , dispostos em linhas e colunas, que é usada para representar um objeto matemático ou uma propriedade de tal objeto. Por exemplo,

é uma matriz com duas linhas e três colunas; costuma-se dizer uma "matriz dois por três", uma "matriz 2 × 3 " ou uma matriz de dimensão 2 × 3 .

Sem especificações adicionais, as matrizes representam mapas lineares e permitem cálculos explícitos em álgebra linear . Portanto, o estudo de matrizes é uma grande parte da álgebra linear, e a maioria das propriedades e operações da álgebra linear abstrata podem ser expressas em termos de matrizes. Por exemplo, a multiplicação de matrizes representa a composição de mapas lineares.

Nem todas as matrizes estão relacionadas à álgebra linear. Esse é, em particular, o caso da teoria dos grafos , das matrizes de incidência e das matrizes de adjacência . Este artigo enfoca matrizes relacionadas à álgebra linear e, a menos que especificado de outra forma, todas as matrizes representam mapas lineares ou podem ser vistas como tal.

Matrizes quadradas , matrizes com o mesmo número de linhas e colunas, desempenham um papel importante na teoria das matrizes. Matrizes quadradas de uma determinada dimensão formam um anel não comutativo , que é um dos exemplos mais comuns de anel não comutativo. O determinante de uma matriz quadrada é um número associado à matriz, que é fundamental para o estudo de uma matriz quadrada; por exemplo, uma matriz quadrada é invertível se e somente se ela tem um determinante diferente de zero, e os autovalores de uma matriz quadrada são as raízes de um determinante polinomial .

Na geometria , as matrizes são amplamente utilizadas para especificar e representar transformações geométricas (por exemplo, rotações ) e mudanças de coordenadas . Na análise numérica , muitos problemas computacionais são resolvidos reduzindo-os a uma computação de matriz, e isso envolve frequentemente computar com matrizes de grande dimensão. As matrizes são usadas na maioria das áreas da matemática e na maioria dos campos científicos, seja diretamente ou por meio de seu uso em geometria e análise numérica.

Definição

Uma matriz é uma matriz retangular de números (ou outros objetos matemáticos) para a qual operações como adição e multiplicação são definidas. Mais vulgarmente, um matriz ao longo de um campo F é uma matriz rectangular de escalares, cada um dos quais é um membro de F . Uma matriz real e uma matriz complexa são matrizes cujas entradas são, respectivamente, números reais ou números complexos . Tipos mais gerais de entradas são discutidos abaixo . Por exemplo, esta é uma matriz real:

Os números, símbolos ou expressões na matriz são chamados de suas entradas ou seus elementos . As linhas horizontais e verticais de entradas em uma matriz são chamadas de linhas e colunas , respectivamente.

Tamanho

O tamanho de uma matriz é definido pelo número de linhas e colunas que ela contém. Não há limite para o número de linhas e colunas que uma matriz (no sentido usual) pode ter, desde que sejam inteiros positivos. Uma matriz com m linhas e n colunas é chamado um m × n matriz, ou m -by- n matriz, enquanto que m e n são chamados as suas dimensões . Por exemplo, a matriz A acima é uma matriz 3 × 2.

Matrizes com uma única linha são chamadas de vetores de linha e aquelas com uma única coluna são chamadas de vetores de coluna . Uma matriz com o mesmo número de linhas e colunas é chamada de matriz quadrada . Uma matriz com um número infinito de linhas ou colunas (ou ambas) é chamada de matriz infinita . Em alguns contextos, como programas de álgebra de computador , é útil considerar uma matriz sem linhas ou colunas, chamada de matriz vazia .

| Nome | Tamanho | Exemplo | Descrição |

|---|---|---|---|

| Vetor linha | 1 × n | Uma matriz com uma linha, às vezes usada para representar um vetor | |

| Vetor coluna | n × 1 | Uma matriz com uma coluna, às vezes usada para representar um vetor | |

| Matriz quadrada | n × n | Uma matriz com o mesmo número de linhas e colunas, às vezes usada para representar uma transformação linear de um espaço vetorial para si mesmo, como reflexão , rotação ou cisalhamento . |

Notação

As matrizes são comumente escritas em colchetes ou parênteses :

As especificidades da notação de matriz simbólica variam amplamente, com algumas tendências predominantes. As matrizes são geralmente simbolizado usando maiúsculas letras (tal como um dos exemplos acima), enquanto o correspondente minúsculas letras, com dois índices subscritos (por exemplo, um 11 , ou um 1,1 ), representam as entradas. Além de usar letras maiúsculas para simbolizar matrizes, muitos autores usam um estilo tipográfico especial , comumente em negrito vertical (não itálico), para distinguir ainda mais as matrizes de outros objetos matemáticos. Uma notação alternativa envolve o uso de um sublinhado duplo com o nome da variável, com ou sem negrito (como no caso de ).

A entrada na i -ésima linha e j -ésima coluna de uma matriz A é às vezes referida como i , j , ( i , j ) ou ( i , j ) ésima entrada da matriz, e mais comumente denotada como a i , j ou a ij . Notações alternativas para essa entrada são A [ i, j ] ou A i, j . Por exemplo, a entrada (1,3) da seguinte matriz A é 5 (também denotado a 13 , a 1,3 , A [ 1,3 ] ou A 1,3 ):

Às vezes, as entradas de uma matriz podem ser definidas por uma fórmula como a i , j = f ( i , j ). Por exemplo, cada uma das entradas da seguinte matriz A é determinada pela fórmula a ij = i - j .

Nesse caso, a própria matriz às vezes é definida por essa fórmula, entre colchetes ou parênteses duplos. Por exemplo, a matriz acima é definida como A = [ i - j ] ou A = (( i - j )). Se o tamanho da matriz é m × n , a fórmula acima mencionada f ( i , j ) é válida para qualquer i = 1, ..., m e qualquer j = 1, ..., n . Isso pode ser especificado separadamente ou indicado usando m × n como um subscrito. Por exemplo, a matriz A acima é 3 × 4 e pode ser definida como A = [ i - j ] ( i = 1, 2, 3; j = 1, ..., 4) ou A = [ i - j ] 3 × 4 .

Algumas linguagens de programação utilizam matrizes duplamente subscritas (ou matrizes de matrizes) para representar uma matriz m - × - n . Algumas linguagens de programação iniciam a numeração de índices de array em zero, caso em que as entradas de uma matriz m -by- n são indexadas por 0 ≤ i ≤ m - 1 e 0 ≤ j ≤ n - 1 . Este artigo segue a convenção mais comum na escrita matemática, em que a enumeração começa em 1.

Um asterisco é ocasionalmente usado para se referir a linhas ou colunas inteiras em uma matriz. Por exemplo, um i , * refere-se ao i º fileira de um , e um *, j refere-se ao j º coluna de Uma .

O conjunto de todas as matrizes reais m -by- n é frequentemente denotado ou O conjunto de todas as matrizes m -by- n matrizes sobre outro campo ou sobre um anel R , é igualmente denotado ou Se m = n , isto é, no caso de matrizes quadradas , não se repete a dimensão: ou Freqüentemente, é usado no lugar de

Operações básicas

| Vídeo externo | |

|---|---|

|

|

Existem várias operações básicas que podem ser aplicadas para modificar matrizes, chamadas adição de matrizes , multiplicação escalar , transposição , multiplicação de matrizes , operações de linha e submatriz .

Adição, multiplicação escalar e transposição

| Operação | Definição | Exemplo |

|---|---|---|

| Adição | A soma A + B de duas matrizes m -by- n A e B é calculada no sentido de entrada:

|

|

| Multiplicação escalar | O produto c A de um número c (também chamado de escalar no jargão da álgebra abstrata ) e uma matriz A é calculado multiplicando cada entrada de A por c :

Essa operação é chamada de multiplicação escalar , mas seu resultado não é denominado "produto escalar" para evitar confusão, já que "produto escalar" às vezes é usado como sinônimo de " produto interno ". |

|

| Transposição | A transposição de um m -by- n matriz A é a n -by- m matriz Um t (também denotado Um tr ou t A ) formado por transformar linhas em colunas e vice-versa:

|

Propriedades familiares de números estender para estas operações de matrizes: por exemplo, a adição é conmutativo , isto é, a soma de matriz não depende da ordem dos summands: A + B = B + A . A transposição é compatível com adição e multiplicação escalar, tal como expresso por ( c A ) t = c ( A T ) e ( A + B ) T = A T + B T . Finalmente, ( A T ) T = Uma .

Multiplicação da matriz

A multiplicação de duas matrizes é definida se e somente se o número de colunas da matriz esquerda for igual ao número de linhas da matriz direita. Se A é uma matriz m -by- n e B é uma matriz n -by- p , então seu produto de matriz AB é a matriz m -by- p cujas entradas são dadas pelo produto escalar da linha correspondente de A e o correspondente coluna de B :

onde 1 ≤ i ≤ m e 1 ≤ j ≤ p . Por exemplo, a entrada sublinhada 2340 no produto é calculada como (2 × 1000) + (3 × 100) + (4 × 10) = 2340:

A multiplicação de matrizes satisfaz as regras ( AB ) C = A ( BC ) ( associatividade ), e ( A + B ) C = AC + BC , bem como C ( A + B ) = CA + CB ( distributividade esquerda e direita ), sempre que o tamanho das matrizes é tal que os vários produtos são definidos. O produto AB pode ser definido sem que BA seja definido, ou seja, se A e B são matrizes m- by- n e n -by- k , respectivamente, e m ≠ k . Mesmo se ambos os produtos forem definidos, eles geralmente não precisam ser iguais, ou seja:

- AB ≠ BA ,

Em outras palavras, a multiplicação da matriz não é comutativa , em contraste marcante com os números (racionais, reais ou complexos), cujo produto é independente da ordem dos fatores. Um exemplo de duas matrizes que não se deslocam entre si é:

enquanto que

Além da multiplicação de matrizes comum que acabamos de descrever, outras operações usadas com menos frequência em matrizes que podem ser consideradas formas de multiplicação também existem, como o produto de Hadamard e o produto de Kronecker . Eles surgem na solução de equações matriciais, como a equação de Sylvester .

Operações de linha

Existem três tipos de operações de linha:

- adição de linha, isto é, adicionar uma linha a outra.

- multiplicação de linha, que é a multiplicação de todas as entradas de uma linha por uma constante diferente de zero;

- troca de linha, que é a troca de duas linhas de uma matriz;

Essas operações são usadas de várias maneiras, incluindo resolver equações lineares e encontrar matrizes inversas .

Submatriz

Uma submatriz de uma matriz é obtida excluindo qualquer coleção de linhas e / ou colunas. Por exemplo, a partir da seguinte matriz 3 por 4, podemos construir uma submatriz 2 por 3 removendo a linha 3 e a coluna 2:

Os menores e cofatores de uma matriz são encontrados calculando o determinante de certas submatrizes.

Uma submatriz principal é uma submatriz quadrada obtida removendo certas linhas e colunas. A definição varia de autor para autor. De acordo com alguns autores, uma submatriz principal é uma submatriz em que o conjunto de índices de linha que permanece é o mesmo que o conjunto de índices de coluna que permanece. Outros autores definem uma submatriz principal como aquela em que as primeiras k linhas e colunas, para algum número k , são as que permanecem; esse tipo de submatriz também foi chamado de submatriz principal líder .

Equações lineares

As matrizes podem ser usadas para escrever e trabalhar de forma compacta com várias equações lineares, ou seja, sistemas de equações lineares. Por exemplo, se A é uma matriz m -by- n , x designa um vetor coluna (ou seja, n × 1-matriz) de n variáveis x 1 , x 2 , ..., x n e b é um m × vetor de 1 coluna, então a equação da matriz

é equivalente ao sistema de equações lineares

Usando matrizes, isso pode ser resolvido de forma mais compacta do que seria possível escrevendo todas as equações separadamente. Se n = m e as equações são independentes , então isso pode ser feito por escrito

onde Uma -1 é a matriz inversa de A . Se A não tem inverso, soluções - se houver - podem ser encontradas usando seu inverso generalizado .

Transformações lineares

Matrizes e multiplicação de matrizes revelam suas características essenciais quando relacionadas às transformações lineares , também conhecidas como mapas lineares . Uma matriz A m -by- n real dá origem a uma transformação linear R n → R m mapeando cada vetor x em R n para o produto (matriz) Ax , que é um vetor em R m . Por outro lado, cada transformação linear f : R n → R m surge a partir de uma única m -by- n matriz A : explicitamente, a ( i , j ) -Entrada de A é o i th coordenadas de f ( e j ), onde E j = (0, ..., 0,1,0, ..., 0) é o vetor unitário com 1 na j ésima posição e 0 em outro lugar. Diz-se que a matriz A representa o mapa linear f , e A é chamada de matriz de transformação de f .

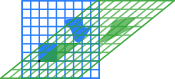

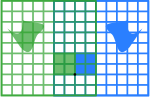

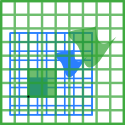

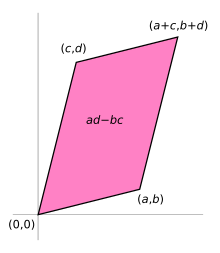

Por exemplo, a matriz 2 × 2

pode ser visto como a transformação do quadrado da unidade em um paralelogramo com vértices em (0, 0) , ( a , b ) , ( a + c , b + d ) e ( c , d ) . O paralelogramo ilustrado à direita é obtido multiplicando A com cada um dos vetores da coluna , e por sua vez. Esses vetores definem os vértices do quadrado da unidade.

A tabela a seguir mostra várias matrizes reais 2 × 2 com os mapas lineares associados de R 2 . O original azul é mapeado para a grade e as formas verdes. A origem (0,0) é marcada com um ponto preto.

|

Cisalhamento horizontal com m = 1,25. |

Reflexão através do eixo vertical |

Mapeamento de compressão com r = 3/2 |

Escala por um fator de 3/2 |

Rotação por π / 6 = 30 ° |

|

|

|

|

|

Sob a correspondência 1-para-1 entre matrizes e mapas lineares, a multiplicação da matriz corresponde à composição dos mapas: se uma matriz k -by- m B representa outro mapa linear g : R m → R k , então a composição g ∘ f é representado por BA desde

- ( g ∘ f ) ( x ) = g ( f ( x )) = g ( Ax ) = B ( Ax ) = ( BA ) x .

A última igualdade decorre da associatividade da multiplicação de matrizes mencionada acima.

A classificação de uma matriz A é o número máximo de vetores linha linearmente independentes da matriz, que é igual ao número máximo de vetores coluna linearmente independentes. Equivalentemente é a dimensão da imagem do mapa linear representado por A . O teorema da nulidade da classificação afirma que a dimensão do núcleo de uma matriz mais a classificação é igual ao número de colunas da matriz.

Matriz quadrada

Uma matriz quadrada é uma matriz com o mesmo número de linhas e colunas. Um n -by- n matriz é conhecida como uma matriz quadrada de ordem n. Quaisquer duas matrizes quadradas da mesma ordem podem ser adicionadas e multiplicadas. As entradas a ii formam a diagonal principal de uma matriz quadrada. Eles estão na linha imaginária que vai do canto superior esquerdo ao canto inferior direito da matriz.

Tipos principais

Nome Exemplo com n = 3 Matriz diagonal Matriz triangular inferior Matriz triangular superior

Matriz diagonal e triangular

Se todas as entradas de A abaixo da diagonal principal forem zero, A é chamado de matriz triangular superior . Da mesma forma, se todas as entradas de A acima da diagonal principal forem zero, A é chamado de matriz triangular inferior . Se todas as entradas fora da diagonal principal forem zero, A é chamado de matriz diagonal .

Matriz de identidade

A matriz de identidade eu n de tamanho n é o n -by- n matriz na qual todos os elementos da diagonal principal são iguais a um e todos os outros elementos são iguais a 0, por exemplo,

É uma matriz quadrada de ordem ne também um tipo especial de matriz diagonal . É chamada de matriz de identidade porque a multiplicação com ela deixa uma matriz inalterada:

- AI n = I m A = A para qualquermatriz A m- by- n .

Um múltiplo escalar diferente de zero de uma matriz de identidade é chamado de matriz escalar . Se as entradas da matriz vêm de um campo, as matrizes escalares formam um grupo, sob multiplicação de matriz, que é isomórfico ao grupo multiplicativo de elementos diferentes de zero do campo.

Matriz simétrica ou assimétrica

Uma matriz quadrada A que é igual a sua transposta, isto é, um = A T , é uma matriz simétrica . Se, em vez disso, A for igual ao negativo de sua transposta, ou seja, A = - A T , então A é uma matriz assimétrica . Em matrizes complexas, simetria é muitas vezes substituído pelo conceito de matrizes hermitianas , que satisfazem Um * = A , onde a estrela ou asterisco indica a transposta conjugada da matriz, isto é, a transposição do conjugado complexo de uma .

Pelo teorema espectral , as matrizes simétricas reais e as matrizes Hermitianas complexas têm uma base própria ; ou seja, todo vetor pode ser expresso como uma combinação linear de autovetores. Em ambos os casos, todos os autovalores são reais. Este teorema pode ser generalizado para situações de dimensão infinita relacionadas a matrizes com infinitas linhas e colunas, veja abaixo .

Matriz invertível e seu inverso

Uma matriz quadrada A é chamada invertível ou não singular se existe uma matriz B tal que

- AB = BA = I n ,

em que I n representa o n x n matriz de identidade com 1s na diagonal principal e 0s em qualquer outro local. Se B existe, ele é único e é chamado de matriz inversa de A , denotada por A −1 .

Matriz definida

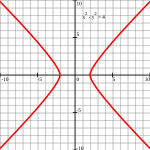

| Matriz definitiva positiva | Matriz indefinida |

|---|---|

| Q ( x , y ) = 1/4 x 2 + y 2 | Q ( x , y ) =1/4 x 2 - 1/4 y 2 |

Pontos tais que Q ( x , y ) = 1 ( Elipse ). |

Pontos tais que Q ( x , y ) = 1 ( Hipérbole ). |

Uma matriz real simétrica A é chamada de definida positiva se a forma quadrática associada

- f ( x ) = x T A x

tem um valor positivo para cada vetor x diferente de zero em R n . Se f ( x ) produz apenas valores negativos, então A é definido como negativo ; se f produzir valores negativos e positivos, então A é indefinido . Se a forma quadrática f produzir apenas valores não negativos (positivos ou zero), a matriz simétrica é chamada de semidefinida positiva (ou se apenas valores não positivos, semidefinida negativa); portanto, a matriz é indefinida precisamente quando não é semidefinida positiva nem semidefinida negativa.

Uma matriz simétrica é definida positivamente se e somente se todos os seus autovalores forem positivos, ou seja, a matriz é semidefinida positiva e é invertível. A tabela à direita mostra duas possibilidades para matrizes 2 por 2.

Permitir como entrada dois vetores diferentes, em vez disso, resulta na forma bilinear associada a A :

- B A ( x , y ) = x T Ay .

No caso de matrizes complexas, a mesma terminologia e resultado aplicar, com matriz simétrica , forma quadrática , forma bilinear , e transposta x T substituídos, respectivamente, por matriz Hermitiana , forma Hermitiana , forma sesquilinear , e transposta conjugada x H .

Matriz ortogonal

Uma matriz ortogonal é uma matriz quadrada com entradas reais cujas colunas e linhas são vetores unitários ortogonais (ou seja, vetores ortonormais ). De forma equivalente, uma matriz A é ortogonal se sua transposta for igual a sua inversa :

que envolve

onde I n é a matriz identidade de tamanho n .

Uma matriz ortogonal Uma é necessariamente invertível (com inversa Uma -1 = A T ), unitária ( A -1 = A * ) e normais ( A * A = AA * ). O determinante de qualquer matriz ortogonal é +1 ou -1 . Uma matriz ortogonal especial é uma matriz ortogonal com determinante +1. Como uma transformação linear , toda matriz ortogonal com determinante +1 é uma rotação pura sem reflexão, ou seja, a transformação preserva a orientação da estrutura transformada, enquanto toda matriz ortogonal com determinante -1 inverte a orientação, ou seja, é uma composição de um reflexão pura e uma rotação (possivelmente nula). As matrizes de identidade têm determinante 1 e são rotações puras por um ângulo zero.

O análogo complexo de uma matriz ortogonal é uma matriz unitária .

Operações principais

Vestígio

O traço , tr ( A ) de uma matriz quadrada A é a soma de suas entradas diagonais. Embora a multiplicação da matriz não seja comutativa como mencionado acima , o traço do produto de duas matrizes é independente da ordem dos fatores:

- tr ( AB ) = tr ( BA ).

Isso é imediato a partir da definição de multiplicação de matrizes:

Segue-se que o traço do produto de mais de duas matrizes é independente das permutações cíclicas das matrizes, no entanto, isso não se aplica em geral a permutações arbitrárias (por exemplo, tr ( ABC ) ≠ tr ( BAC ), em geral). Além disso, o traço de uma matriz é igual ao de sua transposta, ou seja,

- tr ( A ) = tr ( A T ) .

Determinante

O determinante de uma matriz quadrada A (denotado det ( A ) ou | A |) é um número que codifica certas propriedades da matriz. Uma matriz é invertível se e somente se seu determinante for diferente de zero. Seu valor absoluto é igual à área (em R 2 ) ou volume (em R 3 ) da imagem do quadrado unitário (ou cubo), enquanto seu sinal corresponde à orientação do mapa linear correspondente: o determinante é positivo se e somente se a orientação for preservada.

O determinante das matrizes 2 por 2 é dado por

O determinante de matrizes 3 por 3 envolve 6 termos ( regra de Sarrus ). A fórmula de Leibniz mais longa generaliza essas duas fórmulas para todas as dimensões.

O determinante de um produto de matrizes quadradas é igual ao produto de seus determinantes:

- det ( AB ) = det ( A ) · det ( B ).

Adicionar um múltiplo de qualquer linha a outra linha ou um múltiplo de qualquer coluna a outra coluna não altera o determinante. A troca de duas linhas ou duas colunas afeta o determinante, multiplicando-o por -1. Usando essas operações, qualquer matriz pode ser transformada em uma matriz triangular inferior (ou superior) e, para tais matrizes, o determinante é igual ao produto das entradas na diagonal principal; isso fornece um método para calcular o determinante de qualquer matriz. Finalmente, a expansão de Laplace expressa o determinante em termos de menores , ou seja, determinantes de matrizes menores. Esta expansão pode ser usada para uma definição recursiva de determinantes (tomando como caso inicial o determinante de uma matriz 1 por 1, que é sua entrada única, ou mesmo o determinante de uma matriz 0 por 0, que é 1) , que pode ser visto como equivalente à fórmula de Leibniz. Os determinantes podem ser usados para resolver sistemas lineares usando a regra de Cramer , onde a divisão dos determinantes de duas matrizes quadradas relacionadas é igual ao valor de cada uma das variáveis do sistema.

Autovalores e autovetores

Um número λ e um vetor diferente de zero v satisfazendo

são chamados de autovalor e autovetor de A , respectivamente. O número λ é um autovalor de uma n × n -matriz A se e somente se A −λ I n não é invertível, o que é equivalente a

O polinómio p Um num indeterminado X determinado por avaliação da det determinante ( X I N - A ) é chamado o polinómio característico de um . É um polinômio mônico de grau n . Portanto, a equação polinomial p A (λ) = 0 possui no máximo n soluções diferentes, ou seja, autovalores da matriz. Eles podem ser complexos, mesmo se as entradas de A forem reais. De acordo com o teorema de Cayley-Hamilton , p A ( A ) = 0 , ou seja, o resultado da substituição da própria matriz em seu próprio polinômio característico produz a matriz zero .

Aspectos computacionais

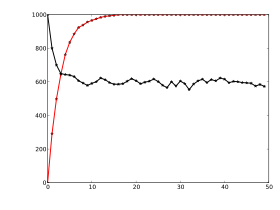

Cálculos de matriz podem ser executados frequentemente com técnicas diferentes. Muitos problemas podem ser resolvidos por algoritmos diretos ou abordagens iterativas. Por exemplo, os vetores próprios de uma matriz quadrada podem ser obtidos encontrando uma sequência de vetores x n convergindo para um vetor próprio quando n tende ao infinito .

Para escolher o algoritmo mais apropriado para cada problema específico, é importante determinar a eficácia e a precisão de todos os algoritmos disponíveis. O domínio que estuda esses assuntos é chamado de álgebra linear numérica . Como em outras situações numéricas, dois aspectos principais são a complexidade dos algoritmos e sua estabilidade numérica .

Determinar a complexidade de um algoritmo significa encontrar limites superiores ou estimativas de quantas operações elementares, como adições e multiplicações de escalares, são necessárias para realizar algum algoritmo, por exemplo, multiplicação de matrizes . Calculando o produto matricial de dois n -by- n matrizes utilizando a definição dada acima necessidades n 3 multiplicações, uma vez que para qualquer um dos n 2 entradas do produto, n são necessárias multiplicações. O algoritmo Strassen supera esse algoritmo "ingênuo"; ele precisa apenas de n 2.807 multiplicações. Uma abordagem refinada também incorpora recursos específicos dos dispositivos de computação.

Em muitas situações práticas, informações adicionais sobre as matrizes envolvidas são conhecidas. Um caso importante são as matrizes esparsas , ou seja, as matrizes cujas entradas são, em sua maioria, zero. Existem algoritmos especificamente adaptados para, digamos, resolver sistemas lineares Ax = b para matrizes esparsas A , como o método do gradiente conjugado .

Um algoritmo é, grosso modo, numericamente estável, se pequenos desvios nos valores de entrada não levarem a grandes desvios no resultado. Por exemplo, calcular o inverso de uma matriz via expansão de Laplace (adj ( A ) denota a matriz adjugada de A )

- A -1 = adj ( A ) / det ( A )

pode levar a erros de arredondamento significativos se o determinante da matriz for muito pequeno. A norma de uma matriz pode ser usada para capturar o condicionamento de problemas algébricos lineares, como calcular o inverso de uma matriz.

A maioria das linguagens de programação de computador oferece suporte a matrizes, mas não são projetadas com comandos embutidos para matrizes. Em vez disso, as bibliotecas externas disponíveis fornecem operações de matriz em matrizes, em quase todas as linguagens de programação usadas atualmente. A manipulação de matrizes foi uma das primeiras aplicações numéricas dos computadores. O Dartmouth BASIC original tinha comandos embutidos para aritmética de matriz em matrizes de sua implementação da segunda edição em 1964. Já na década de 1970, alguns computadores desktop de engenharia, como o HP 9830, tinham cartuchos ROM para adicionar comandos BASIC para matrizes . Algumas linguagens de computador, como APL, foram projetadas para manipular matrizes, e vários programas matemáticos podem ser usados para auxiliar na computação com matrizes.

Decomposição

Existem vários métodos para renderizar matrizes em uma forma mais facilmente acessível. Eles são geralmente referidos como técnicas de decomposição de matriz ou de fatoração de matriz . O interesse de todas essas técnicas é que preservam certas propriedades das matrizes em questão, como determinante, posto ou inverso, de modo que essas quantidades possam ser calculadas após a aplicação da transformação, ou que certas operações de matriz sejam algoritmicamente mais fáceis de realizar para alguns tipos de matrizes.

As matrizes de fatores de decomposição LU como um produto de matrizes triangulares inferior ( L ) e superior ( U ). Uma vez calculada essa decomposição, os sistemas lineares podem ser resolvidos de maneira mais eficiente, por uma técnica simples chamada substituição direta e posterior . Da mesma forma, inversos de matrizes triangulares são algoritmicamente mais fáceis de calcular. A eliminação gaussiana é um algoritmo semelhante; ele transforma qualquer matriz em forma escalonada de linha . Ambos os métodos procedem multiplicando a matriz por matrizes elementares adequadas , que correspondem a permutar linhas ou colunas e adicionar múltiplos de uma linha a outra linha. A decomposição de valores singulares expressa qualquer matriz A como um produto UDV ∗ , onde U e V são matrizes unitárias e D é uma matriz diagonal.

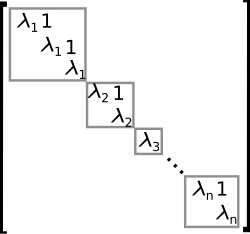

A decomposição automática ou diagonalização expressa A como um produto VDV −1 , onde D é uma matriz diagonal e V é uma matriz invertível adequada. Se A puder ser escrito desta forma, é denominado diagonalizável . Mais geralmente, e aplicável a todas as matrizes, a decomposição de Jordan transforma uma matriz na forma normal de Jordan , ou seja, matrizes cujas únicas entradas diferentes de zero são os valores próprios λ 1 a λ n de A , colocados na diagonal principal e possivelmente entradas iguais a um diretamente acima da diagonal principal, conforme mostrado à direita. Dada a eigendecomposition, o n ° de alimentação de um (isto é, n vezes de iterado matriz multiplicação) pode ser calculado através

- A n = ( VDV −1 ) n = VDV −1 VDV −1 ... VDV −1 = VD n V −1

eo poder de uma matriz diagonal pode ser calculada tomando os poderes correspondentes das entradas diagonais, que é muito mais fácil do que fazer a exponenciação para uma vez. Isso pode ser usado para calcular a matriz exponencial e A , uma necessidade que surge frequentemente na resolução de equações diferenciais lineares , logaritmos de matrizes e raízes quadradas de matrizes . Para evitar situações numericamente mal condicionadas , outros algoritmos, como a decomposição de Schur, podem ser empregados.

Aspectos algébricos abstratos e generalizações

As matrizes podem ser generalizadas de diferentes maneiras. A álgebra abstrata usa matrizes com entradas em campos mais gerais ou mesmo anéis , enquanto a álgebra linear codifica propriedades de matrizes na noção de mapas lineares. É possível considerar matrizes com infinitas colunas e linhas. Outra extensão são os tensores , que podem ser vistos como matrizes de números em dimensões superiores, em oposição a vetores, que muitas vezes podem ser realizados como sequências de números, enquanto as matrizes são matrizes de números retangulares ou bidimensionais. As matrizes, sujeitas a certos requisitos, tendem a formar grupos conhecidos como grupos de matrizes. Da mesma forma, sob certas condições, as matrizes formam anéis conhecidos como anéis de matriz . Embora o produto de matrizes não seja em geral comutativo, certas matrizes formam campos conhecidos como campos de matriz .

Matrizes com entradas mais gerais

Este artigo enfoca matrizes cujas entradas são números reais ou complexos. No entanto, as matrizes podem ser consideradas com tipos de entradas muito mais gerais do que números reais ou complexos. Como uma primeira etapa de generalização, qualquer campo , isto é, um conjunto onde as operações de adição , subtração , multiplicação e divisão são definidas e bem comportadas, pode ser usado em vez de R ou C , por exemplo, números racionais ou campos finitos . Por exemplo, a teoria da codificação faz uso de matrizes sobre campos finitos. Onde quer que os autovalores sejam considerados, como são raízes de um polinômio, eles podem existir apenas em um campo maior do que o das entradas da matriz; por exemplo, eles podem ser complexos no caso de uma matriz com entradas reais. A possibilidade de reinterpretar as entradas de uma matriz como elementos de um campo maior (por exemplo, para ver uma matriz real como uma matriz complexa cujas entradas são todas reais), então, permite considerar que cada matriz quadrada possui um conjunto completo de autovalores. Alternativamente, pode-se considerar apenas matrizes com entradas em um campo algébricamente fechado , como C , desde o início.

De maneira mais geral, matrizes com entradas em um anel R são amplamente utilizadas em matemática. Os anéis são uma noção mais geral do que os campos, pois não é necessário que exista uma operação de divisão. As mesmas operações de adição e multiplicação de matrizes também se estendem a essa configuração. O conjunto M ( n , R ) (também denotado H N (R)) de todos os quadrados n -by- n matrizes mais de R é um anel chamado anel matriz , isomorfo para o anel endomorfismo da esquerda R - módulo R n . Se o anel R é conmutativo , isto é, a sua multiplicação é conmutativo, então M ( n , R ) é um não comutativa unitária (a menos que n = 1) associativo álgebra mais de R . O determinante de matrizes quadradas sobre um anel comutativo R ainda pode ser definido usando a fórmula de Leibniz ; tal matriz é invertível se e somente se seu determinante é invertível em R , generalizando a situação sobre um campo F , onde todo elemento diferente de zero é invertível. As matrizes sobre os superanéis são chamadas de supermatrizes .

As matrizes nem sempre têm todas as suas entradas no mesmo anel - ou mesmo em qualquer anel. Um caso especial, mas comum, são as matrizes de bloco , que podem ser consideradas como matrizes cujas próprias entradas são matrizes. As entradas não precisam ser matrizes quadradas e, portanto, não precisam ser membros de nenhum anel ; mas seus tamanhos devem cumprir certas condições de compatibilidade.

Relação com mapas lineares

Mapas lineares R n → R m são equivalentes a matrizes m -by- n , conforme descrito acima . Mais geralmente, qualquer mapa linear f : V → W entre espaços vetoriais de dimensão finita pode ser descrito por uma matriz A = ( a ij ), após escolher as bases v 1 , ..., v n de V e w 1 ,. .., w m de W (então n é a dimensão de V e m é a dimensão de W ), que é tal que

Em outras palavras, a coluna j de A expressa a imagem de v j em termos dos vetores de base w i de W ; assim esta relação determina unicamente as entradas da matriz Uma . A matriz depende da escolha das bases: diferentes escolhas de bases dão origem a matrizes diferentes, mas equivalentes . Muitas das noções de betão acima pode ser reinterpretado neste luz, por exemplo, a transposta da matriz A T descreve a transposição do mapa linear dada por A , no que diz respeito às duas bases .

Essas propriedades podem ser reafirmadas de forma mais natural: a categoria de todas as matrizes com entradas em um campo com multiplicação como composição é equivalente à categoria de espaços vetoriais de dimensão finita e mapas lineares sobre esse campo.

Mais geralmente, o conjunto de matrizes m × n pode ser usado para representar os mapas R- lineares entre os módulos livres R m e R n para um anel arbitrário R com unidade. Quando n = m, a composição desses mapas é possível, e isso dá origem ao anel de matriz de n × n matrizes que representam o anel de endomorfismo de R n .

Grupos matriciais

Um grupo é uma estrutura matemática que consiste em um conjunto de objetos em conjunto com uma operação binária , ou seja, uma operação que combina dois objetos quaisquer em um terceiro, sujeito a certos requisitos. Um grupo no qual os objetos são matrizes e a operação do grupo é a multiplicação de matrizes é chamado de grupo de matrizes . Como em um grupo, cada elemento deve ser invertível, os grupos de matrizes mais gerais são os grupos de todas as matrizes invertíveis de um determinado tamanho, chamados de grupos lineares gerais .

Qualquer propriedade de matrizes que é preservada em produtos de matriz e inversos pode ser usada para definir grupos de matrizes adicionais. Por exemplo, matrizes com um determinado tamanho e com um determinante de 1 formam um subgrupo de (isto é, um grupo menor contido em) seu grupo linear geral, chamado de grupo linear especial . Matrizes ortogonais , determinadas pela condição

- M T M = I ,

formar o grupo ortogonal . Toda matriz ortogonal tem determinante 1 ou −1. Matrizes ortogonais com determinante 1 formam um subgrupo denominado grupo ortogonal especial .

Todo grupo finito é isomorfo a um grupo matricial, como se pode ver considerando a representação regular do grupo simétrico . Os grupos gerais podem ser estudados usando grupos de matrizes, que são comparativamente bem compreendidos, por meio da teoria da representação .

Matrizes infinitas

Também é possível considerar matrizes com infinitas linhas e / ou colunas, mesmo que, sendo objetos infinitos, não se possa escrever tais matrizes explicitamente. Tudo o que importa é que para cada elemento nas linhas de indexação do conjunto e para cada elemento nas colunas de indexação do conjunto, haja uma entrada bem definida (esses conjuntos de índices não precisam nem mesmo ser subconjuntos dos números naturais). As operações básicas de adição, subtração, multiplicação escalar e transposição ainda podem ser definidas sem problemas; no entanto, a multiplicação da matriz pode envolver somas infinitas para definir as entradas resultantes, e estas não são definidas em geral.

Se R for qualquer anel com unidade, então o anel de endomorfismos de um módulo R direito é isomórfico ao anel de matrizes finitas de coluna cujas entradas são indexadas por , e cujas colunas cada uma contém apenas muitas entradas não nulas finitas. Os endomorfismos de M considerados como um módulo R esquerdo resultam em um objeto análogo, as matrizes de linhas finitas, cujas linhas cada uma tem apenas um número finito de entradas diferentes de zero.

Se matrizes infinitas são usadas para descrever mapas lineares, então apenas aquelas matrizes podem ser usadas em todas as colunas com um número finito de entradas diferentes de zero, pelo seguinte motivo. Para que uma matriz A descreva um mapa linear f : V → W , as bases para ambos os espaços devem ter sido escolhidas; lembre-se de que, por definição, isso significa que cada vetor no espaço pode ser escrito exclusivamente como uma combinação linear (finita) de vetores de base, de modo que, escrito como um vetor de (coluna) v de coeficientes , apenas entradas finitas v i são diferentes de zero. Agora, as colunas de A descrevem as imagens por f de vetores de base individuais de V na base de W , o que só é significativo se essas colunas tiverem apenas um número finito de entradas diferentes de zero. Não há nenhuma restrição nas linhas de A, no entanto: no produto A · v existem apenas finitamente muitos coeficientes diferentes de zero de v envolvidos, então cada uma de suas entradas, mesmo que seja dada como uma soma infinita de produtos, envolve apenas finitamente muitos termos diferentes de zero e, portanto, bem definida. Além disso, isso equivale a formar uma combinação linear das colunas de A que efetivamente envolve apenas finitamente muitas delas, de onde o resultado tem apenas entradas finitas diferentes de zero porque cada uma dessas colunas tem. Os produtos de duas matrizes do tipo dado são bem definidos (desde que os conjuntos de índice de coluna e índice de linha correspondam), são do mesmo tipo e correspondem à composição de mapas lineares.

Se R é um anel normalizado , a condição de finitude de linha ou coluna pode ser relaxada. Com a norma em vigor, séries absolutamente convergentes podem ser usadas em vez de somas finitas. Por exemplo, as matrizes cujas somas de coluna são sequências absolutamente convergentes formam um anel. Analogamente, as matrizes cujas somas de linhas são séries absolutamente convergentes também formam um anel.

Matrizes infinitas também podem ser usadas para descrever operadores em espaços de Hilbert , onde surgem questões de convergência e continuidade , que novamente resultam em certas restrições que devem ser impostas. No entanto, o ponto de vista explícito das matrizes tende a ofuscar o assunto, e as ferramentas abstratas e mais poderosas de análise funcional podem ser usadas em seu lugar.

Matriz vazia

Uma matriz vazia é uma matriz em que o número de linhas ou colunas (ou ambos) é zero. Matrizes vazias ajudam a lidar com mapas envolvendo o espaço vetorial zero . Por exemplo, se A é uma matriz 3 por 0 e B é uma matriz 0 por 3, então AB é a matriz zero 3 por 3 correspondente ao mapa nulo de um espaço tridimensional V para si mesmo, enquanto BA é uma matriz 0 por 0. Não existe uma notação comum para matrizes vazias, mas a maioria dos sistemas de álgebra de computador permite a criação e computação com elas. O determinante da matriz 0 por 0 é 1 da seguinte forma em relação ao produto vazio que ocorre na fórmula de Leibniz para o determinante como 1. Este valor também é consistente com o fato de que o mapa de identidade de qualquer espaço de dimensão finita para si mesmo tem determinante 1, fato frequentemente utilizado como parte da caracterização dos determinantes.

Formulários

Existem inúmeras aplicações de matrizes, tanto em matemática como em outras ciências. Alguns deles apenas aproveitam a representação compacta de um conjunto de números em uma matriz. Por exemplo, na teoria e na economia dos jogos , a matriz de payoff codifica o payoff para dois jogadores, dependendo de qual dentre um determinado conjunto (finito) de alternativas os jogadores escolhem. A mineração de texto e a compilação automatizada de dicionário de sinônimos usam matrizes de termos de documentos , como tf-idf, para rastrear frequências de certas palavras em vários documentos.

Os números complexos podem ser representados por matrizes 2 por 2 reais particulares por meio de

sob o qual a adição e multiplicação de números complexos e matrizes correspondem uns aos outros. Por exemplo, matrizes de rotação 2 por 2 representam a multiplicação com algum número complexo de valor absoluto 1, como acima . Uma interpretação semelhante é possível para quatérnios e álgebras de Clifford em geral.

As primeiras técnicas de criptografia , como a cifra de Hill, também usavam matrizes. No entanto, devido à natureza linear das matrizes, esses códigos são comparativamente fáceis de quebrar. A computação gráfica usa matrizes tanto para representar objetos quanto para calcular transformações de objetos usando matrizes de rotação afins para realizar tarefas como projetar um objeto tridimensional em uma tela bidimensional, correspondendo a uma observação de câmera teórica. Matrizes sobre um anel polinomial são importantes no estudo da teoria de controle .

A química faz uso de matrizes de várias maneiras, particularmente desde o uso da teoria quântica para discutir ligações moleculares e espectroscopia . Exemplos são a matriz de sobreposição e a matriz de Fock usadas na resolução das equações de Roothaan para obter os orbitais moleculares do método Hartree-Fock .

Teoria dos grafos

A matriz de adjacência de um grafo finito é uma noção básica da teoria dos grafos . Ele registra quais vértices do gráfico estão conectados por uma aresta. Matrizes contendo apenas dois valores diferentes (1 e 0 significando, por exemplo, "sim" e "não", respectivamente) são chamadas de matrizes lógicas . A matriz de distância (ou custo) contém informações sobre distâncias das arestas. Esses conceitos podem ser aplicados a sites conectados por hiperlinks ou cidades conectadas por estradas etc., nesse caso (a menos que a rede de conexão seja extremamente densa) as matrizes tendem a ser esparsas , ou seja, contêm poucas entradas diferentes de zero. Portanto, algoritmos de matriz especificamente adaptados podem ser usados na teoria de redes .

Análise e geometria

A matriz Hessiana de uma função diferenciável ƒ : R n → R consiste nas segundas derivadas de ƒ com respeito às várias direções de coordenadas, isto é,

Ele codifica informações sobre o comportamento de crescimento local da função: dado um ponto crítico x = ( x 1 , ..., x n ), ou seja, um ponto onde as primeiras derivadas parciais de ƒ desaparecem, a função tem um mínimo local se a matriz Hessiana é definida positiva . A programação quadrática pode ser usada para encontrar mínimos ou máximos globais de funções quadráticas intimamente relacionadas àquelas anexadas às matrizes (veja acima ).

Outra matriz frequentemente utilizada em situações geométricas é a matriz de Jacobi de um mapa diferenciável f : R n → R m . Se f 1 , ..., f m denotam os componentes de f , então a matriz de Jacobi é definida como

Se n > m , e se o posto da matriz de Jacobi atinge seu valor máximo m , f é localmente invertível nesse ponto, pelo teorema da função implícita .

As equações diferenciais parciais podem ser classificadas considerando a matriz de coeficientes dos operadores diferenciais de ordem mais alta da equação. Para equações diferenciais parciais elípticas esta matriz é definida positiva, o que tem uma influência decisiva no conjunto de soluções possíveis da equação em questão.

O método dos elementos finitos é um método numérico importante para resolver equações diferenciais parciais, amplamente aplicado na simulação de sistemas físicos complexos. Ele tenta aproximar a solução de alguma equação por funções lineares por partes, onde as peças são escolhidas em relação a uma grade suficientemente fina, que por sua vez pode ser reformulada como uma equação matricial.

Teoria de probabilidade e estatística

Matrizes estocásticas são matrizes quadradas cujas linhas são vetores de probabilidade , ou seja, cujas entradas não são negativas e somam um. Matrizes estocásticas são usadas para definir cadeias de Markov com um número finito de estados. Uma linha da matriz estocástica fornece a distribuição de probabilidade para a próxima posição de alguma partícula atualmente no estado que corresponde à linha. As propriedades dos estados de absorção semelhantes a cadeias de Markov , ou seja, os estados que qualquer partícula atinge eventualmente, podem ser lidas nos autovetores das matrizes de transição.

A estatística também faz uso de matrizes de muitas formas diferentes. A estatística descritiva preocupa-se com a descrição de conjuntos de dados, que muitas vezes podem ser representados como matrizes de dados , que podem então ser submetidos a técnicas de redução de dimensionalidade . A matriz de covariância codifica a variância mútua de várias variáveis aleatórias . Outra técnica que usa matrizes são os mínimos quadrados lineares , um método que aproxima um conjunto finito de pares ( x 1 , y 1 ), ( x 2 , y 2 ), ..., ( x N , y N ), por uma função linear

- y i ≈ ax i + b , i = 1, ..., N

que pode ser formulada em termos de matrizes, relacionadas com a decomposição em valor singular das matrizes.

Matrizes aleatórias são matrizes cujas entradas são números aleatórios, sujeitos a distribuições de probabilidade adequadas , como a distribuição normal da matriz . Além da teoria da probabilidade, eles são aplicados em domínios que vão da teoria dos números à física .

Simetrias e transformações na física

As transformações lineares e as simetrias associadas desempenham um papel fundamental na física moderna. Por exemplo, partículas elementares na teoria quântica de campos são classificadas como representações do grupo de Lorentz da relatividade especial e, mais especificamente, por seu comportamento sob o grupo de spin . Representações concretas envolvendo as matrizes de Pauli e matrizes gama mais gerais são parte integrante da descrição física dos férmions , que se comportam como espinores . Para os três quarks mais leves , há uma representação teórica de grupo envolvendo o grupo unitário especial SU (3); para seus cálculos, os físicos usam uma representação de matriz conveniente conhecida como matrizes de Gell-Mann , que também são usadas para o grupo de calibre SU (3) que forma a base da descrição moderna de interações nucleares fortes, cromodinâmica quântica . A matriz Cabibbo-Kobayashi-Maskawa , por sua vez, expressa o fato de que os estados de quark básicos que são importantes para interações fracas não são os mesmos, mas estão linearmente relacionados aos estados de quark básicos que definem partículas com massas específicas e distintas .

Combinações lineares de estados quânticos

O primeiro modelo da mecânica quântica ( Heisenberg , 1925) representou os operadores da teoria por matrizes de dimensão infinita atuando em estados quânticos. Isso também é conhecido como mecânica de matriz . Um exemplo particular é a matriz de densidade que caracteriza o estado "misto" de um sistema quântico como uma combinação linear de estados próprios elementares "puros" .

Outra matriz serve como uma ferramenta-chave para descrever os experimentos de espalhamento que formam a pedra angular da física de partículas experimental: reações de colisão, como ocorrem em aceleradores de partículas , onde partículas não interagentes dirigem-se umas às outras e colidem em uma pequena zona de interação, com um novo conjunto de partículas não interagentes como o resultado, pode ser descrito como o produto escalar dos estados de partícula de saída e uma combinação linear de estados de partícula de entrada. A combinação linear é dada por uma matriz conhecida como matriz S , que codifica todas as informações sobre as possíveis interações entre as partículas.

Modos normais

Uma aplicação geral de matrizes em física é a descrição de sistemas harmônicos acoplados linearmente. As equações de movimento de tais sistemas podem ser descritas em forma de matriz, com uma matriz de massa multiplicando uma velocidade generalizada para dar o termo cinético, e uma matriz de força multiplicando um vetor de deslocamento para caracterizar as interações. A melhor forma de obter soluções é determinar os autovetores do sistema , seus modos normais , diagonalizando a equação da matriz. Técnicas como essa são cruciais quando se trata da dinâmica interna das moléculas : as vibrações internas de sistemas que consistem em átomos componentes ligados mutuamente. Eles também são necessários para descrever vibrações mecânicas e oscilações em circuitos elétricos.

Óptica geométrica

A óptica geométrica fornece outras aplicações de matriz. Nesta teoria aproximativa, a natureza ondulatória da luz é negligenciada. O resultado é um modelo em que os raios de luz são, na verdade, raios geométricos . Se a deflexão dos raios de luz por elementos ópticos for pequena, a ação de uma lente ou elemento reflexivo em um determinado raio de luz pode ser expressa como a multiplicação de um vetor de dois componentes com uma matriz dois por dois chamada análise de matriz de transferência de raios : os componentes do vetor são a inclinação do raio de luz e sua distância do eixo óptico, enquanto a matriz codifica as propriedades do elemento óptico. Na verdade, existem dois tipos de matrizes, viz. uma matriz de refração que descreve a refração em uma superfície de lente e uma matriz de translação , que descreve a translação do plano de referência para a próxima superfície de refração, onde outra matriz de refração se aplica. O sistema óptico, constituído por uma combinação de lentes e / ou elementos reflexivos, é simplesmente descrito pela matriz resultante do produto das matrizes dos componentes.

Eletrônicos

A análise de malha tradicional e a análise nodal em eletrônica levam a um sistema de equações lineares que podem ser descritas com uma matriz.

O comportamento de muitos componentes eletrônicos pode ser descrito por meio de matrizes. Seja A um vetor bidimensional com a tensão de entrada v 1 do componente e a corrente de entrada i 1 como seus elementos, e seja B um vetor bidimensional com a tensão de saída v 2 do componente e a corrente de saída i 2 como seus elementos. Então, o comportamento do componente eletrônico pode ser descrito por B = H · A , onde H é uma matriz 2 x 2 contendo um elemento de impedância ( h 12 ), um elemento de admitância ( h 21 ) e dois elementos adimensionais ( h 11 e h 22 ). Calcular um circuito agora se reduz a multiplicação de matrizes.

História

As matrizes têm uma longa história de aplicação na resolução de equações lineares, mas eram conhecidas como matrizes até o século XIX. O texto chinês Os nove capítulos sobre a arte matemática, escrito no século 10 e 2 aC, é o primeiro exemplo do uso de métodos de array para resolver equações simultâneas , incluindo o conceito de determinantes . Em 1545, o matemático italiano Gerolamo Cardano introduziu o método na Europa quando publicou Ars Magna . O matemático japonês Seki usou os mesmos métodos de array para resolver equações simultâneas em 1683. O matemático holandês Jan de Witt representou transformações usando arrays em seu livro de 1659, Elements of Curves (1659). Entre 1700 e 1710 Gottfried Wilhelm Leibniz divulgou o uso de matrizes para registrar informações ou soluções e fez experiências com mais de 50 sistemas diferentes de matrizes. Cramer apresentou sua regra em 1750.

O termo "matriz" (latim para "útero", derivado de mater - mãe) foi cunhado por James Joseph Sylvester em 1850, que entendeu uma matriz como um objeto que dá origem a vários determinantes hoje chamados menores , ou seja, determinantes de matrizes menores que derivam da original removendo colunas e linhas. Em um artigo de 1851, Sylvester explica:

- Em artigos anteriores, defini uma "matriz" como um conjunto retangular de termos, a partir do qual diferentes sistemas de determinantes podem ser engendrados a partir do útero de um pai comum.

Arthur Cayley publicou um tratado sobre transformações geométricas usando matrizes que não eram versões rotacionadas dos coeficientes sendo investigados como havia sido feito anteriormente. Em vez disso, ele definiu operações como adição, subtração, multiplicação e divisão como transformações dessas matrizes e mostrou as propriedades associativas e distributivas consideradas verdadeiras. Cayley investigou e demonstrou a propriedade não comutativa da multiplicação da matriz, bem como a propriedade comutativa da adição da matriz. A teoria da matriz inicial havia limitado o uso de matrizes quase exclusivamente aos determinantes e as operações de matriz abstrata de Arthur Cayley eram revolucionárias. Ele foi fundamental ao propor um conceito de matriz independente de sistemas de equações. Em 1858, Cayley publicou seu livro de memórias sobre a teoria das matrizes, no qual ele propôs e demonstrou o teorema de Cayley-Hamilton .

O matemático inglês Cuthbert Edmund Cullis foi o primeiro a usar a notação de colchetes moderna para matrizes em 1913 e simultaneamente demonstrou o primeiro uso significativo da notação A = [ a i , j ] para representar uma matriz onde a i , j se refere ao i a linha e a coluna j .

O estudo moderno dos determinantes surgiu de várias fontes. Número-teórico problemas levaram Gauss para relacionar coeficientes de formas quadráticas , isto é, expressões, tais como x 2 + xy - 2 Y 2 , e mapas lineares em três dimensões para matrizes. Eisenstein desenvolveu ainda mais essas noções, incluindo a observação de que, na linguagem moderna, os produtos de matriz são não comutativos . Cauchy foi o primeiro a provar afirmações gerais sobre determinantes, usando como definição do determinante de uma matriz A = [ a i , j ] o seguinte: substitua as potências a j k por a jk no polinômio

- ,

onde Π denota o produto dos termos indicados. Ele também mostrou, em 1829, que os autovalores de matrizes simétricas são reais. Jacobi estudou "determinantes funcionais" - mais tarde chamados de determinantes Jacobi por Sylvester - que podem ser usados para descrever transformações geométricas em um nível local (ou infinitesimal ), veja acima ; Kronecker 's Vorlesungen über die Theorie der Determinanten e Weierstrass Zur Determinantentheorie , ambas publicadas em 1903, determinantes primeiro tratados axiomatically , em oposição ao anterior mais concreto abordagens, tais como a acima mencionada fórmula de Cauchy. Nesse ponto, os determinantes estavam firmemente estabelecidos.

Muitos teoremas foram estabelecidos pela primeira vez apenas para matrizes pequenas, por exemplo, o teorema de Cayley-Hamilton foi provado para matrizes 2 × 2 por Cayley nas memórias mencionadas anteriormente e por Hamilton para matrizes 4 × 4. Frobenius , trabalhando em formas bilineares , generalizou o teorema para todas as dimensões (1898). Também no final do século 19, a eliminação de Gauss-Jordan (generalizando um caso especial agora conhecido como eliminação de Gauss ) foi estabelecida por Jordan . No início do século 20, as matrizes alcançaram um papel central na álgebra linear, em parte devido ao seu uso na classificação dos sistemas numéricos hipercomplexos do século anterior.

O início da mecânica da matriz por Heisenberg , Born e Jordan levou ao estudo de matrizes com infinitas linhas e colunas. Posteriormente, von Neumann realizou a formulação matemática da mecânica quântica , desenvolvendo ainda mais noções analíticas funcionais , como os operadores lineares nos espaços de Hilbert , que, grosso modo, correspondem ao espaço euclidiano , mas com uma infinidade de direções independentes .

Outros usos históricos da palavra "matriz" em matemática

A palavra foi usada de maneiras incomuns por pelo menos dois autores de importância histórica.

Bertrand Russell e Alfred North Whitehead em seu Principia Mathematica (1910–1913) usam a palavra "matriz" no contexto de seu axioma de redutibilidade . Eles propuseram este axioma como um meio de reduzir qualquer função a uma de tipo inferior, sucessivamente, de modo que no "fundo" (ordem 0) a função seja idêntica à sua extensão :

- "Vamos dar o nome de matriz a qualquer função, de quantas variáveis, que não envolva nenhuma variável aparente . Então, qualquer função possível que não seja uma matriz deriva de uma matriz por meio de generalização, isto é, considerando a proposição que a função em questão é verdadeira com todos os valores possíveis ou com algum valor de um dos argumentos, o outro argumento ou argumentos permanecem indeterminados ".

Por exemplo, uma função Φ ( x, y ) de duas variáveis x e y pode ser reduzida a uma coleção de funções de uma única variável, por exemplo, y , "considerando" a função para todos os valores possíveis de "indivíduos" a i substituído no lugar da variável x . E então a coleção resultante de funções da única variável y , ou seja, ∀a i : Φ ( a i , y ), pode ser reduzida a uma "matriz" de valores "considerando" a função para todos os valores possíveis de " indivíduos " b i substituídos no lugar da variável y :

- ∀b j ∀a i : Φ ( a i , b j ).

Alfred Tarski, em sua Introdução à Lógica de 1946, usou a palavra "matriz" como sinônimo da noção de tabela verdade conforme usada na lógica matemática.

Veja também

- Lista de matrizes nomeadas

- Multiplicidade algébrica - Multiplicidade de um autovalor como uma raiz do polinômio característico

- Multiplicidade geométrica - dimensão do espaço próprio associado a um valor próprio

- Processo de Gram-Schmidt - Método para ortonormalizar um conjunto de vetores

- Matriz irregular

- Cálculo matricial - notação especializada para cálculo multivariável

- Função Matrix

- Algoritmo de multiplicação de matriz

- Tensor - Uma generalização de matrizes com qualquer número de índices

Notas

Referências

- Anton, Howard (1987), Elementary Linear Algebra (5ª ed.), Nova York: Wiley , ISBN 0-471-84819-0

- Arnold, Vladimir I .; Cooke, Roger (1992), Equações diferenciais ordinárias , Berlin, DE; Nova York, NY: Springer-Verlag , ISBN 978-3-540-54813-3

- Artin, Michael (1991), Algebra , Prentice Hall , ISBN 978-0-89871-510-1

- Association for Computing Machinery (1979), Computer Graphics , Tata McGraw – Hill, ISBN 978-0-07-059376-3

- Baker, Andrew J. (2003), Matrix Groups: An Introduction to Lie Group Theory , Berlim, DE; Nova York, NY: Springer-Verlag, ISBN 978-1-85233-470-3

- Bau III, David; Trefethen, Lloyd N. (1997), Numerical linear algebra , Philadelphia, PA: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-361-9

- Beauregard, Raymond A .; Fraleigh, John B. (1973), A First Course In Linear Algebra: with Optional Introduction to Groups, Rings, and Fields , Boston: Houghton Mifflin Co. , ISBN 0-395-14017-X

- Bretscher, Otto (2005), Linear Algebra with Applications (3ª ed.), Prentice Hall

- Bronson, Richard (1970), Matrix Methods: An Introduction , Nova York: Academic Press , LCCN 70097490

- Bronson, Richard (1989), esboço de teoria e problemas de operações de matriz de Schaum , Nova York: McGraw – Hill , ISBN 978-0-07-007978-6

- Brown, William C. (1991), Matrices and vector spaces , New York, NY: Marcel Dekker , ISBN 978-0-8247-8419-5

- Coburn, Nathaniel (1955), Vector and tensor analysis , New York, NY: Macmillan, OCLC 1029828

- Conrey, J. Brian (2007), Ranks of eliptic curves and random matrix theory , Cambridge University Press , ISBN 978-0-521-69964-8

- Fraleigh, John B. (1976), A First Course In Abstract Algebra (2ª ed.), Reading: Addison-Wesley , ISBN 0-201-01984-1

- Fudenberg, Drew; Tirole, Jean (1983), Game Theory , MIT Press

- Gilbarg, David; Trudinger, Neil S. (2001), Equações diferenciais parciais elípticas de segunda ordem (2ª ed.), Berlim, DE; Nova York, NY: Springer-Verlag, ISBN 978-3-540-41160-4

- Godsil, Chris ; Royle, Gordon (2004), Algebraic Graph Theory , Graduate Texts in Mathematics, 207 , Berlin, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-95220-8

- Golub, Gene H .; Van Loan, Charles F. (1996), Matrix Computations (3ª ed.), Johns Hopkins, ISBN 978-0-8018-5414-9

- Greub, Werner Hildbert (1975), Linear algebra , Graduate Texts in Mathematics, Berlin, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-90110-7

- Halmos, Paul Richard (1982), A Hilbert space problem book , Graduate Texts in Mathematics, 19 (2ª ed.), Berlin, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-90685-0, MR 0675952

- Horn, Roger A .; Johnson, Charles R. (1985), Matrix Analysis , Cambridge University Press, ISBN 978-0-521-38632-6

- Householder, Alston S. (1975), The theory of matrices in numerical analysis , Nova York, NY: Dover Publications , MR 0378371

- Kreyszig, Erwin (1972), Advanced Engineering Mathematics (3ª ed.), Nova York: Wiley , ISBN 0-471-50728-8.

- Krzanowski, Wojtek J. (1988), Principles of multivariate analysis , Oxford Statistical Science Series, 3 , The Clarendon Press Oxford University Press, ISBN 978-0-19-852211-9, MR 0969370

- Itô, Kiyosi, ed. (1987), Dicionário enciclopédico de matemática. Vol. I-IV (2ª ed.), MIT Press, ISBN 978-0-262-09026-1, MR 0901762

- Lang, Serge (1969), Analysis II , Addison-Wesley

- Lang, Serge (1987a), Calculus of various variables (3rd ed.), Berlin, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-96405-8

- Lang, Serge (1987b), Linear algebra , Berlin, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-96412-6

- Lang, Serge (2002), Algebra , Graduate Texts in Mathematics , 211 (revisado, terceira edição), Nova York: Springer-Verlag, ISBN 978-0-387-95385-4, MR 1878556

- Latouche, Guy; Ramaswami, Vaidyanathan (1999), Introdução aos métodos analíticos de matriz em modelagem estocástica (1ª ed.), Filadélfia, PA: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-425-8

- Manning, Christopher D .; Schütze, Hinrich (1999), Foundations of statistics natural language processing , MIT Press, ISBN 978-0-262-13360-9

- Mehata, KM; Srinivasan, SK (1978), processos estocásticos , Nova York, NY: McGraw – Hill, ISBN 978-0-07-096612-3

- Mirsky, Leonid (1990), An Introduction to Linear Algebra , Courier Dover Publications, ISBN 978-0-486-66434-7

- Nering, Evar D. (1970), Linear Algebra and Matrix Theory (2ª ed.), New York: Wiley , LCCN 76-91646

- Nocedal, Jorge; Wright, Stephen J. (2006), Numerical Optimization (2ª ed.), Berlin, DE; New York, NY: Springer-Verlag, p. 449, ISBN 978-0-387-30303-1

- Oualline, Steve (2003), Practical C ++ programming , O'Reilly , ISBN 978-0-596-00419-4

- Press, William H .; Flannery, Brian P .; Teukolsky, Saul A .; Vetterling, William T. (1992), "LU Decomposition and Its Applications" (PDF) , Numerical Recipes in FORTRAN: The Art of Scientific Computing (2ª ed.), Cambridge University Press, pp. 34-42, arquivado do original em 06/09/2009CS1 maint: URL impróprio ( link )

- Protter, Murray H .; Morrey, Jr., Charles B. (1970), College Calculus with Analytic Geometry (2ª ed.), Reading: Addison-Wesley , LCCN 76087042

- Punnen, Abraham P .; Gutin, Gregory (2002), O problema do caixeiro-viajante e suas variações , Boston, MA: Kluwer Academic Publishers, ISBN 978-1-4020-0664-7

- Reichl, Linda E. (2004), A transição para o caos: sistemas clássicos conservadores e manifestações quânticas , Berlin, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-98788-0

- Rowen, Louis Halle (2008), Graduate Algebra: noncomutative view , Providence, RI: American Mathematical Society , ISBN 978-0-8218-4153-2

- Šolin, Pavel (2005), Equações diferenciais parciais e o método dos elementos finitos , Wiley-Interscience , ISBN 978-0-471-76409-0

- Stinson, Douglas R. (2005), Cryptography , Discrete Mathematics and its Applications, Chapman & Hall / CRC, ISBN 978-1-58488-508-5

- Stoer, Josef; Bulirsch, Roland (2002), Introdução à Análise Numérica (3ª ed.), Berlim, DE; Nova York, NY: Springer-Verlag, ISBN 978-0-387-95452-3

- Ward, JP (1997), Quaternions and Cayley numbers , Mathematics and its Applications, 403 , Dordrecht, NL: Kluwer Academic Publishers Group, doi : 10.1007 / 978-94-011-5768-1 , ISBN 978-0-7923-4513-8, MR 1458894

- Wolfram, Stephen (2003), The Mathematica Book (5ª ed.), Champaign, IL: Wolfram Media, ISBN 978-1-57955-022-6

Referências de física

- Bohm, Arno (2001), Quantum Mechanics: Foundations and Applications , Springer, ISBN 0-387-95330-2

- Burgess, Cliff; Moore, Guy (2007), The Standard Model. A Primer , Cambridge University Press, ISBN 978-0-521-86036-9

- Guenther, Robert D. (1990), Modern Optics , John Wiley, ISBN 0-471-60538-7

- Itzykson, Claude; Zuber, Jean-Bernard (1980), Quantum Field Theory , McGraw – Hill, ISBN 0-07-032071-3

- Riley, Kenneth F .; Hobson, Michael P .; Bence, Stephen J. (1997), Métodos matemáticos para física e engenharia , Cambridge University Press, ISBN 0-521-55506-X

- Schiff, Leonard I. (1968), Quantum Mechanics (3ª ed.), McGraw-Hill

- Weinberg, Steven (1995), The Quantum Theory of Fields. Volume I: Foundations , Cambridge University Press, ISBN 0-521-55001-7

- Wherrett, Brian S. (1987), Group Theory for Atoms, Molecules and Solids , Prentice – Hall International, ISBN 0-13-365461-3

- Zabrodin, Anton; Brezin, Édouard; Kazakov, Vladimir; Serban, Didina; Wiegmann, Paul (2006), Applications of Random Matrices in Physics (NATO Science Series II: Mathematics, Physics and Chemistry) , Berlim, DE; Nova York, NY: Springer-Verlag , ISBN 978-1-4020-4530-1

Referências históricas

- A. Cayley Um livro de memórias sobre a teoria das matrizes . Phil. Trans. 148 1858 17-37; Matemática. Artigos II 475-496

- Bôcher, Maxime (2004), Introdução à álgebra superior , New York, NY: Dover Publications , ISBN 978-0-486-49570-5, reimpressão da edição original de 1907

- Cayley, Arthur (1889), Os artigos matemáticos coletados de Arthur Cayley , I (1841-1853), Cambridge University Press , pp. 123-126

- Dieudonné, Jean , ed. (1978), Abrégé d'histoire des mathématiques 1700-1900 , Paris, FR: Hermann

- Hawkins, Thomas (1975), "Cauchy e a teoria espectral de matrizes", Historia Mathematica , 2 : 1-29, doi : 10.1016 / 0315-0860 (75) 90032-4 , ISSN 0315-0860 , MR 0469635

- Knobloch, Eberhard (1994), "De Gauss a Weierstrass: teoria determinante e suas avaliações históricas", A intersecção da história e da matemática , Science Networks Historical Studies, 15 , Basel, Boston, Berlin: Birkhäuser, pp. 51-66, MR 1308079

- Kronecker, Leopold (1897), Hensel, Kurt (ed.), Leopold Kronecker Werke , Teubner

- Mehra, Jagdish; Rechenberg, Helmut (1987), The Historical Development of Quantum Theory (1ª ed.), Berlin, DE; Nova York, NY: Springer-Verlag , ISBN 978-0-387-96284-9

- Shen, Kangshen; Crossley, John N .; Lun, Anthony Wah-Cheung (1999), Nine Chapters of the Mathematical Art, Companion and Commentary (2ª ed.), Oxford University Press , ISBN 978-0-19-853936-0

- Weierstrass, Karl (1915), Obras coletadas , 3

Leitura adicional

- "Matrix" , Encyclopedia of Mathematics , EMS Press , 2001 [1994]

- Kaw, Autar K. (setembro de 2008), Introduction to Matrix Algebra , ISBN 978-0-615-25126-4

- The Matrix Cookbook (PDF) , recuperado em 24 de março de 2014

- Brookes, Mike (2005), The Matrix Reference Manual , London: Imperial College , recuperado em 10 de dezembro de 2008

links externos

- MacTutor: Matrizes e determinantes

- Matrizes e álgebra linear nas primeiras páginas de usos

- Usos mais antigos de símbolos para matrizes e vetores

![{\ displaystyle [\ mathbf {AB}] _ {i, j} = a_ {i, 1} b_ {1, j} + a_ {i, 2} b_ {2, j} + \ cdots + a_ {i, n} b_ {n, j} = \ sum _ {r = 1} ^ {n} a_ {i, r} b_ {r, j},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c903c2c14d249005ce9ebaa47a8d6c6710c1c29e)

![H (f) = \ left [{\ frac {\ partial ^ {2} f} {\ partial x_ {i} \, \ partial x_ {j}}} \ right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/9cf91a060a82dd7a47c305e9a4c2865378fcf35f)

![J (f) = \ left [{\ frac {\ partial f_ {i}} {\ partial x_ {j}}} \ right] _ {1 \ leq i \ leq m, 1 \ leq j \ leq n}.](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdbd42114b895c82930ea1e229b566f71fd6b07d)