Método de grupo de tratamento de dados - Group method of data handling

O método de grupo de manipulação de dados (GMDH) é uma família de algoritmos indutivos para modelagem matemática baseada em computador de conjuntos de dados multiparamétricos que apresenta otimização paramétrica e estrutural totalmente automática de modelos.

O GMDH é usado em campos como mineração de dados , descoberta de conhecimento , previsão , modelagem de sistemas complexos , otimização e reconhecimento de padrões . Algoritmos GMDH são caracterizados por procedimento indutivo que realiza a classificação de modelos polinomiais gradualmente complicados e seleciona a melhor solução por meio do critério externo .

Um modelo GMDH com várias entradas e uma saída é um subconjunto de componentes da função de base (1):

onde f i são funções elementares dependentes de diferentes conjuntos de entradas, a i são coeficientes e m é o número dos componentes da função de base.

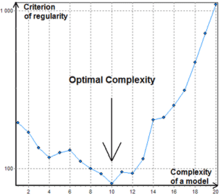

Para encontrar a melhor solução, os algoritmos GMDH consideram vários subconjuntos de componentes da função base (1) chamados modelos parciais . Os coeficientes desses modelos são estimados pelo método dos mínimos quadrados . Os algoritmos GMDH aumentam gradualmente o número de componentes parciais do modelo e encontram uma estrutura de modelo com complexidade ótima indicada pelo valor mínimo de um critério externo . Este processo é denominado auto-organização de modelos.

Como a primeira função de base usada no GMDH, foi o polinômio de Kolmogorov – Gabor gradualmente complicado (2):

Normalmente são usados modelos parciais mais simples com funções de até segundo grau.

Os algoritmos indutivos também são conhecidos como redes neurais polinomiais . Jürgen Schmidhuber cita o GMDH como um dos primeiros métodos de aprendizado profundo , observando que ele foi usado para treinar redes neurais de oito camadas já em 1971.

História

O método foi originado em 1968 pelo Prof. Alexey G. Ivakhnenko no Instituto de Cibernética de Kiev . Esta abordagem indutiva foi desde o início um método baseado em computador, portanto, um conjunto de programas de computador e algoritmos foram os principais resultados práticos alcançados com base nos novos princípios teóricos. Graças à política do autor de compartilhamento de código aberto, o método foi rapidamente estabelecido em um grande número de laboratórios científicos em todo o mundo. Como a maior parte do trabalho de rotina é transferida para um computador, o impacto da influência humana no resultado objetivo é minimizado. Na verdade, essa abordagem pode ser considerada como uma das implementações da tese de Inteligência Artificial , que afirma que um computador pode atuar como um poderoso conselheiro para humanos.

O desenvolvimento do GMDH consiste em uma síntese de ideias de diferentes áreas da ciência: o conceito cibernético de " caixa preta " e o princípio da seleção genética sucessiva de características pareadas , os teoremas da incompletude de Gõdel e o princípio de Gabor de "liberdade de escolha de decisões", a incorreção de Adhémar e o princípio de adições externas de Beer .

GMDH é o método original para resolver problemas de identificação estrutural-paramétrica de modelos para dados experimentais sob incerteza . Tal problema ocorre na construção de um modelo matemático que se aproxima do padrão desconhecido do objeto ou processo investigado. Ele usa informações sobre ele que estão implicitamente contidas nos dados. O GMDH difere de outros métodos de modelagem pela aplicação ativa dos seguintes princípios : geração automática de modelos, decisões inconclusivas e seleção consistente por critérios externos para encontrar modelos de complexidade ótima. Ele tinha um procedimento original de múltiplas camadas para geração automática de estruturas de modelos, que imita o processo de seleção biológica levando em consideração características sucessivas de pares. Tal procedimento é utilizado atualmente em redes de aprendizado profundo . Para comparar e escolher modelos ideais, dois ou mais subconjuntos de uma amostra de dados são usados. Isso torna possível evitar suposições preliminares, porque a divisão da amostra reconhece implicitamente diferentes tipos de incerteza durante a construção automática do modelo ótimo.

Durante o desenvolvimento foi estabelecida uma analogia orgânica entre o problema de construção de modelos para dados ruidosos e o sinal que passa pelo canal com ruído . Isso possibilitou lançar as bases da teoria da modelagem imune a ruído. O principal resultado dessa teoria é que a complexidade do modelo preditivo ótimo depende do nível de incerteza dos dados: quanto maior esse nível (por exemplo, devido ao ruído) - mais simples deve ser o modelo ótimo (com menos parâmetros estimados). Isso iniciou o desenvolvimento da teoria GMDH como um método indutivo de adaptação automática da complexidade ótima do modelo ao nível de variação de ruído em dados fuzzy . Portanto, o GMDH é frequentemente considerado a tecnologia da informação original para extração de conhecimento de dados experimentais .

O período de 1968 a 1971 é caracterizado pela aplicação apenas do critério de regularidade para a solução dos problemas de identificação, reconhecimento de padrões e previsão de curto prazo. Como funções de referência, polinômios, redes lógicas, conjuntos difusos de Zadeh e fórmulas de probabilidade de Bayes foram utilizadas. Os autores foram estimulados por uma precisão muito alta de previsão com a nova abordagem. A imunidade ao ruído não foi investigada.

Período 1972–1975 . O problema de modelagem de dados com ruído e base de informações incompletas foi resolvido. A seleção multicritério e a utilização de informações adicionais a priori para o aumento da imunidade ao ruído foram propostas. Os melhores experimentos mostraram que, com a definição estendida do modelo ótimo por critério adicional, o nível de ruído pode ser dez vezes maior do que o sinal. Em seguida, foi melhorado usando a teoria do Teorema da Comunicação Geral de Shannon .

Período 1976–1979 . A convergência de algoritmos GMDH multicamadas foi investigada. Foi mostrado que alguns algoritmos multicamadas têm "erro multicamadas" - análogo ao erro estático dos sistemas de controle. Em 1977, uma solução de problemas de análise de sistemas objetivos por algoritmos GMDH multicamadas foi proposta. Descobriu-se que a classificação por conjunto de critérios encontra o único sistema ótimo de equações e, portanto, mostra elementos de objetos complexos, suas principais variáveis de entrada e saída.

Período 1980–1988 . Muitos resultados teóricos importantes foram recebidos. Ficou claro que modelos físicos completos não podem ser usados para previsões de longo prazo. Foi provado que modelos não físicos de GMDH são mais precisos para aproximação e previsão do que modelos físicos de análise de regressão. Algoritmos de dois níveis que usam duas escalas de tempo diferentes para modelagem foram desenvolvidos.

Desde 1989 os novos algoritmos (AC, OCC, PF) para modelagem não paramétrica de objetos fuzzy e SLP para sistemas especialistas foram desenvolvidos e investigados. O estágio atual de desenvolvimento do GMDH pode ser descrito como o florescimento de neuronets de aprendizado profundo e algoritmos indutivos paralelos para computadores com multiprocessadores.

Critérios externos

O critério externo é uma das principais características do GMDH. O critério descreve os requisitos para o modelo, por exemplo, a minimização dos mínimos quadrados . É sempre calculado com uma parte separada da amostra de dados que não foi usada para a estimativa dos coeficientes. Isso torna possível selecionar um modelo de complexidade ótima de acordo com o nível de incerteza nos dados de entrada. Existem vários critérios populares:

- Critério de Regularidade (CR) - Mínimos quadrados de um modelo na amostra B.

- Critério de enviesamento mínimo ou consistência - um erro quadrático da diferença entre as saídas estimadas (ou vetores de coeficientes) de dois modelos desenvolvidos com base em duas amostras distintas A e B, dividido pela saída quadrada estimada na amostra B. Comparação de modelos que a utilizam , permite obter modelos consistentes e recuperar uma lei física oculta dos dados ruidosos.

- Critérios de validação cruzada .

Uma descrição simples do desenvolvimento do modelo usando GMDH

Para modelagem usando GMDH, apenas o critério de seleção e a complexidade máxima do modelo são pré-selecionados. Em seguida, o processo de design começa na primeira camada e continua. O número de camadas e neurônios em camadas ocultas e a estrutura do modelo são determinados automaticamente. Todas as combinações possíveis de entradas permitidas (todos os neurônios possíveis) podem ser consideradas. Em seguida, os coeficientes polinomiais são determinados usando um dos métodos de minimização disponíveis, como decomposição de valor singular (com dados de treinamento). Em seguida, os neurônios que têm melhor valor de critério externo (para dados de teste) são mantidos e outros são removidos. Se o critério externo para o melhor neurônio da camada atingir o mínimo ou ultrapassar o critério de parada, o projeto da rede é concluído e a expressão polinomial do melhor neurônio da última camada é introduzida como a função de previsão matemática; caso contrário, a próxima camada será gerada e esse processo continua.

Redes neurais do tipo GMDH

Existem muitas maneiras diferentes de escolher um pedido para consideração de modelos parciais. A primeira ordem de consideração usada no GMDH e originalmente chamada de procedimento indutivo multicamadas é a mais popular. É uma classificação de modelos gradualmente complicados gerados a partir da função de base . O melhor modelo é indicado pelo mínimo da característica do critério externo. O procedimento multicamadas é equivalente à Rede Neural Artificial com função de ativação polinomial dos neurônios. Portanto, o algoritmo com essa abordagem geralmente é referido como Rede Neural do tipo GMDH ou Rede Neural Polinomial. Li mostrou que a rede neural do tipo GMDH teve um desempenho melhor do que os algoritmos de previsão clássicos, como Single Exponential Smooth, Double Exponential Smooth, ARIMA e back-propagation network neural.

GMDH Combinatório

Outra abordagem importante para a consideração de modelos parciais que se torna cada vez mais popular é uma pesquisa combinatória que é limitada ou completa. Esta abordagem tem algumas vantagens em relação às Redes Neurais Polinomiais, mas requer considerável poder computacional e, portanto, não é eficaz para objetos com um grande número de entradas. Uma conquista importante do GMDH Combinatório é que ele supera totalmente a abordagem de regressão linear se o nível de ruído nos dados de entrada for maior que zero. Isso garante que o modelo ideal será encontrado durante a classificação exaustiva.

O algoritmo combinatório básico executa as seguintes etapas:

- Divide a amostra de dados pelo menos em duas amostras A e B.

- Gera subamostras de A de acordo com modelos parciais com complexidade cada vez maior.

- Estima os coeficientes de modelos parciais em cada camada de complexidade dos modelos.

- Calcula o valor do critério externo para modelos na amostra B.

- Escolhe o melhor modelo (conjunto de modelos) indicado pelo valor mínimo do critério.

- Para o modelo selecionado de complexidade ótima, recalcule os coeficientes em uma amostra de dados inteira.

Em contraste com as redes neurais do tipo GMDH, o algoritmo combinatório geralmente não para em um determinado nível de complexidade porque um ponto de aumento do valor de critério pode ser simplesmente um mínimo local, consulte a Fig.1.

Algoritmos

- Combinatória (COMBI)

- Iterativo multicamadas (MIA)

- GN

- Análise Objetiva do Sistema (OSA)

- Harmônico

- Dois níveis (ARIMAD)

- Multiplicativo-Aditivo (MAA)

- Clusterização objetiva de computadores (OCC);

- Algoritmo de clusterização Pointing Finger (PF);

- Complexação de análogos (AC)

- Rediscretização Harmônica

- Algoritmo com base na Teoria de Decisões Estatísticas Multicamadas (MTSD)

- Evolução do Grupo de Modelos Adaptativos (GAME)

Lista de software

- MATLAB

- Projeto FAKE GAME - Código aberto. Plataforma cruzada.

- GEvom - Gratuito mediante solicitação para uso acadêmico. Apenas para Windows.

- GMDH Shell - software de análise preditiva baseado em GMDH e previsão de séries temporais. Licenciamento acadêmico gratuito e versão de avaliação gratuita disponíveis. Apenas para Windows.

- KnowledgeMiner - Produto comercial. Apenas Mac OS X. Versão de demonstração gratuita disponível.

- Cliente PNN Discovery - Produto comercial.

- Sciengy RPF! - Freeware, código aberto.

- wGMDH - Plug - in Weka , código aberto.

- Pacote R - código aberto.

- Pacote R para tarefas de regressão - código aberto.

- Biblioteca Python do algoritmo MIA - Código aberto.

Referências

links externos

Leitura adicional

- AG Ivakhnenko. Heuristic Self-Organization in Problems of Engineering Cybernetics , Automatica, vol.6, 1970 - p. 207-219.

- SJ Farlow . Métodos de auto-organização em modelagem: Algoritmos de tipo GMDH . New-York, Bazel: Marcel Decker Inc., 1984, 350 p.

- HR Madala, AG Ivakhnenko. Algoritmos de Aprendizagem Indutiva para Modelagem de Sistemas Complexos . CRC Press, Boca Raton, 1994.