Armazém de dados - Data warehouse

Na computação , um data warehouse ( DW ou DWH ), também conhecido como data warehouse empresarial ( EDW ), é um sistema usado para geração de relatórios e análise de dados e é considerado um componente central da inteligência de negócios . Os DWs são repositórios centrais de dados integrados de uma ou mais fontes distintas. Eles armazenam dados atuais e históricos em um único local que são usados para criar relatórios analíticos para funcionários em toda a empresa.

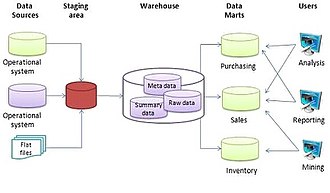

Os dados armazenados no warehouse são carregados dos sistemas operacionais (como marketing ou vendas). Os dados podem passar por um armazenamento de dados operacional e podem exigir limpeza de dados para operações adicionais para garantir a qualidade dos dados antes de serem usados no DW para relatórios.

Extrair, transformar, carregar (ETL) e extrair, carregar, transformar (ELT) são as duas abordagens principais usadas para construir um sistema de data warehouse.

Armazenamento de dados baseado em ETL

O data warehouse típico baseado em extração, transformação, carregamento (ETL) usa teste , integração de dados e camadas de acesso para hospedar suas funções principais. A camada de teste ou banco de dados de teste armazena dados brutos extraídos de cada um dos diferentes sistemas de dados de origem. A camada de integração integra os conjuntos de dados díspares, transformando os dados da camada de teste, geralmente armazenando esses dados transformados em um banco de dados de armazenamento de dados operacional (ODS). Os dados integrados são então movidos para outro banco de dados, geralmente chamado de banco de dados do data warehouse, onde os dados são organizados em grupos hierárquicos, geralmente chamados de dimensões, e em fatos e fatos agregados. A combinação de fatos e dimensões às vezes é chamada de esquema em estrela . A camada de acesso ajuda os usuários a recuperar dados.

A principal fonte de dados é limpa , transformada, catalogada e disponibilizada para uso por gerentes e outros profissionais de negócios para mineração de dados , processamento analítico online , pesquisa de mercado e suporte à decisão . No entanto, os meios para recuperar e analisar dados, para extrair, transformar e carregar dados e para gerenciar o dicionário de dados também são considerados componentes essenciais de um sistema de armazenamento de dados. Muitas referências ao armazenamento de dados usam esse contexto mais amplo. Portanto, uma definição expandida para data warehouse inclui ferramentas de business intelligence , ferramentas para extrair, transformar e carregar dados no repositório e ferramentas para gerenciar e recuperar metadados .

Armazenamento de dados baseado em ELT

O data warehouse baseado em ELT elimina uma ferramenta ETL separada para transformação de dados. Em vez disso, ele mantém uma área de teste dentro do próprio data warehouse. Nessa abordagem, os dados são extraídos de sistemas de origem heterogêneos e, em seguida, carregados diretamente no data warehouse, antes que ocorra qualquer transformação. Todas as transformações necessárias são então tratadas dentro do próprio data warehouse. Finalmente, os dados manipulados são carregados nas tabelas de destino no mesmo data warehouse.

Benefícios

Um data warehouse mantém uma cópia das informações dos sistemas de transação de origem. Essa complexidade arquitetônica oferece a oportunidade de:

- Integre dados de várias fontes em um único banco de dados e modelo de dados. Mais concentração de dados em um único banco de dados, de forma que um único mecanismo de consulta possa ser usado para apresentar dados em um ODS.

- Mitigar o problema de contenção de bloqueio de nível de isolamento de banco de dados em sistemas de processamento de transações causado por tentativas de executar consultas de análise grandes e de longa execução em bancos de dados de processamento de transações.

- Mantenha o histórico de dados , mesmo que os sistemas de transação de origem não o façam.

- Integre dados de vários sistemas de origem, permitindo uma visão central em toda a empresa. Esse benefício é sempre valioso, mas especialmente quando a organização cresceu por fusão.

- Melhore a qualidade dos dados , fornecendo códigos e descrições consistentes, sinalizando ou até corrigindo dados incorretos.

- Apresente as informações da organização de forma consistente.

- Fornece um único modelo de dados comum para todos os dados de interesse, independentemente da fonte dos dados.

- Reestruture os dados para que façam sentido para os usuários de negócios.

- Reestruture os dados para que forneçam excelente desempenho de consulta, mesmo para consultas analíticas complexas, sem impactar os sistemas operacionais .

- Agregue valor aos aplicativos operacionais de negócios, principalmente aos sistemas de gerenciamento de relacionamento com o cliente (CRM).

- Torne as consultas de suporte à decisão mais fáceis de escrever.

- Organize e elimine a ambiguidade de dados repetitivos

Genérico

O ambiente para data warehouses e marts inclui o seguinte:

- Sistemas de origem que fornecem dados para o warehouse ou mart;

- Tecnologia de integração de dados e processos necessários para preparar os dados para uso;

- Diferentes arquiteturas para armazenar dados no data warehouse ou data marts de uma organização;

- Diferentes ferramentas e aplicativos para uma variedade de usuários;

- Metadados, qualidade de dados e processos de governança devem estar em vigor para garantir que o warehouse ou mart atenda a seus objetivos.

Em relação aos sistemas de origem listados acima, R. Kelly Rainer afirma: "Uma fonte comum de dados em data warehouses são os bancos de dados operacionais da empresa, que podem ser bancos de dados relacionais".

Com relação à integração de dados, Rainer afirma: "É necessário extrair dados dos sistemas de origem, transformá-los e carregá-los em um data mart ou warehouse".

Rainer discute o armazenamento de dados no data warehouse ou data marts de uma organização.

Metadados são dados sobre dados. "O pessoal de TI precisa de informações sobre fontes de dados; nomes de bancos de dados, tabelas e colunas; cronogramas de atualização e medidas de uso de dados".

Hoje, as empresas mais bem-sucedidas são aquelas que podem responder com rapidez e flexibilidade às mudanças e oportunidades do mercado. Uma chave para essa resposta é o uso eficaz e eficiente de dados e informações por analistas e gerentes. Um "data warehouse" é um repositório de dados históricos que é organizado pelo assunto para apoiar os tomadores de decisão na organização. Depois que os dados são armazenados em um data mart ou warehouse, eles podem ser acessados.

Sistemas relacionados (data mart, OLAPS, OLTP, análise preditiva)

Um data mart é uma forma simples de data warehouse que se concentra em um único assunto (ou área funcional), portanto, eles extraem dados de um número limitado de fontes, como vendas, finanças ou marketing. Os data marts são geralmente criados e controlados por um único departamento de uma organização. As fontes podem ser sistemas operacionais internos, um data warehouse central ou dados externos. A desnormalização é a norma para as técnicas de modelagem de dados neste sistema. Dado que os data marts geralmente cobrem apenas um subconjunto dos dados contidos em um data warehouse, eles geralmente são mais fáceis e rápidos de implementar.

| Atributo | Armazém de dados | Data mart |

|---|---|---|

| Escopo dos dados | em toda a empresa | todo o departamento |

| Número de áreas temáticas | múltiplo | solteiro |

| Quão difícil de construir | difícil | fácil |

| Quanto tempo leva para construir | mais | menos |

| Quantidade de memória | maior | limitado |

Os tipos de data marts incluem data marts dependentes , independentes e híbridos.

O processamento analítico online (OLAP) é caracterizado por um volume relativamente baixo de transações. As consultas costumam ser muito complexas e envolvem agregações. Para sistemas OLAP, o tempo de resposta é uma medida eficaz. Os aplicativos OLAP são amplamente usados por técnicas de Data Mining . Os bancos de dados OLAP armazenam dados históricos agregados em esquemas multidimensionais (geralmente esquemas em estrela ). Os sistemas OLAP normalmente têm uma latência de dados de algumas horas, ao contrário dos data marts, em que a latência deve ser próxima a um dia. A abordagem OLAP é usada para analisar dados multidimensionais de várias fontes e perspectivas. As três operações básicas no OLAP são Roll-up (Consolidação), Drill-down e Slicing & Dicing.

O processamento de transações online (OLTP) é caracterizado por um grande número de transações curtas online (INSERT, UPDATE, DELETE). Os sistemas OLTP enfatizam o processamento de consultas muito rápido e a manutenção da integridade dos dados em ambientes de multi-acesso. Para sistemas OLTP, a eficácia é medida pelo número de transações por segundo. Os bancos de dados OLTP contêm dados detalhados e atuais. O esquema usado para armazenar bancos de dados transacionais é o modelo de entidade (geralmente 3NF ). A normalização é a norma para técnicas de modelagem de dados neste sistema.

A análise preditiva trata de encontrar e quantificar padrões ocultos nos dados usando modelos matemáticos complexos que podem ser usados para prever resultados futuros. A análise preditiva é diferente do OLAP porque o OLAP se concentra na análise de dados históricos e é reativa por natureza, enquanto a análise preditiva se concentra no futuro. Esses sistemas também são usados para gerenciamento de relacionamento com o cliente (CRM).

História

O conceito de data warehouse remonta ao final dos anos 1980, quando os pesquisadores da IBM, Barry Devlin e Paul Murphy, desenvolveram o "data warehouse de negócios". Em essência, o conceito de armazenamento de dados pretendia fornecer um modelo de arquitetura para o fluxo de dados de sistemas operacionais para ambientes de suporte à decisão . O conceito tentou abordar os vários problemas associados a esse fluxo, principalmente os altos custos associados a ele. Na ausência de uma arquitetura de data warehouse, uma enorme quantidade de redundância era necessária para dar suporte a vários ambientes de suporte à decisão. Em corporações maiores, era comum que vários ambientes de suporte à decisão operassem de forma independente. Embora cada ambiente atendesse a usuários diferentes, eles geralmente exigiam muitos dos mesmos dados armazenados. O processo de coleta, limpeza e integração de dados de várias fontes, geralmente de sistemas operacionais existentes de longo prazo (geralmente chamados de sistemas legados ), foi normalmente em parte replicado para cada ambiente. Além disso, os sistemas operacionais eram frequentemente reexaminados à medida que surgiam novos requisitos de suporte à decisão. Freqüentemente, novos requisitos exigiam a coleta, limpeza e integração de novos dados de " data marts " que eram adaptados para o pronto acesso dos usuários.

Além disso, com a publicação de The IRM Imperative (Wiley & Sons, 1991) por James M. Kerr, a ideia de gerenciar e atribuir um valor monetário aos recursos de dados de uma organização e, em seguida, relatar esse valor como um ativo em um balanço patrimonial tornou-se popular . No livro, Kerr descreveu uma maneira de preencher bancos de dados de área de assunto a partir de dados derivados de sistemas orientados a transações para criar uma área de armazenamento onde dados de resumo poderiam ser aproveitados para informar a tomada de decisão executiva. Este conceito serviu para promover a reflexão sobre como um data warehouse poderia ser desenvolvido e gerenciado de forma prática em qualquer empresa.

Principais desenvolvimentos nos primeiros anos de armazenamento de dados:

- Década de 1960 - General Mills e Dartmouth College , em um projeto de pesquisa conjunto, desenvolvem os termos dimensões e fatos .

- Década de 1970 - ACNielsen e IRI fornecem data marts dimensionais para vendas no varejo.

- Década de 1970 - Bill Inmon começa a definir e discutir o termo Data Warehouse.

- 1975 - Sperry Univac introduz MAPPER (manter, preparar e produzir relatórios executivos), uma gestão de banco de dados e sistema de comunicação que inclui o primeiro do mundo 4GL . É a primeira plataforma projetada para a construção de Centros de Informações (um precursor da tecnologia contemporânea de data warehouse).

- 1983 - A Teradata apresenta o computador de banco de dados DBC / 1012 projetado especificamente para suporte à decisão.

- 1984 - Metaphor Computer Systems , fundada por David Liddle e Don Massaro, lança um pacote de hardware / software e GUI para usuários de negócios criarem um sistema analítico e de gerenciamento de banco de dados.

- 1985 - Sperry Corporation publica um artigo (Martyn Jones e Philip Newman) sobre centros de informação, onde eles introduzem o termo armazém de dados MAPPER no contexto de centros de informação.

- 1988 - Barry Devlin e Paul Murphy publicam o artigo "Uma arquitetura para um sistema de negócios e informações", onde introduzem o termo "data warehouse de negócios".

- 1990 - A Red Brick Systems, fundada por Ralph Kimball , apresenta o Red Brick Warehouse, um sistema de gerenciamento de banco de dados específico para data warehouse.

- 1991 - James M. Kerr autores The IRM Imperative, que sugere que os recursos de dados podem ser relatados como um ativo em um balanço patrimonial, promovendo o interesse comercial no estabelecimento de data warehouses.

- 1991 - Prism Solutions, fundada por Bill Inmon , apresenta o Prism Warehouse Manager, software para o desenvolvimento de um data warehouse.

- 1992 - Bill Inmon publica o livro Building the Data Warehouse .

- 1995 - é fundado o Data Warehousing Institute, uma organização com fins lucrativos que promove o armazenamento de dados.

- 1996 - Ralph Kimball publica o livro The Data Warehouse Toolkit .

- 2000 - Dan Linstedt lança no domínio público a modelagem de cofre de dados , concebida em 1990 como uma alternativa ao Inmon e Kimball para fornecer armazenamento histórico de longo prazo de dados provenientes de vários sistemas operacionais, com ênfase no rastreamento, auditoria e resiliência à mudança do modelo de dados de origem.

- 2008 - Bill Inmon , junto com Derek Strauss e Genia Neushloss, publica "DW 2.0: A Arquitetura para a Próxima Geração de Data Warehousing", explicando sua abordagem de cima para baixo para data warehouse e cunhando o termo, data-warehousing 2.0.

- 2012 - Bill Inmon desenvolve e torna pública a tecnologia conhecida como "desambiguação textual". A desambiguação textual aplica contexto ao texto bruto e reformata o texto bruto e o contexto em um formato de banco de dados padrão. Depois que o texto bruto passa pela desambiguação textual, ele pode ser acessado e analisado de maneira fácil e eficiente por tecnologia de inteligência de negócios padrão. A desambiguação textual é realizada por meio da execução de ETL textual. A desambiguação textual é útil onde quer que seja encontrado texto bruto, como em documentos, Hadoop, e-mail e assim por diante.

Armazenamento de informação

Fatos

Um fato é um valor, ou medida, que representa um fato sobre a entidade ou sistema gerenciado.

Os fatos, conforme relatados pela entidade que relata, são considerados em nível bruto; por exemplo, em um sistema de telefonia móvel, se um BTS ( estação transceptora de base ) recebe 1.000 solicitações de alocação de canal de tráfego, aloca para 820 e rejeita o restante, ele relataria três fatos ou medições a um sistema de gestão:

tch_req_total = 1000tch_req_success = 820tch_req_fail = 180

Os fatos no nível bruto são ainda agregados a níveis mais altos em várias dimensões para extrair mais serviços ou informações relevantes para os negócios deles . Eles são chamados de agregados ou resumos ou fatos agregados.

Por exemplo, se houver três BTS em uma cidade, os fatos acima podem ser agregados do BTS ao nível da cidade na dimensão da rede. Por exemplo:

tch_req_success_city = tch_req_success_bts1 + tch_req_success_bts2 + tch_req_success_bts3avg_tch_req_success_city = (tch_req_success_bts1 + tch_req_success_bts2 + tch_req_success_bts3) / 3

Abordagem dimensional versus abordagem normalizada para armazenamento de dados

Existem três ou mais abordagens principais para armazenar dados em um data warehouse - as abordagens mais importantes são a abordagem dimensional e a abordagem normalizada.

A abordagem dimensional se refere à abordagem de Ralph Kimball em que afirma que o data warehouse deve ser modelado usando um modelo dimensional / esquema estrela . A abordagem normalizada, também chamada de modelo 3NF (Terceira Forma Normal), refere-se à abordagem de Bill Inmon na qual é afirmado que o data warehouse deve ser modelado usando um modelo ER / modelo normalizado.

Abordagem dimensional

Em uma abordagem dimensional , os dados da transação são particionados em "fatos", que geralmente são dados de transações numéricos, e " dimensões ", que são as informações de referência que fornecem contexto aos fatos. Por exemplo, uma transação de vendas pode ser dividida em fatos como o número de produtos pedidos e o preço total pago pelos produtos e em dimensões como data do pedido, nome do cliente, número do produto, pedido de envio e faturado locais e vendedor responsável por receber o pedido.

A principal vantagem de uma abordagem dimensional é que o data warehouse é mais fácil para o usuário entender e usar. Além disso, a recuperação de dados do data warehouse tende a operar muito rapidamente. As estruturas dimensionais são fáceis de entender para usuários de negócios, porque a estrutura é dividida em medidas / fatos e contexto / dimensões. Os fatos estão relacionados aos processos de negócios e sistema operacional da organização, enquanto as dimensões que os cercam contêm contexto sobre a medição (Kimball, Ralph 2008). Outra vantagem oferecida pelo modelo dimensional é que ele não envolve um banco de dados relacional todas as vezes. Portanto, esse tipo de técnica de modelagem é muito útil para consultas do usuário final em data warehouse.

O modelo de fatos e dimensões também pode ser entendido como um cubo de dados . Onde as dimensões são as coordenadas categóricas em um cubo multidimensional, o fato é um valor correspondente às coordenadas.

As principais desvantagens da abordagem dimensional são as seguintes:

- Para manter a integridade dos fatos e dimensões, é complicado carregar o data warehouse com dados de diferentes sistemas operacionais.

- É difícil modificar a estrutura do data warehouse se a organização que adota a abordagem dimensional mudar a maneira como faz negócios.

Abordagem normalizada

Na abordagem normalizada, os dados no data warehouse são armazenados seguindo, até certo ponto, as regras de normalização do banco de dados . As tabelas são agrupadas por áreas temáticas que refletem categorias gerais de dados (por exemplo, dados sobre clientes, produtos, finanças, etc.). A estrutura normalizada divide os dados em entidades, o que cria várias tabelas em um banco de dados relacional. Quando aplicado em grandes empresas, o resultado são dezenas de tabelas que são interligadas por uma teia de junções. Além disso, cada uma das entidades criadas é convertida em tabelas físicas separadas quando o banco de dados é implementado (Kimball, Ralph 2008). A principal vantagem dessa abordagem é que é simples adicionar informações ao banco de dados. Algumas desvantagens dessa abordagem são que, devido ao número de tabelas envolvidas, pode ser difícil para os usuários juntar dados de diferentes fontes em informações significativas e acessar as informações sem um entendimento preciso das fontes e da estrutura de dados do data warehouse.

Os modelos normalizados e dimensionais podem ser representados em diagramas de relacionamento de entidade, pois ambos contêm tabelas relacionais unidas. A diferença entre os dois modelos é o grau de normalização (também conhecido como Formas normais ). Essas abordagens não são mutuamente exclusivas e existem outras abordagens. As abordagens dimensionais podem envolver a normalização de dados até certo ponto (Kimball, Ralph 2008).

Em Negócios Orientados a Informações , Robert Hillard propõe uma abordagem para comparar as duas abordagens com base nas necessidades de informações do problema de negócios. A técnica mostra que os modelos normalizados contêm muito mais informações do que seus equivalentes dimensionais (mesmo quando os mesmos campos são usados em ambos os modelos), mas essas informações extras têm um custo de usabilidade. A técnica mede a quantidade de informação em termos de entropia de informação e usabilidade em termos da medida de transformação de dados de Small Worlds.

Métodos de design

Design de baixo para cima

Na abordagem ascendente , os data marts são criados primeiro para fornecer relatórios e recursos analíticos para processos de negócios específicos . Esses data marts podem então ser integrados para criar um data warehouse abrangente. A arquitetura de barramento de data warehouse é principalmente uma implementação do "barramento", uma coleção de dimensões e fatos conformados , que são dimensões que são compartilhadas (de uma maneira específica) entre fatos em dois ou mais data marts.

Design de cima para baixo

A abordagem de cima para baixo é projetada usando um modelo de dados corporativos normalizado . Os dados "atômicos" , ou seja, os dados no maior nível de detalhe, são armazenados no data warehouse. Data marts dimensionais contendo dados necessários para processos de negócios específicos ou departamentos específicos são criados a partir do data warehouse.

Design híbrido

Armazéns de dados (DW) muitas vezes se assemelham à arquitetura de hub e spokes . Os sistemas legados que alimentam o warehouse geralmente incluem gerenciamento de relacionamento com o cliente e planejamento de recursos corporativos , gerando grandes quantidades de dados. Para consolidar esses vários modelos de dados e facilitar o processo de carregamento da transformação de extração , os data warehouses costumam usar um armazenamento de dados operacional , cujas informações são analisadas no DW real. Para reduzir a redundância de dados, sistemas maiores geralmente armazenam os dados de forma normalizada. Os data marts para relatórios específicos podem ser construídos no topo do data warehouse.

Um banco de dados DW híbrido é mantido na terceira forma normal para eliminar a redundância de dados . Um banco de dados relacional normal, entretanto, não é eficiente para relatórios de inteligência de negócios onde a modelagem dimensional é predominante. Pequenos data marts podem comprar dados do warehouse consolidado e usar os dados filtrados e específicos para as tabelas de fatos e dimensões necessárias. O DW fornece uma única fonte de informações a partir da qual os data marts podem ler, fornecendo uma ampla gama de informações de negócios. A arquitetura híbrida permite que um DW seja substituído por um repositório de gerenciamento de dados mestre onde podem residir informações operacionais (não estáticas).

Os componentes de modelagem do cofre de dados seguem a arquitetura hub e spokes. Este estilo de modelagem é um design híbrido, consistindo nas melhores práticas da terceira forma normal e do esquema em estrela . O modelo de cofre de dados não é uma verdadeira terceira forma normal e quebra algumas de suas regras, mas é uma arquitetura de cima para baixo com um design de baixo para cima. O modelo de cofre de dados é projetado para ser estritamente um data warehouse. Ele não foi projetado para ser acessível ao usuário final, o que, quando construído, ainda requer o uso de um data mart ou área de liberação baseada em esquema em estrela para fins comerciais.

Características do data warehouse

Existem recursos básicos que definem os dados no data warehouse que incluem orientação do assunto, integração de dados, variação de tempo, dados não voláteis e granularidade de dados.

Orientado para o assunto

Ao contrário dos sistemas operacionais, os dados no data warehouse giram em torno de assuntos da empresa. A orientação do assunto não é normalização do banco de dados . A orientação do assunto pode ser muito útil para a tomada de decisões. Reunir os objetos necessários é denominado orientado para o assunto.

Integrado

Os dados encontrados no data warehouse são integrados. Como se trata de vários sistemas operacionais, todas as inconsistências devem ser removidas. As consistências incluem convenções de nomenclatura, medição de variáveis, estruturas de codificação, atributos físicos de dados e assim por diante.

Tempo variável

Enquanto os sistemas operacionais refletem os valores atuais à medida que suportam as operações do dia a dia, os dados do data warehouse representam um longo horizonte de tempo (até 10 anos), o que significa que armazena principalmente dados históricos. Destina-se principalmente a mineração de dados e previsão. (Por exemplo, se um usuário está procurando um padrão de compra de um cliente específico, o usuário precisa olhar os dados sobre as compras atuais e anteriores.)

Não volátil

Os dados no data warehouse são somente leitura, o que significa que não podem ser atualizados, criados ou excluídos (a menos que haja uma obrigação regulamentar ou estatutária de fazê-lo).

Opções de data warehouse

Agregação

No processo de data warehouse, os dados podem ser agregados em data marts em diferentes níveis de abstração. O usuário pode começar a olhar para o total de unidades de venda de um produto em uma região inteira. Em seguida, o usuário observa os estados dessa região. Finalmente, eles podem examinar as lojas individuais em um determinado estado. Portanto, normalmente, a análise começa em um nível superior e se aprofunda em níveis inferiores de detalhes.

Arquitetura de data warehouse

Os diferentes métodos usados para construir / organizar um data warehouse especificado por uma organização são numerosos. O hardware utilizado, o software criado e os recursos de dados especificamente necessários para a funcionalidade correta de um data warehouse são os principais componentes da arquitetura do data warehouse. Todos os data warehouses têm várias fases nas quais os requisitos da organização são modificados e ajustados.

Versus sistema operacional

Os sistemas operacionais são otimizados para a preservação da integridade dos dados e velocidade de registro das transações comerciais por meio do uso da normalização do banco de dados e de um modelo de relacionamento entre entidades . Os designers de sistemas operacionais geralmente seguem as 12 regras de normalização de banco de dados de Codd para garantir a integridade dos dados. Projetos de banco de dados totalmente normalizados (ou seja, aqueles que satisfazem todas as regras Codd) geralmente resultam em informações de uma transação comercial sendo armazenadas em dezenas a centenas de tabelas. Os bancos de dados relacionais são eficientes no gerenciamento dos relacionamentos entre essas tabelas. Os bancos de dados têm um desempenho de inserção / atualização muito rápido porque apenas uma pequena quantidade de dados nessas tabelas é afetada cada vez que uma transação é processada. Para melhorar o desempenho, os dados mais antigos geralmente são removidos periodicamente dos sistemas operacionais.

Os armazéns de dados são otimizados para padrões de acesso analítico. Os padrões de acesso analítico geralmente envolvem a seleção de campos específicos e, raramente, se nunca select *, o que seleciona todos os campos / colunas, como é mais comum em bancos de dados operacionais. Devido a essas diferenças nos padrões de acesso, os bancos de dados operacionais (vagamente, OLTP) se beneficiam do uso de um SGBD orientado a linhas, enquanto os bancos de dados analíticos (vagamente, OLAP) se beneficiam do uso de um SGBD orientado a colunas . Ao contrário dos sistemas operacionais que mantêm um instantâneo do negócio, os data warehouses geralmente mantêm um histórico infinito que é implementado por meio de processos ETL que migram periodicamente os dados dos sistemas operacionais para o data warehouse.

Evolução no uso da organização

Esses termos se referem ao nível de sofisticação de um data warehouse:

- Data warehouse operacional offline

- Os data warehouses neste estágio de evolução são atualizados em um ciclo de tempo regular (geralmente diário, semanal ou mensal) a partir dos sistemas operacionais e os dados são armazenados em um banco de dados integrado orientado a relatórios.

- Data warehouse offline

- Nesse estágio, os data warehouses são atualizados regularmente a partir dos dados dos sistemas operacionais e os dados do data warehouse são armazenados em uma estrutura de dados projetada para facilitar a geração de relatórios.

- Data warehouse no prazo

- Data Warehousing Integrado Online representa os dados de estágio de Data warehouses em tempo real no warehouse são atualizados para cada transação realizada nos dados de origem

- Armazém de dados integrado

- Esses data warehouses reúnem dados de diferentes áreas de negócios, para que os usuários possam consultar as informações de que precisam em outros sistemas.

Referências

Leitura adicional

- Davenport, Thomas H. e Harris, Jeanne G. Competindo em Analytics: The New Science of Winning (2007) Harvard Business School Press. ISBN 978-1-4221-0332-6

- Ganczarski, Joe. Implementações de Data Warehouse: Estudo de Fatores de Implementação Críticos (2009) VDM Verlag ISBN 3-639-18589-7 ISBN 978-3-639-18589-8

- Kimball, Ralph e Ross, Margy. The Data Warehouse Toolkit Third Edition (2013) Wiley, ISBN 978-1-118-53080-1

- Linstedt, Graziano, Hultgren. The Business of Data Vault Modeling Second Edition (2010) Dan linstedt, ISBN 978-1-4357-1914-9

- William Inmon. Construindo o Data Warehouse (2005) John Wiley and Sons, ISBN 978-81-265-0645-3