Interferência catastrófica - Catastrophic interference

A interferência catastrófica , também conhecida como esquecimento catastrófico , é a tendência de uma rede neural artificial de esquecer completa e abruptamente as informações aprendidas anteriormente ao aprender novas informações. As redes neurais são uma parte importante da abordagem de rede e da abordagem conexionista às ciências cognitivas . Com essas redes, as capacidades humanas, como memória e aprendizado, podem ser modeladas por meio de simulações de computador. A interferência catastrófica é uma questão importante a se considerar ao criar modelos conexionistas de memória. Ele foi originalmente trazido à atenção da comunidade científica pelas pesquisas de McCloskey e Cohen (1989) e Ratcliff (1990). É uma manifestação radical do dilema 'sensibilidade-estabilidade' ou do dilema 'estabilidade-plasticidade'. Especificamente, esses problemas referem-se ao desafio de fazer uma rede neural artificial que seja sensível a, mas não interrompida por, novas informações. As tabelas de pesquisa e as redes conexionistas ficam nos lados opostos do espectro de plasticidade da estabilidade. O primeiro permanece completamente estável na presença de novas informações, mas não tem a capacidade de generalizar , ou seja, inferir princípios gerais, a partir de novas entradas. Por outro lado, as redes conexionistas, como a rede backpropagation padrão, podem generalizar para entradas invisíveis, mas são muito sensíveis a novas informações. Os modelos de retropropagação podem ser considerados bons modelos de memória humana, na medida em que refletem a capacidade humana de generalizar, mas essas redes geralmente exibem menos estabilidade do que a memória humana. Notavelmente, essas redes de retropropagação são suscetíveis a interferências catastróficas. Esse é um problema ao modelar a memória humana, porque, ao contrário dessas redes, os humanos normalmente não apresentam esquecimento catastrófico.

História de interferência catastrófica

O termo interferência catastrófica foi originalmente cunhado por McCloskey e Cohen (1989), mas também foi trazido à atenção da comunidade científica por pesquisas de Ratcliff (1990).

O problema de aprendizagem sequencial : McCloskey e Cohen (1989)

McCloskey e Cohen (1989) observaram o problema da interferência catastrófica durante dois experimentos diferentes com modelagem de rede neural de retropropagação.

- Experimento 1: aprender os fatos da adição de um e dois

Em seu primeiro experimento, eles treinaram uma rede neural de retropropagação padrão em um único conjunto de treinamento que consiste em 17 problemas de um dígito (ou seja, 1 + 1 a 9 + 1 e 1 + 2 a 1 + 9) até que a rede pudesse representar e responder adequadamente a todos eles. O erro entre a saída real e a saída desejada diminuiu continuamente nas sessões de treinamento, o que refletiu que a rede aprendeu a representar melhor as saídas alvo nas tentativas. Em seguida, eles treinaram a rede em um único conjunto de treinamento consistindo em 17 problemas de dois dígitos de um dígito (ou seja, 2 + 1 a 2 + 9 e 1 + 2 a 9 + 2) até que a rede pudesse representar, responder adequadamente a todos eles. Eles observaram que seu procedimento era semelhante a como uma criança aprenderia seus fatos de adição. Após cada tentativa de aprendizagem nos fatos dos dois, a rede foi testada quanto ao seu conhecimento nos fatos de adição um e dois. Como aqueles fatos, os dois fatos foram prontamente aprendidos pela rede. No entanto, McCloskey e Cohen observaram que a rede não era mais capaz de responder adequadamente aos problemas de adição de um, mesmo após uma tentativa de aprendizado dos dois problemas de adição. O padrão de saída produzido em resposta a esses fatos muitas vezes se assemelhava mais a um padrão de saída para um número incorreto do que o padrão de saída para um número correto. Isso é considerado uma quantidade drástica de erro. Além disso, os problemas 2 + 1 e 2 + 1, que foram incluídos em ambos os conjuntos de treinamento, até mesmo mostraram uma interrupção dramática durante as primeiras tentativas de aprendizagem dos dois fatos.

- Experimento 2: Replicação do estudo de Barnes e Underwood (1959) Em seu segundo modelo conexionista, McCloskey e Cohen tentaram replicar o estudo sobre interferência retroativa em humanos de Barnes e Underwood (1959). Eles treinaram o modelo nas listas AB e AC e usaram um padrão de contexto no vetor de entrada (padrão de entrada) para diferenciar as listas. Especificamente, a rede foi treinada para responder com a resposta B certa quando mostrado o estímulo A e o padrão de contexto AB e para responder com a resposta C correta quando mostrado o estímulo A e o padrão de contexto AC. Quando o modelo foi treinado simultaneamente nos itens AB e AC, a rede aprendeu prontamente todas as associações corretamente. No treinamento sequencial, a lista AB foi treinada primeiro, seguida pela lista AC. Após cada apresentação da lista AC, o desempenho foi medido para as listas AB e AC. Eles descobriram que a quantidade de treinamento na lista AC no estudo de Barnes and Underwood que leva a 50% de respostas corretas, leva a quase 0% de respostas corretas pela rede de retropropagação. Além disso, eles descobriram que a rede tendia a mostrar respostas que se pareciam com o padrão de resposta C quando a rede era solicitada a fornecer o padrão de resposta B. Isso indicou que a lista AC aparentemente substituiu a lista AB. Isso pode ser comparado a aprender a palavra cachorro, seguido de aprender a palavra banquinho e então descobrir que você não consegue reconhecer a palavra gato bem, mas, em vez disso, pensa na palavra banquinho quando apresentada com a palavra cachorro.

McCloskey e Cohen tentaram reduzir a interferência por meio de uma série de manipulações, incluindo alteração do número de unidades ocultas, alteração do valor do parâmetro de taxa de aprendizagem, overtraining na lista AB, congelamento de certos pesos de conexão, alteração dos valores alvo 0 e 1 em vez de 0,1 e 0,9 . No entanto, nenhuma dessas manipulações reduziu satisfatoriamente a interferência catastrófica exibida pelas redes.

No geral, McCloskey e Cohen (1989) concluíram que:

- pelo menos alguma interferência ocorrerá sempre que um novo aprendizado alterar os pesos envolvidos, representando

- quanto maior for a quantidade de novo aprendizado, maior será a interrupção do antigo conhecimento

- a interferência foi catastrófica nas redes de retropropagação quando a aprendizagem era sequencial, mas não simultânea

Restrições impostas por funções de aprendizagem e esquecimento : Ratcliff (1990)

Ratcliff (1990) usou vários conjuntos de modelos de retropropagação aplicados a procedimentos de memória de reconhecimento padrão, nos quais os itens foram aprendidos sequencialmente. Depois de inspecionar os modelos de desempenho de reconhecimento, ele encontrou dois problemas principais:

- Informações bem aprendidas foram catastroficamente esquecidas à medida que novas informações eram aprendidas em pequenas e grandes redes de retropropagação.

Mesmo um teste de aprendizagem com novas informações resultou em uma perda significativa das informações antigas, em paralelo com as descobertas de McCloskey e Cohen (1989). Ratcliff também descobriu que as saídas resultantes eram freqüentemente uma mistura da entrada anterior e da nova entrada. Em redes maiores, os itens aprendidos em grupos (por exemplo, AB, em seguida, CD) eram mais resistentes ao esquecimento do que os itens aprendidos individualmente (por exemplo, A, em seguida, B, em seguida, C ...). No entanto, o esquecimento de itens aprendidos em grupos ainda era grande. Adicionar novas unidades ocultas à rede não reduziu a interferência.

- A discriminação entre os itens estudados e itens não vistos anteriormente diminuiu à medida que a rede aprendeu mais.

Esse achado contradiz estudos sobre memória humana, que indicaram que a discriminação aumenta com o aprendizado. Ratcliff tentou aliviar esse problema adicionando 'nós de resposta' que responderiam seletivamente a entradas novas e antigas. No entanto, esse método não funcionou porque esses nós de resposta se tornariam ativos para todas as entradas. Um modelo que usava um padrão de contexto também falhou em aumentar a discriminação entre itens novos e antigos.

Soluções propostas

A principal causa da interferência catastrófica parece ser a sobreposição nas representações na camada oculta das redes neurais distribuídas. Em uma representação distribuída, cada entrada tende a criar mudanças nos pesos de muitos dos nós. O esquecimento catastrófico ocorre porque quando muitos dos pesos onde "o conhecimento é armazenado" são alterados, é improvável que o conhecimento anterior seja mantido intacto. Durante o aprendizado sequencial, as entradas se misturam, com as novas entradas sendo sobrepostas às antigas. Outra forma de conceituar isso é visualizando a aprendizagem como um movimento através de um espaço de peso. Este espaço de pesos pode ser comparado a uma representação espacial de todas as combinações possíveis de pesos que a rede poderia possuir. Quando uma rede primeiro aprende a representar um conjunto de padrões, ela encontra um ponto no espaço de peso que lhe permite reconhecer todos esses padrões. No entanto, quando a rede aprender um novo conjunto de padrões, ela se moverá para um lugar no espaço de peso para o qual a única preocupação é o reconhecimento dos novos padrões. Para reconhecer os dois conjuntos de padrões, a rede deve encontrar um lugar no espaço de peso adequado para reconhecer os padrões novos e antigos.

Abaixo estão uma série de técnicas que têm suporte empírico para reduzir com sucesso a interferência catastrófica em redes neurais de retropropagação:

Ortogonalidade

Muitas das primeiras técnicas para reduzir a sobreposição representacional envolviam tornar os vetores de entrada ou os padrões de ativação da unidade oculta ortogonais entre si. Lewandowsky e Li (1995) notaram que a interferência entre os padrões aprendidos sequencialmente é minimizada se os vetores de entrada forem ortogonais entre si. Os vetores de entrada são ortogonais entre si se o produto dos pares de seus elementos nos dois vetores somam zero. Por exemplo, os padrões [0,0,1,0] e [0,1,0,0] são considerados ortogonais porque (0 × 0 + 0 × 1 + 1 × 0 + 0 × 0) = 0. Uma das técnicas que podem criar representações ortogonais nas camadas ocultas envolve a codificação de características bipolares (ou seja, codificação usando -1 e 1 em vez de 0 e 1). Os padrões ortogonais tendem a produzir menos interferência uns com os outros. No entanto, nem todos os problemas de aprendizagem podem ser representados usando esses tipos de vetores e alguns estudos relatam que o grau de interferência ainda é problemático com vetores ortogonais.

Técnica de nitidez de nó

De acordo com French (1991), a interferência catastrófica surge em redes de retropropagação feedforward devido à interação de ativações de nós, ou sobreposição de ativação, que ocorre em representações distribuídas na camada oculta. Redes neurais que empregam representações muito localizadas não mostram interferência catastrófica devido à falta de sobreposição na camada oculta. French, portanto, sugeriu que reduzir o valor da sobreposição de ativação na camada oculta reduziria a interferência catastrófica em redes distribuídas. Especificamente, ele propôs que isso poderia ser feito mudando as representações distribuídas na camada oculta para representações "semidistribuídas". Uma representação 'semi-distribuída' tem menos nós ocultos que estão ativos, e / ou um valor de ativação inferior para esses nós, para cada representação, o que fará com que as representações das diferentes entradas se sobreponham menos na camada oculta. French recomendou que isso poderia ser feito por meio de 'nitidez de ativação', uma técnica que aumenta ligeiramente a ativação de um certo número de nós mais ativos na camada oculta, reduz ligeiramente a ativação de todas as outras unidades e, em seguida, altera a entrada para - Pesos de camada ocultos para refletir essas alterações de ativação (semelhante à retropropagação de erro).

Regra da novidade

Kortge (1990) propôs uma regra de aprendizagem para treinar redes neurais, chamada de 'regra da novidade', para ajudar a aliviar a interferência catastrófica. Como o próprio nome sugere, essa regra ajuda a rede neural a aprender apenas os componentes de uma nova entrada que diferem de uma entrada antiga. Consequentemente, a regra da novidade altera apenas os pesos que não eram anteriormente dedicados ao armazenamento de informações, reduzindo assim a sobreposição de representações nas unidades ocultas. Para aplicar a regra da novidade, durante o aprendizado, o padrão de entrada é substituído por um vetor de novidade que representa os componentes que diferem. Quando a regra da novidade é usada em uma rede de retropropagação padrão, não há, ou é reduzido, o esquecimento de itens antigos quando novos itens são apresentados sequencialmente. No entanto, uma limitação é que essa regra só pode ser usada com autocodificadores ou redes autoassociativas, nas quais a resposta de destino para a camada de saída é idêntica ao padrão de entrada.

Redes de pré-treinamento

McRae e Hetherington (1993) argumentaram que os humanos, ao contrário da maioria das redes neurais, não assumem novas tarefas de aprendizagem com um conjunto aleatório de pesos. Em vez disso, as pessoas tendem a trazer uma riqueza de conhecimento prévio para uma tarefa e isso ajuda a evitar o problema de interferência. Eles mostraram que, quando uma rede é pré-treinada em uma amostra aleatória de dados antes de iniciar uma tarefa de aprendizagem sequencial, esse conhecimento prévio irá naturalmente restringir como as novas informações podem ser incorporadas. Isso ocorreria porque uma amostra aleatória de dados de um domínio com alto grau de estrutura interna, como o idioma inglês, o treinamento capturaria as regularidades, ou padrões recorrentes, encontrados nesse domínio. Como o domínio é baseado em regularidades, um item recém-aprendido tenderá a ser semelhante à informação aprendida anteriormente, o que permitirá que a rede incorpore novos dados com pouca interferência nos dados existentes. Especificamente, um vetor de entrada que segue o mesmo padrão de regularidades que os dados previamente treinados não deve causar um padrão drasticamente diferente de ativação na camada oculta ou alterar drasticamente os pesos.

Ensaio

Robins (1995) descreveu que o esquecimento catastrófico pode ser evitado por mecanismos de ensaio. Isso significa que, quando novas informações são adicionadas, a rede neural é retreinada em algumas das informações aprendidas anteriormente. Em geral, entretanto, as informações aprendidas anteriormente podem não estar disponíveis para esse retreinamento. Uma solução para isso é o "pseudo-ensaio", no qual a rede não é retreinada nos dados anteriores reais, mas nas representações deles. Vários métodos são baseados neste mecanismo geral.

Redes pseudo-recorrentes

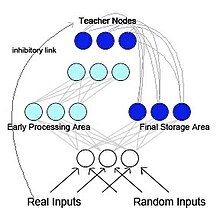

French (1997) propôs uma rede de retropropagação pseudo-recorrente (ver Figura 2). Neste modelo, a rede é separada em duas sub-redes funcionalmente distintas, mas interagindo. Este modelo é inspirado biologicamente e é baseado na pesquisa de McClelland et al. (1995) McClelland e colegas sugeriram que o hipocampo e o neocórtex agem como sistemas de memória separáveis, mas complementares, com o hipocampo para armazenamento de memória de curto prazo e o neocórtex para armazenamento de memória de longo prazo . As informações inicialmente armazenadas no hipocampo podem ser "transferidas" para o neocórtex por meio de reativação ou reprodução. Na rede pseudo-recorrente, uma das sub-redes atua como uma área de processamento inicial, semelhante ao hipocampo, e funciona para aprender novos padrões de entrada. A outra sub-rede atua como uma área de armazenamento final, semelhante ao neocórtex. No entanto, ao contrário do McClelland et al. (1995), a área de armazenamento final envia a representação gerada internamente de volta para a área de processamento inicial. Isso cria uma rede recorrente. French propôs que essa intercalação de velhas representações com novas representações é a única maneira de reduzir o esquecimento radical. Uma vez que o cérebro provavelmente não teria acesso aos padrões de entrada originais, os padrões que seriam realimentados para o neocórtex seriam representações geradas internamente, chamadas de pseudo-padrões . Esses pseudo-padrões são aproximações de entradas anteriores e podem ser intercalados com o aprendizado de novas entradas.

Memória auto-refrescante

Inspirado por e independentemente de Ans e Rousset (1997), também propôs uma arquitetura neural artificial de duas redes com auto-atualização de memória que supera a interferência catastrófica quando tarefas de aprendizagem sequenciais são realizadas em redes distribuídas treinadas por retropropagação. O princípio é aprender novos padrões externos simultaneamente com pseudopadrões gerados internamente, ou 'pseudo-memórias', que refletem a informação previamente aprendida. O que principalmente distingue este modelo daqueles que usam pseudo-ensaio clássico em redes multicamadas feedforward é um processo reverberante que é usado para gerar pseudopadrões. Depois de uma série de reinjeções de atividades de uma única semente aleatória, esse processo tende a subir para atratores de rede não lineares que são mais adequados para capturar de forma otimizada a estrutura profunda de conhecimento distribuída dentro de pesos de conexão do que a única passagem de feedforward de atividade usada em pseudo -ensaio. O procedimento de auto-renovação da memória revelou-se muito eficiente nos processos de transferência e no aprendizado serial de sequências temporais de padrões sem esquecimento catastrófico.

Repetição generativa

Nos últimos anos, o pseudo-ensaio voltou a ganhar popularidade graças ao progresso nas capacidades dos modelos generativos profundos . Quando esses modelos generativos profundos são usados para gerar os "pseudo-dados" a serem ensaiados, esse método é normalmente referido como reprodução generativa. Essa reprodução generativa pode prevenir efetivamente o esquecimento catastrófico, especialmente quando a reprodução é realizada nas camadas ocultas, em vez de no nível de entrada.

Aprendizagem latente

Aprendizagem latente é uma técnica usada por Gutstein & Stump (2015) para mitigar interferências catastróficas, aproveitando a aprendizagem por transferência . Essa abordagem tenta encontrar codificações ideais para quaisquer novas classes a serem aprendidas, de modo que sejam menos propensas a interferir catastroficamente nas respostas existentes. Dada uma rede que aprendeu a discriminar entre um conjunto de classes usando Error Correcting Output Codes (ECOC) (em oposição a 1 hot codes ), as codificações ótimas para novas classes são escolhidas observando-se as respostas médias da rede a elas. Uma vez que essas respostas médias surgiram durante o aprendizado do conjunto original de classes sem qualquer exposição às novas classes , elas são chamadas de 'Codificações Aprendidas Latentemente'. Esta terminologia toma emprestado o conceito de Latent Learning , introduzido por Tolman em 1930. Na verdade, esta técnica usa transferência de aprendizagem para evitar interferência catastrófica, tornando as respostas de uma rede para novas classes tão consistentes quanto possível com as respostas existentes para classes já aprendidas.

Consolidação de peso elástico

Kirkpatrick et al. (2017) propôs a consolidação de peso elástico (EWC), um método para treinar sequencialmente uma única rede neural artificial em várias tarefas. Essa técnica supõe que alguns pesos da rede neural treinada são mais importantes para tarefas aprendidas anteriormente do que outros. Durante o treinamento da rede neural em uma nova tarefa, as alterações nos pesos da rede tornam-se menos prováveis quanto maior sua importância. Para estimar a importância dos pesos da rede, o EWC usa mecanismos probabilísticos, em particular a matriz de informação de Fisher, mas isso também pode ser feito de outras maneiras.